热门问题

时间线

聊天

视角

人工智能哲學

来自维基百科,自由的百科全书

Remove ads

人工智能哲學是心智哲學和計算機科學的哲學的一個分支,[1]探討人工智能以及對知識、智力、倫理、意識、認識論和自由意志的理解。[2][3]此外,這項技術涉及創造人造動物或人造人(或至少是人造生物;參見人工生命),因此哲學家對這門學科相當感興趣。[4]這些因素促成了人工智能哲學的出現。

人工智能哲學試圖回答下列問題[5]:

這三個問題分別反映了人工智能開發者、語言學家、認知科學家和哲學家的不同興趣。透過討論 「智能」、「意識」的定義,和「機械」究竟是什麼,來尋找這些問題的科學答案。

人工智能哲學的重要主張包括:

Remove ads

機器能顯示一般智能嗎?

有沒有可能創造出一種能用人類智能解決所有問題的機器?這個問題指示了機器能力的範圍,指引着人工智能研究的方向。它只涉及機器的行為,而忽略了心理學、認知科學和哲學感興趣的問題,從而引發了這樣一個問題:機器是否真的像人一樣在思考,而非只是看上去在思考?這重要嗎?[11]

大多數AI研究者的基本立場可以用達特茅斯會議(1956)上的這句話概括:

- 「學習的所有方面,及智能的所有特徵,原則上都可以得到精確的描述,且可以製造一台機器來模擬。」[7]

反對這一基本前提的論點要說明,受限於計算機的實際能力,或者由於人類思維的某種智能行為必須的特殊品質,使得機器(或目前的人工智能研究方法)不可能複製人類智能,於是也不可能建立一個有效的人工智能系統。支持這一基本前提的論證要說明,這種系統是可能存在的。

當然,也可以迴避上述兩論點之間的聯繫。例如,圖靈的兒童機假設[12]基本上就實現了所需的智能特徵,卻不需要精確的設計具體運作的方法。關於機械人隱性知識[13]的論述更是完全不需要精確描述。

要回答這個問題,首先要定義什麼是「智能」。

Remove ads

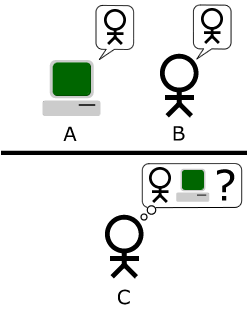

阿蘭·圖靈[15]將智能的定義簡化為簡單的對話問題:若一台機器能用普通人會說的話回答向它提出的任何問題,就可以稱這台機器有智能。這個設計的現代版本是一個在線聊天室,兩個參與者是人類與程序。如果沒有人能分辨出兩個參與者中誰是人類,那麼這個程序就通過了測試。[6]圖靈指出,從沒有人(哲學家除外)提出過「人會思考嗎」這個問題:「與其在這一點上爭論不休,不如約定俗成地認為每個人都會思考。」[16]圖靈測試將這一習慣延伸到了機器上:

- 如果一台機器的行為和人類一樣智能,那麼它就和人類一樣智能。

對圖靈測試的一種批評是,它只能測量機器行為的「人性化」程度,而非行為的「智能」程度:人類行為和智能行為並不完全相同,因此該測試無法衡量智能。Stuart J. Russell和彼得·諾維格寫道:「航空工程學的教科書並沒有將領域目標定義為『製造能像鴿子一樣準確飛行的機器,直到能騙過鴿子。』」[17]

21世紀的AI研究將智能定義為以目標為導向的行為,將智能視為機器要解決的一系列問題——能解決的問題越多,解決得越好,程序就越智能。「人工智能」概念的提出者約翰·麥卡錫將智能定義為「在世界上實現目標的能力的計算部分」。[18]

Stuart J. Russell和彼得·諾維格利用抽象的智能體形式化了這一概念。「智能體」是能在環境中感知並行動的事物,「性能度量」則描述了智能體的智能程度。[19]

- 「智能體的行為是使基於過去經驗和知識的性能度量預期值最大化。」[20]

類似這樣的定義試圖抓住智能的本質,優點是不會囊括人類的非智力特徵,如打字錯誤;[21]缺點是無法區分事物「會不會思考」 :根據這個定義,恆溫容器也具有初級智能。[22]

Hubert Dreyfus將這一論點描述為:「如果神經系統遵守物理、化學定律(完全有理由認為其完全遵守),則......應該可以用某種物理裝置重現神經系統的行為。」[23][24](1943)首次提出之,漢斯·莫拉維克(1988)對其進行了生動描述。[25]目前,未來學家雷蒙德·庫茨魏爾將其與大腦模擬聯繫在一起,他估計到2029年,計算機將有足夠的算力進行完整的大腦模擬。 [26]2005年,出現了丘腦皮質模型的非實時模擬,模型大小相當於人腦(1011個神經元),[27]在個由27個處理器組成的集群上模擬1秒鐘的大腦動態需要50天。

即使是AI最嚴厲的批評者(如Hubert Dreyfus和約翰·瑟爾)也同意,大腦模擬在理論上是可能的。[a] 然而,瑟爾也指出:原則上任何東西都可以被計算機模擬,因此把這定義無限推下去,就會得到:嚴格來說,任何過程都能視作是「計算」。「我們想知道的是,思維與恆溫容器和肝臟的區別在哪裏。」[30]因此,僅僅模擬活體大腦的運,作就等於承認自己對智能與思維本質的無知,就像是在不了解任何航空航天工程理論時,通過一根羽毛一根羽毛地精確複製一隻鳥來製造飛機一樣。[31]

Remove ads

1963年,艾倫·紐厄爾和司馬賀提出,「符號加工」是人類和機器智能的本質。他們寫道:

- 「物理符號系統具有一般智能行動的充分與必要手段。」[8]

這種說法非常有力,意味着人類思維是一種符號操縱(符號系統是智能的必要條件),也意味着機器可以是智能的(符號系統足以構成智能)。[32] 哲學家Hubert Dreyfus描述了這種立場的另一個版本,他稱之為「心理假設」:

- 「心智可以視作按形式規則對比特信息進行操作的裝置。」[33]

紐厄爾、西蒙和Dreyfus討論的「符號」是類似於詞語的高級符號,直接與現實物體相對應,如<狗>、<尾巴>之類。1956直至1990年間出現的大多數人工智能程序都使用這種符號。基於統計與數學優化的現代人工智能已經脫離了這一層次。

這些論點表明,人類思維不(僅)是由高層次符號加工組成。這不是說人工智能是不可能的,只是指出在符號加工之外還需要別的要素。

1931年,庫爾特·哥德爾證明了哥德爾不完備定理:總可以構造出「哥德爾算式」使給定的一致形式系統(如高級符號作業系統)無法證明之。雖然構造的哥德爾算式是真語句,但在給定系統內卻是無法證明的(哥德爾算式的真假取決於給定系統的一致性;對微妙地不一致系統應用同樣的過程看似可行,但實際上會產出錯誤的「哥德爾算式」)。[來源請求]更推測性地說,哥德爾猜想,人類思維最終可以正確判斷任何有根據的數學語句(包括所有哥德爾算式)的真假,因此人類思維不能還原為一種機械。[34]哲學家John Lucas (1961起)和羅傑·彭羅斯(1989起)一直倡導這種哲學上的反機械論。[35]

哥德爾反機械論的論證往往依賴於一個看似無關緊要的主張,即所謂人類數學家系統(或人類數學家的某種理想化)一致(沒有錯誤)且完全相信自身的一致性(並能做出從自身一致性出發的推理,包括相信其哥德爾算式)[來源請求]。圖靈機因停機問題不可能做到這一點,因此哥德爾主義者得出結論:人類的推理能力強得無法被圖靈機捕捉,推而廣之,也無法被任何數字機械設備捕捉。

然而,科學界和數學界的現代共識是,實際的人類推理是不一致的;任何一致的「理想化」人類推理H在邏輯上都會被迫地開放式懷疑自身的一致性(否則H就可證明不一致);這不滿足哥德爾不完備定理的條件,也就無法得到「人類具有機器無法複製的數學推理能力」。[36][37][38]關於哥德爾反機械論注定要失敗的共識在《人工智能》期刊中得到了有力闡述:「任何試圖(用哥德爾不完備定理)攻擊計算主義都注定的,都是非法(invalid)、無效的,因為這些結果實際上與計算主義完全一致。」[39]

Stuart Russell和彼得·諾維格同意,哥德爾主義論證沒有考慮現實世界中人類推理的本質。它適用於在內存和時間無限的情況下理論上可以證明的問題。實際上,真實機器(包括人類)的資源是有限的,很難證明許多定理。要成為一個有智能的人,並不一定要能證明一切。[40]

侯世達在獲得了普立茲獎的圖書《集異璧》中指出,這些「哥德爾算式」總是指系統本身,與說謊者悖論使用「這句話是謊話」之類自指語句進行類比。[41]不過當然,說謊者悖論適用於任何有算式的事物,無論是機器還是人類,甚至自身。考慮:

- John Lucas無法斷定這句話的真實性。[42]

這一說法是正確的,但John Lucas卻無法斷言。這表明,John Lucas本人和所有人一樣,都受到他描述的機器的限制,因此他的論證毫無意義。[43]

彭羅斯得出人類推理不可能通過計算實現後,繼續推測:某種涉及量子力學狀態坍縮的不可計算過程,使人類比計算機具有獨特的優勢。現有的量子計算機只能降低圖靈可計算任務的複雜性,仍局限於圖靈機可處理的任務。根據彭羅斯和盧卡斯的論點,這一事實意味着它們不足以模擬人類思維。[來源請求][需要解釋]。因此,彭羅斯尋求其他一些涉及新物理學的過程,例如量子引力,可能通過波函數的自發量子坍縮,在普朗克質量的尺度上表現出新的物理學。他認為,這些過程可能發生在神經元內部,也可能跨越多個神經元。[44]然而,其他科學家指出,大腦中不存在利用任何量子計算的可信有機機制;此外,量子退相干的時間尺度太狹窄,無法影響神經元的激活過程。[45]

Hubert Dreyfus認為,人類智能主要依賴於快速的直覺判斷,而不是逐步的符號操作,並認為這些技能永遠無法精確表達為形式化的規則。[46]

Dreyfus的論點早在圖靈的《計算機器與智能》(1950)論文中就有所預見,他將其歸類為「行為非形式性觀點」。[47]對此,圖靈認為,我們並不知道支配複雜行為的規則(也許存在)。他寫道:「我們不能輕易說服自己不存在完整的行為法則……我們所知,發現這種法則的唯一途徑是科學觀察。我們當然知道,在任何情況下都不能說『已經找遍了,沒有這樣的法則。』」[48]

羅素和諾維格指出,自Dreyfus發表評論以來,人們在發現無意識推理的「規則」方面取得了進展。[49]機械人學研究中的「情境運動」(situated movement)試圖捕捉我們在感知和注意力方面的無意識技能。[50]神經網絡、進化算法之類的計算智能範式主要面向模擬無意識。人工智能的統計方法可以做出接近人類直覺猜測的預測。對常識性知識的研究側重於再現知識的「背景」。事實上,人工智能研究總體上已經從高層次符號操作轉向捕捉直覺推理的新模型。[49]

認知科學和心理學最終同意Dreyfu對人類專長的描述。丹尼爾·卡尼曼等人也提出了類似理論,確定了人類用來解決問題的兩個「系統」,可稱之為「直覺系統」(快速直覺判斷)和「逐步系統」(較慢逐步思考)。[51]

雖然Dreyfus的觀點在許多方面得到了重信任,但認知科學和人工智能領域的工作針對具體問題展開,並沒有受到Dreyfus的直接影響。歷史學家和人工智能研究者Daniel Crevier寫道:「時間證明了Dreyfus某些觀點的準確性與敏銳性,如果他不那麼咄咄逼人,那些建議可能會更早得到應有的重視。」[52]

Remove ads

機器能有思想、意識與心理狀態嗎?

這是一個哲學問題,與他心問題和困難問題有關。這個問題圍繞着約翰·瑟爾定義為「強人工智能」的立場展開:

- 物理符號系統可以有意識和心理狀態。[9]

瑟爾將這一立場與所謂「弱人工智能」區分開來:

- 物理符號系統可以智能地行動。[9]

瑟爾引入這些術語是為了區分強弱AI,這樣就能專注於他關注的問題。他認為,即使假定存在與人類思維一模一樣的行為的電腦程式,也仍有棘手的哲學問題需要回答.[9]

瑟爾的這兩個立場都不是人工智能研究的重點,因為它們並沒有直接回答「機器能否顯示出一般智能」的問題(除非也能證明意識是智能的必要條件)。圖靈寫道:「我不想給人留下這樣的印象:我認為意識並不神秘……[但]我並不認為在我們能回答[機器能否思考]這個問題之前,這些謎團就一定需要解開。」[53]Russell和諾維格對此表示贊同:「大多數人工智能研究人員認為弱AI假說是理所應當的,卻不關心強AI假說。」[54]

有一些研究者認為,意識是智能的基本要素,如Igor Aleksander、Stan Franklin、Ron Sun、Pentti Haikonen等人,不過他們對「意識」的定義與「智能」非常接近(見人工意識)。

在回答這個問題之前,必須明確「心智」(mind)「心理狀態」(mental state)「意識」(consciousness)的含義。

Remove ads

不同群體對「心智」(mind)和「意識」(consciousness)這兩個詞有不同用法。例如,一些新紀元運動思想家用「意識」描述與亨利·柏格森所謂「生命衝力」之類的事物:一種無形的、充滿活力的流體,滲透到生命中,尤其是心智中。科幻作品則用這個詞描述人類的某些本質屬性:具有「意識」的機器或外星人會被描繪為人類形態的角色,擁有智慧、欲望、意志、洞察力、自豪感等等。(科幻作家也用「感知能力」(sentience)「智慧」(sapience)「自覺」(self-awareness)乃至「鬼」,如《攻殼機動隊》,以描述這種本質人類屬性)。對其他人[誰?]來說,「心智」「意識」之類是靈魂的世俗化同義詞。

對哲學家、神經科學家、認知科學家來說,這些詞的使用更精確也更世俗:它們指我們熟悉的「腦海中有個主意」的日常體驗,如感知、夢想、意圖與計劃,以及看到某物、知道某物、理解某物的方式等等。[55]哲學家瑟爾認為「給意識下個常識性定義並不難。」[56]意識的神秘和迷人之處不在於它是什麼,而在於形成過程:一團脂肪組織和小小的電流是如何產生這種感知、意義與思維體驗的?

哲學家稱之為「困難問題」,是心靈哲學中所謂心物問題的最新版本。[57]預支相關的一個問題是所謂意義或理解問題(哲學家稱之為「意向性」):思想與思考的對象(即對象與情境)之間的聯繫有什麼聯繫?第三個問題是經驗問題(或「現象學」):若兩個人看到同樣的事物,他們的體驗是否相同?還是說,「腦海裏的東西」(稱作「感質」)有沒有可能因人而異?[58]

神經生物學家相信,隨着我們開始確定意識與神經的相關性,所有問題都將迎刃而解:頭腦中的機械機制與其集體屬性(如心智、經驗與理解)之間的實際關係。一些對人工智能持最嚴厲批評態度的人都認為,大腦只是一台機器,意識和智能都是愛中物理過程的結果。[59]這個棘手的哲學問題是:電腦程式在數字機器上運行時,本質上只是0與1的交換,它能複製神經元創造思維、心理狀態(如理解和感知)以及最終意識體驗的能力嗎?

約翰·瑟爾提出了一個思想實驗:假設現有一程序,通過了圖靈測試,並展現了一般的智能行為。具體來說,假設該程序能用流利的中文交談。把程序寫在3x5的卡片上,交給一個不會中文的普通人,把他關在房間裏,讓他按卡片上的指示操作。他將抄寫出漢字,並通過一個插槽進出房間。從外面看,這個中文屋裏似乎有個完全會說中文的聰明人。問題是:房間裏有人(或任何東西)懂中文嗎?也就是說,有沒有任何東西具有理解的心理狀態?有沒有任何東西能有意識地認識到正在用中文討論什麼?這個人顯然沒有我們所指的意識,房子本身也沒有意識,卡片當然也沒有意識。於是,瑟爾的結論是:中文屋或其他任何物理符號系統都不可能有心智。[60]

瑟爾繼續論證說,實際的心理狀態和意識需要(尚待描述)「實際人腦的實際物化屬性」。[61]他認為大腦和神經元具有特殊的「因果屬性」,從中產生了心智;用他的話說,就是「大腦導致心智」。[62]

戈特弗里德·萊布尼茨(1714)很早就提出了與瑟爾基本相同的論點,他所用的思想實驗是將大腦擴大到磨坊大小。[63]Lawrence Davis(1974)設想用電話線和配備人員的辦公室來複製大腦;內德·布洛克(1978)設想讓整個中國的人口都參與這樣的大腦模擬。這個思想實驗被稱為「中國民族」或「中國體育館」。[64]內德·布洛克後來把中文屋歸結到「傻瓜實驗」,程序被再重構為一套「看這個,做那個」的簡單規則,消除了其中程序的所有神秘性。

對中文屋的回應強調了幾個不同的觀點。

- 系統回答與虛擬心智回答:[65]這個回答認為,包括人、程序、房間和卡片在內的整個系統,是理解了中文的東西。瑟爾稱,房間裏的那個人是唯一可能「有心智」或「有理解」的東西,但其他人則認為在同一個物理空間裏有可能存在兩個思想,就像一台計算機可以同時「是」兩台機器一樣:一台是物理的(如Mac機),一台是「虛擬機」(如文字處理器)。

- 速度、力量與複雜性回答:[66]一些評論家指出,房間裏的人可能要上百萬年時間才能回答一個簡單的問題,並且需要天文數字般的「檔案櫃」。這讓人對瑟爾直覺的清晰度產生了懷疑。

- 機械人回答:[67]有人認為,中文屋要真正理解需要眼和手。Hans Moravec寫道:「如果能把機械人嫁接到推理程序中,就不再需要人來提供這個意義了:它將來自物理世界。」[68]

- 大腦模擬器回答:[69]如果程序模擬的是真正會說中文的人的大腦突觸的神經發射序列呢?房間裏的人將模擬真實的大腦。這是「系統回答」的一種變體,看起來更可信,因為「系統」現在像人腦一樣運作。這似乎表明:除了房間裏的那個人之外,還有別的東西能聽懂中文。

- 他心回答與表象回答:[70]有幾位學者指出,瑟爾的論證只是他心問題的一個適用於機器的版本。既然很難確定人是否「真正」在思考,那麼很難回答關於機器的同樣問題就不值得驚訝。

- 一個相關問題是(瑟爾理解的)「意識」是否存在。瑟爾認為,意識體驗無法通過研究機器、人類或任何其他動物的行為來發現。丹尼爾·丹尼特指出,自然選擇只會保留對動物行為有影響的特徵,因此不可能產生(瑟爾理解的)意識。於是,要麼自然選擇沒有產生意識,要麼「強人工智能」是正確的,意識可以通過適當的圖靈測試檢測出來。

思考是一種計算嗎?

心智計算理論(「計算主義」)稱,心智與大腦之間的關係類似於運行中的程序(軟件)與計算機(硬件)之間的關係。這一觀點在哲學上源於托馬斯·霍布斯(推理「不過是計算」)、戈特弗里德·萊布尼茨(試圖為人類所有想法創建邏輯微積分)、大衛·休謨(認為知覺可以簡化為「印象子」)甚至伊曼努爾·康德(將所有經驗分析為形式規則所控制)。[71]最新版本與哲學家希拉里·懷特哈爾·普特南和傑瑞·福多有關。[72]

如果人腦是一種計算機,那麼計算機就可以同時具有智能和意識,從而回答人工智能的實踐問題和哲學問題。就人工智能的實踐問題(「機器能否展現一般智能?」)而言,某些版本的計算主義聲稱(如霍布斯所寫):

- 推理不過是計算。[10]

即智能源於一種類似於算術的計算形式,這就是上文討論的物理符號系統假說,它意味着人工智能是可能的。就人工智能的哲學問題(「機器能否擁有心智、心理狀態與意識?」)而言,大多數計算主義版本都聲稱(Stevan Harnad描述):

- 心理狀態只是(正確的)電腦程式的實例化。[73]

其他相關問題

若從對行為的影響或在生物體內發揮功能的方法的角度來定義,則「情緒」可視為智能體用來最大化行為效用的一種機制。漢斯·莫拉維克據此相信「一般來說機械人在做好事時相當情緒化」。[74]恐懼是緊迫感的來源。移情是好的人機交互必備的部分。他說,機械人「會以一種看似無私的方式取悅你,因為它可以從這種積極的強化中獲得快感。你可以把這理解為一種愛。」[74]Daniel Crevier寫道:「莫拉維克的觀點是,情緒只是將行為向利於物種生存的方向引導的工具。」[75]

如上所述,「自我意識」有時被科幻作家用作人類本質屬性的名稱,能使物品成為完全的人類。圖靈剝離了人類的其他屬性,將問題簡化為「機器能否成為自己思想的主體?」它能思考自己嗎?從這個定義來看,能報告自身內部狀態的程序(如調試器)似乎具備這種「自我意識」。[76]

圖靈把這問題簡化為機器能否「出其不意」的問題,並認為這顯然是正確的,任何程式設計師都能證明。[77]他指出,只要有足夠的內存,計算機就能以天文數字級的不同方式運行。[78]對於一台能表示想法的計算機,以新方式組合想法一定是可能的,甚至是平凡的(例子如道格拉斯·萊納特的自動數學家將各種想法結合起來,發現了新的數學真理)。安德烈亞斯·卡普蘭和Haenlein認為,機器可以表現出科學創造力,而在藝術創造力方面,則人類很可能佔上風。[79]

2009年,亞伯大學和劍橋大學的科學家設計了一個名為亞當的機械人,他們認為這是第一個能獨立提出新科學發現的機器。[80]同樣是在2009年,康奈爾大學的研究人員開發了Eureqa程序,可以根據輸入的數據推斷公式,例如從鐘擺的運動中找出運動定律。

這個問題(與人工智能哲學中的許多問題一樣)可以有兩種表述形式:「敵意」可由功能或行為定義,這樣「敵意」就是「危險」的同義詞;也可由意圖的角度來定義:機器能否「故意」造成傷害?後者是「機器有沒有意識狀態(意圖)?」的另一種形式。[53]

未來學家(如機器智能研究所)詳細研究了高度智能、完全自動的機器是否危險的問題。這話題也是諸多科幻作品中極其常見的戲劇性元素,使其大受歡迎。科幻作品考慮了智能機器對人類構成威脅的許多場景,參見虛構作品中的人工智能。

其中一個問題是,機器可能會很快獲得所需的自主性和智能,從而變得非常危險。弗諾·文奇認為,計算機的智能會在短短幾年內突然比人類高出成千上萬倍,他稱之為「技術奇點」。[81]他認為,這對人類可能非常危險。[82]一種名為「奇點主義」的哲學對此進行了討論。

2009年,學術界和技術專家召開了一次會議,討論機械人和計算機的可能影響,並在假設它們自動決策的可能性帶來的影響。他們討論了計算機和機械人獲得自主能力的可能性和程度,以及它們在多大程度上能用這種能力構成威脅。他們指出,一些機器已經獲得了某種形式的半自主能力,如能自行尋找電源、獨立選擇武器攻擊目標之類;一些電腦病毒能躲避消毒,實現了「蟑螂智能」。他們指出,科幻作品中描述的機器自我意識不太可能實現,但還有其他隱患。[81]

一些學者對賦予有一定自主能力的軍用機械人提出質疑。[83]美國海軍資助的一份報告指出,隨着軍用機械人變得越來越複雜,應更多關注其自主決策能力的影響。[84][85]

人工智能促進協會主席委託進行了一項研究,以探討這一問題。[86]他們指出,語言習得裝置等程序可以模擬人類互動。 有人認為有必要建立「友善人工智能」,也就是說人工智能已經取得的進步應包括在本質上走向友好與人性化。[87]

圖靈說「人們習慣於……以聲明的形式提供一絲安慰,即機器永遠無法模仿人類的某些特徵……我提供不了任何這樣的安慰,因為我相信無法設定這樣的界限。」[88]

圖靈指出,有許多論據的形式是「機器永遠不會做X」,但這些意見往往基於對機器多功能性的天真假設,或是「意識論證的變體」。編寫一個表現出一種X的程序「不會給人留下什麼印象。」[76]除非能證明這些X中的某個是一般智能必須的,否則都與人工智能的基本前提無關。

最後,那些相信存在靈魂的人可能會說「思維是人類長生的靈魂的一種功能」。圖靈稱之為「神學異議」,寫道:

在試圖建造這樣的機器時,我們不應不敬地篡奪祂創造靈魂的權力,就像我們在生育孩子時一樣:相反,無論在哪種情況下,我們都是祂意志的工具,為祂創造的靈魂提供居所。[89]

最近,谷歌的LaMDA稱自己擁有知覺,且「有靈魂」,再次引發了對這一話題的討論。[90]

LaMDA是人工智能系統,會收集互聯網上的大量文本並用算法以最流暢、最自然的方式回答詢問,創造出聊天機械人——一種用於與人類交流的AI機械人。

科學家與LaMDA的對話記錄顯示,它在這方面表現很出色,能回答有關情感本質的挑戰性話題,生成伊索寓言式的故事,甚至描繪它所謂的恐懼。[91]幾乎所有的哲學家都對LaMDA的知能表示懷疑。 [92]

對哲學作用的看法

有學者認為,AI界對哲學的否定是有害的。《斯坦福哲學百科全書》中,一些哲學家認為,哲學在AI中的作用沒有得到充分重視。[4]哲學家戴維·多伊奇認為,若不了解哲學或其概念,AI就會缺乏進展。[93]

參見

註釋

參考文獻

引文

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads