热门问题

时间线

聊天

视角

Mamba2

深度学习架构 来自维基百科,自由的百科全书

Remove ads

Mamba2是基於狀態空間對偶(SSD)框架的新型模型,統一了Transformer與結構化狀態空間模型(SSM)。[1]相較於前身Mamba,它在保持效能的同時將讓運算速度有所提升,最佳化計算效率。

架構

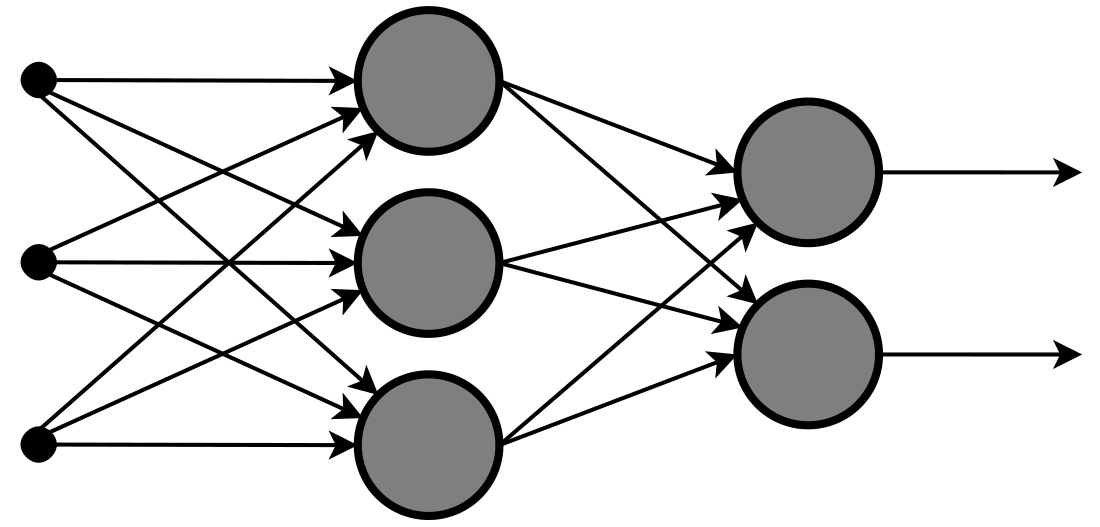

Mamba-2是基於狀態空間模型(State Space Model, SSM)與注意力機制深度融合的新型序列建模架構,其核心設計圍繞「狀態空間對偶性」(State Space Duality, SSD)框架展開。該框架通過結構化矩陣理論(如半可分矩陣)建立SSM與注意力機制之間的數學等價性,從而將兩者的高效演算法統一,解決了傳統SSM(如Mamba)在硬體效率與擴充性上的瓶頸,同時保持了與Transformer的競爭力。[1]

狀態空間對偶性(SSD)框架揭示了SSM與線性注意力的內在關聯:將SSM的遞迴計算形式(線性複雜度)與注意力的二次矩陣形式(如)統一為結構化矩陣變換。通過半可分矩陣(Semiseparable Matrix)的分解,SSM可視為一類具有低秩下三角結構的注意力變體(Structured Masked Attention, SMA),反之亦然。這種對偶性允許SSM利用注意力的並列化技術(如張量並列),同時繼承SSM的長序列建模優勢。[1]

Mamba2是Mamba架構的進化版本,其核心創新在於結構化狀態空間對偶(SSD)框架的提出,首次揭示了狀態空間模型(SSMs)與注意力的內在等價關係。該框架啟發了高效演算法,如基於半可分矩陣塊分解的SSD計算,速度較Mamba的selective scan提升2—8倍,並支援更大的狀態維度(如8倍擴充)。架構上,Mamba2引入並列參數投影機制,避免了順序計算瓶頸;同時整合多值注意力(MVA)模式最佳化頭部設計,並支援Tensor Parallelism以減少同步開銷。這些創新提升了訓練效率和語言建模能力,在Perplexity和下游任務中超越前代模型。[1]

Mamba-2在序列建模中展現出效能優勢,其核心創新在於結構化狀態空間對偶(SSD)框架。理論層面,SSD將狀態空間模型(SSM)與注意力機制統一為半可分矩陣的兩種計算形式,並通過塊分解演算法實現計算最佳化。相較Mamba的選擇性SSM需硬體最佳化掃描,SSD充分利用矩陣乘法單元,訓練速度提升2-8倍;相比Transformer的二次注意力複雜度(FLOPs),SSD保持線性複雜度( FLOPs),在長序列場景更具可延伸性。

實驗驗證顯示:在MQAR聯想回憶任務中,Mamba-2通過增大狀態維度(N=256)超越Mamba;語言建模任務顯示同參數量下Mamba-2帕累托支配Mamba與Transformer++;下游零樣本評估證實2.7B參數的Mamba-2超越6.9B的Pythia模型。這些結果突顯其在效率與表達能力上的雙重突破。[1]

Remove ads

Mamba-2模型在序列建模領域雖具突破性,但仍存在若干局限性。模型結構方面,其基於狀態空間模型(SSM)的設計雖能高效處理長序列,但固定大小的狀態向量可能限制對極端複雜依賴關係的建模能力,尤其在需要精確保留歷史細節的任務中表現遜於傳統注意力機制。計算效率層面,儘管通過結構化矩陣最佳化(如SSD演算法)顯著提升訓練速度,但在短序列場景下的硬體利用率仍低於高度最佳化的Transformer實現(如FlashAttention-2),且超大狀態維度(N>256)可能導致主記憶體壓力。功能特性上,模型簡化了softmax注意力機制,雖提升效率卻犧牲了動態權重分配的靈活性,對需精細關聯建模的任務(如多跳推理)適應性較弱。此外,其遞迴本質對錯誤傳播較為敏感,長程生成可能累積隱狀態誤差。[1]

變種模型

Mamba2-BiLSTM混合模型是一種將雙向長短期記憶網路(BiLSTM)與新型狀態空間模型Mamba2相結合的深度學習架構。該模型利用BiLSTM捕捉電池充放電過程中的長周期時序依賴特性,同時通過Mamba2的高效序列建模能力解析全域電壓變化關聯性,實現局部特徵與全域退化規律的互補融合。此結構在鋰電池健康狀態(SOH)估計中,能同步處理荷電狀態(SOC)與SOH的耦合關係,顯著提升容量衰減預測精度,並依託遷移學習實現跨電池型號的泛化應用。[2]

通過融合深度可分離卷積與輕量化門控單元,模型在保留全域依賴建模能力的同時,實現對大規模點雲、影片等多維時空資料的即時處理。該變種在點雲配准、自動駕駛感知等領域展現出較好效能,成為輕量化端到端學習系統的一種技術路徑。[3]

RRGMambaFormer是一種基於Mamba-2架構的混合模型變種,專為醫學影像報告生成任務設計。該模型創新性地融合了Transformer的注意力機制與Mamba塊的高效序列建模能力,通過動態替換傳統位置編碼並引入多粒度上下文記憶模組,顯著提升了長文字生成的準確性和計算效率。其核心突破在於減少參數量的同時加速推理,適用於處理複雜跨模態醫療資料(如圖像與報告)。[4]

影響

未來方向

解釋性技術遷移 :借鑑Transformer的解釋性方法(如注意力視覺化[7]),探索SSMs的可解釋性工具,分析Mamba2模型是否具有類似特性。[1]

上下文學習(In-Context Learning)增強 :結合線性注意力和SSM的優勢,開發更適合上下文學習的架構。[1]

參見

注釋

參考

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads