Top-Fragen

Zeitleiste

Chat

Kontext

Explainable Artificial Intelligence

KI, bei der das Zustandekommen der Antworten von Menschen verstanden werden kann Aus Wikipedia, der freien Enzyklopädie

Remove ads

Explainable Artificial Intelligence (XAI; deutsch: erklärbare künstliche Intelligenz[1][2][3] oder erklärbares Maschinenlernen) soll nachvollziehbar machen, auf welche Weise dynamische und nicht linear programmierte Systeme[4], z. B. künstliche neuronale Netze, Deep-Learning-Systeme (reinforcement learning) und genetische Algorithmen, zu Ergebnissen kommen. XAI ist eine technische Disziplin, die operative Methoden erarbeitet und bereitstellt, die zur Erklärung von AI-Systemen dienen.

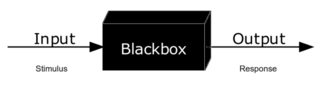

Ohne XAI gleichen einige Methoden des maschinellen Lernens (insbesondere das Deep Learning) einem Black-Box-Vorgang,[1][5] bei dem die Introspektion eines dynamischen Systems unbekannt oder erst in Ansätzen möglich ist und der Anwender kaum Kontrollmöglichkeiten hat zu verstehen, wie eine Software zur Lösung eines Problems gelangt.[6]

Remove ads

Definition

Es gibt derzeit noch keine allgemein akzeptierte Definition von XAI.

Das XAI-Programm der Defense Advanced Research Projects Agency (DARPA),[7] deren Ansatz sich schematisch darstellen lässt,[8] definiert seine Ziele mit den folgenden Forderungen:

- Produzieren Sie erklärbarere Modelle, während Sie gleichzeitig eine hohe Lernleistung beibehalten (Vorhersagegenauigkeit).

- Ermöglichen Sie menschlichen Nutzern, die entstehende Generation künstlich intelligenter Partner zu verstehen, ihnen angemessen zu vertrauen und mit ihnen effektiv umzugehen.[9]

Remove ads

Geschichte

Zusammenfassung

Kontext

Während der Begriff „XAI“ noch relativ neu ist – eine frühe Erwähnung des Konzepts erfolgte 2004[10] – hat der bewusste Ansatz, das Vorgehen von maschinellen Lernsystemen komplett verstehen zu wollen, eine längere Geschichte. Forscher sind seit den 1990er Jahren daran interessiert, Regeln aus trainierten neuronalen Netzen abzuleiten,[11] und Wissenschaftler im Gebiet der klinischen Expertensysteme, die neuronale Entscheidungshilfen für Mediziner liefern, haben versucht, dynamische Erklärungssysteme zu entwickeln, die diese Technologien in der Praxis vertrauenswürdiger machen.[12]

In letzter Zeit wird aber der Schwerpunkt darauf gelegt, Maschinenlernen und KI den Entscheidungsträgern und Nutzern – und nicht etwa den Konstrukteuren von Entscheidungssystemen – zu erklären und verständlich zu machen.[13] Seit der Einführung des Programms durch DARPA im Jahr 2016 versuchen neue Initiativen das Problem der algorithmic accountability (etwa ‚algorithmische Rechenschaftspflicht‘) anzugehen und Transparenz zu schaffen (Glass-Box-Vorgang[14]), wie Technologien in diesem Bereich funktionieren:

Remove ads

Methoden

Zusammenfassung

Kontext

Verschiedene Methoden werden für XAI angewendet:

- Layer-wise relevance propagation (LRP; etwa‚ Schicht für Schicht erfolgende Übertragung von Bedeutung‘)[5] wurde erstmals 2015 beschrieben und ist eine Technik zu Bestimmung der Merkmale von bestimmten Eingangsvektoren, die am stärksten zum Ausgabeergebnis eines neuronalen Netzwerks beitragen.[17][18]

- Counterfactual method (etwa‚ kontrafaktische Methode‘): Nach dem Erhalten eines Resultats werden gezielt Input-Daten (Text, Bilder, Diagramme etc.) verändert und man beobachtet, wie sich dadurch das Ausgaberesultat verändert.[19]

- Local interpretable model-agnostic explanations (LIME)[20]

- Mechanistic interpretability versucht, Verhaltensweisen eines bestimmten Deep-Learning-Modells zu analysieren und dadurch Features (Merkmale) zu finden, welche das Verhalten des Modells gezielt verändern können. Diese Methode wurde erstmals 2024 für das hochkomplexe Modell Claude-3 Sonnet unter dem Titel Mapping the Mind of a Large Language Model veröffentlicht.[21][22]

- Generalized additive model (GAM)[23][19]

- Rationalization: Speziell bei AI-basierten Robotern wird die Maschine in die Lage versetzt, dass sie ihre eigenen Handlungen „verbal erklären“ kann.[24][25][19]

Anwendungsbeispiele

Bestimmte Industriezweige und Dienstleistungsbereiche sind von XAI-Anforderungen besonders betroffen, da durch die dort immer intensivere Anwendung von KI-Systemen die „Rechenschaftspflicht“ (englisch accountability) mehr und mehr auf die Software und deren – teilweise überraschende – Ergebnisse verlagert („delegiert“) wird.

Folgende Bereiche stehen dabei besonders im Fokus (alphabetische Auflistung):

- Antennendesign[26]

- Informationsrecherche, Information Retrieval und Wissensreproduktion[27]

- Hochfrequenzhandel (algorithmischer Handel)[28][29]

- Medizinische Diagnostik[30]

- Selbstfahrende Kraftfahrzeuge[31][32][33]

- Neuronale Netzwerk-Bildgebung[34]

- Training militärischer Strategien[35]

Remove ads

Internationaler Austausch über die Thematik und Forderungen

Zusammenfassung

Kontext

Da Regulierungsbehörden, Behörden und allgemeine Nutzer von dynamischen Systemen auf KI-Basis abhängig sind, wird eine klarere Rechenschaftspflicht für die Entscheidungsfindung erforderlich sein, um Vertrauen und Transparenz zu gewährleisten.

Ein Beleg dafür, dass diese berechtigte Forderung an Dynamik gewinnt, ist die International Joint Conference on Artificial Intelligence: Workshop on Explainable Artificial Intelligence (XAI) im Jahr 2017.[36]

In Bezug auf KI-Systeme fordern die australische Publizistin und Wissenschaftlerin Kate Crawford und ihre Kollegin Meredith Whittaker (AI Now Institute), dass „die wichtigsten öffentlichen Einrichtungen, wie z. B. die für Strafjustiz, Gesundheit, Wohlfahrt und Bildung zuständigen Stellen […], keine Black-Box-KI und algorithmische Systeme mehr verwenden sollten“.[37][38] Zusätzlich fordern sie – noch über die rein technischen Maßnahmen und Methoden der Erklärbarkeit solcher Systeme hinaus – verbindliche ethischen Maßstäbe, wie sie beispielsweise in der pharmazeutischen Industrie und klinischen Forschung angewendet werden.[39]

Primär im Europarecht wurde die Existenz eines „Rechts auf Erläuterung“ (right to [an] explanation) anhand der DSGVO bereits seit 2017 intensiv diskutiert.[40] Potentielle Ansatzpunkte für die Ableitung eines solchen Rechts finden sich in Art 22 DSGVO, der ein (prinzipielles) Verbot der vollautomatisierten Entscheidungsfindung statuiert, in Verbindung mit Erwägungsgrund 71 („In jedem Fall sollte eine solche Verarbeitung mit angemessenen Garantien verbunden sein, einschließlich [...] des Anspruchs [...] auf Erläuterung der nach einer entsprechenden Bewertung getroffenen Entscheidung“). Auch die Informationspflichten (Art 13–14 DSGVO) bzw. das Auskunftsrecht (Art 15 DSGVO) normieren, dass „aussagekräftige Informationen über die involvierte Logik sowie die Tragweite und die angestrebten Auswirkungen einer derartigen Verarbeitung“ proaktiv bzw. auf Anfrage bereitgestellt werden müssen. Allerdings ist die Existenz eines solchen Rechts aufgrund der Natur von Erwägungsgründen im Unionsrecht, diese besitzen vor allem Klarstellungsfunktion, begründen jedoch selbst kein verbindliches Recht, umstritten.[41] Auch die Art 13–15 DSGVO werden teilweise restriktiv im Sinne einer Erläuterung der abstrakten Systemfunktionalität interpretiert, während die Notwendigkeit der Erklärung einer konkreten Entscheidung, das heißt eine Form von lokaler Interpretierbarkeit, verneint wird.[42] Diese restriktive Interpretation ist jedoch nicht unumstritten.[43] So wurde in der Literatur unter anderem die Existenz eines rights to legibility bejaht, das die Fähigkeiten der Betroffenen Informationen zu verstehen einbezieht,[44] die Rolle der Datenschutz-Folgenabschätzung (Art 35 DSGVO) im Kontext des Rechts auf Erläuterung betont[45][46] oder die Existenz eines Rechts auf Erläuterung als (implizite) Garantie im Rahmen von Art 22 Abs 3 DSGVO[47] oder in einer holistischen Lesung verschiedener Bestimmungen der DSGVO angenommen.[48][49]

Andere potentielle rechtliche Ausgangspunkte für die Notwendigkeit von Interpretierbarkeit beim Einsatz von KI wurden anhand des Vertrags- und Schadenersatzrechts[50] oder anhand der informierten Einwilligung (informed consent) zwischen Arzt und Patient im Medizinrecht diskutiert.[51][52]

Remove ads

Weblinks und Literatur

- Explainable AI: Making machines understandable for humans. In: Explainable AI: Making machines understandable for humans. Abgerufen am 2. November 2017 (englisch).

- Explaining How End-to-End Deep Learning Steers a Self-Driving Car. In: Parallel Forall. 23. Mai 2017, abgerufen am 2. November 2017 (englisch).

- New isn't on its way. We're applying it right now. In: Accenture. 25. Oktober 2016, abgerufen am 2. November 2017 (englisch).

- David Alvarez-Melis und Tommi S. Jaakkola: A causal framework for explaining the predictions of black-box sequence-to-sequence models, arxiv:1707.01943, 6. Juli 2017.

- TEDx Talk von Peter Haas über die Notwendigkeit von transparenten KI-Systemen: The Real Reason to be Afraid of Artificial Intelligence (englisch)

- Mengnan Du, Ninghao Liu, Xia Hu: Techniques for Interpretable Machine Learning, Communications of the ACM, January 2020, Vol. 63 No. 1, Pages 68–77 doi:10.1145/3359786 (englisch)

Remove ads

Einzelnachweise

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads