Top Qs

Chronologie

Chat

Contexte

Deepfake

infox qui se présente sous la forme d’une vidéo falsifiée grâce aux techniques de l’intelligence artificielle, en particulier à celles de l’apprentissage profond De Wikipédia, l'encyclopédie libre

Remove ads

Le deepfake [ˈdiːpfeɪk][1], ou hypertrucage[2],[3] (ou infox vidéo[4] ou vidéotox[4] dans le cas de fausses vidéos), est une technique de synthèse multimédia reposant sur l'intelligence artificielle. Le terme deepfake est un mot-valise provenant de l'anglais formé à partir de deep learning (« apprentissage profond ») et de fake (« faux », « contrefait »)[5]. L'IA permet de superposer des parties d'images ou de vidéo ou de fichiers audio existants sur d'autres fichiers (pour par exemple changer le visage d'une personne sur une vidéo ou pour reproduire la voix d'une personne pour lui faire dire des choses inventées), dont pour créer des infox et des canulars malveillants[6],[7], diffuser des informations trompeuses et clivantes (qui peuvent polluer les données d'apprentissage d'autres IA, contribuer à des fraude, au vol d'identités, à de la cyberintimidation et une propagande idéologique et de lobbies, détruisant ainsi la confiance du public, la vie privée et sociale, au détriment de la paix dans le monde. Les progrès de l'IAg (IA générative) ont ensuite, dans les années 2020, permis ont permis la production rapide de médias synthétiques entiers, parfois « remarquablement réalistes », qui présentent des risques importants pour la confiance du public, la vie privée et la sécurité[8].

Des hypertrucages sont par exemple créés avec l'application FakeApp[9], qui utilise TensorFlow, un outil open source développé par Google[10].

Remove ads

Exemples

Résumé

Contexte

Les techniques pour simuler des mouvements faciaux et les transposer sur une personne cible ont été présentées en 2016. Elles permettaient de contrefaire, en temps quasi réel, des expressions faciales dans des vidéos en 2D[12]. Des études sur la sociologie des utilisateurs de Deepfakes pornographiques montrent qu'ils les utilisent généralement « pour rechercher la satisfaction sexuelle, pour harceler et humilier des cibles, ou pour exercer un pouvoir sur un partenaire intime », sachant que les cibles des deepfakes subissent des conséquences émotionnelles, psychologiques et sociales graves[13]. L'arrivée de l'IA a suscité plusieurs marchés en ligne soutenant l'achat et la vente de ces constructions numériques, principalement via la plateforme MrDeepFakes où les règles et limites affichées étaient peu respectées par les utilisateurs[14] (Les conditions d'utilisation de MrDeepFakes interdisaient l'utilisation du contenu du site à des fins commerciales, la redistribution de contenu et l'envoi de messages non sollicités aux utilisateurs, mais elles n'interdisaient pas le scraping, ce qui a permis à des chercheurs de l'étudier[15],[16],[14].

L'hypertrucage audio est apparu en novembre 2016, avec la présentation du programme Adobe Voco, premier programme d'hypertrucage audio capable de reproduire la voix humaine[17].

En juillet 2017, la BBC diffuse un discours prononcé par une intelligence artificielle reproduisant Obama, discours essentiellement indiscernable de la réalité[18].

La pornographie hypertruquée est apparue sur Internet en 2017, notamment sur Reddit[19], et a depuis été interdite par Reddit, Twitter, Pornhub et d'autres[20],[21],[22].

En a été mise en ligne une application appelée FakeApp qui permet de créer facilement des vidéos où les visages ont été permutés et de les partager. Les célébrités sont les principales cibles de ces fausses vidéos sexuelles, mais certaines autres personnes sont aussi touchées[23],[24],[25].

En août 2018, des chercheurs de l'université de Californie à Berkeley ont publié une étude sur la création de fausses vidéos de danseurs. Un individu peut être collé sur les mouvements d'un danseur professionnel[26],[27].

Ensuite les progrès de la synthèse faciale, du clonage vocal et de la synchronisation labiale haute résolution ont permis de produire des contrefaçons multimodales combinant tromperies visuelle et auditive sources de préoccupations éthiques et juridiques.

Début 2025, le principal site de deepfakes pornographiques était MrDeepfakes[28]. Ce site a d'abord lancé, par un internaute canadien, comme simple plateforme d’hébergement. Il a ensuite été utilisé comme lieu de facilitation et d'échanges, entre "demandeurs" (proposant des photos d'anonymes ou de proches), et "créateurs" (ayant les compétences pour produire des deepfakes, sexuels notamment, réalistes)[28] (Ces créateurs pouvaient postuler et devenir des créateurs vérifiés de vidéos, reçevant alors un badge « de confiance » et le droit de vendre des deepFakes (les prix étant négocié généralement en privé) et de monétiser leurs deepfakes sur la plateforme (vidéos payantes, paiements en cryptomonnaies, privilèges publicitaires sur les forums...), tout en échappant à la modération du contenu) ; ils devaient avoir un compte vérifié par e-mail (de plus de 30 jours), et ne pas avoir reçu d'avertissements de la part des modérateurs, prouver qu'ils disposaient des jeux de données ou des images des applications qu'ils utilisent, décrire leur processus de création, et être acceptés par la communauté MrDeepFakes, c'est à dire avoir au moins trois vidéos non supprimées par les modérateurs[14]. Signalé dès 2021 par un rapport du Parlement européen, et régulièrement cité par les études et rapports sur l'usage abusif, déloyal, non-éthique, illégal et dangereux pour les personnes d'intelligences artificielles (IA), il a en quelques années hébergé jusqu'à plus de 50 000 vidéos (vues par des millions de visiteurs mensuels)[28]. Parmi les 488 créateurs de vidéos vérifiés (moins d'un tiers des internautes ayant publié sur la plateforme), 55 (11,3 %) ont répondu, via le site, à des demandes payantes[14].

Selon une enquête du média d’investigation Bellingcat, le site comptait 640 000 membres actifs début 2024.

La fermeture du site a été annoncée le 4 mai 2025, sur sa page d'accueil par un message « un fournisseur de services essentiels a mis fin à ses services de façon permanente » impliquant une perte de données rendant impossible la poursuite des opérations et la réouverture du site ; cette fermeture pourrait être liée à l'adoption aux États-Unis d'une loi "Take it down" interdisant la diffusion d’images intimes sans consentement[28].

Remove ads

Motivations

Résumé

Contexte

Des chercheurs se sont penchés sur les motivations des commanditaires de Deepfakes pour les deux grandes catégories que sont les deepfakes politiques et sexuels, qui parfois fusionnes pour décrédibiliser des personnalités politiques en les présentant dans de fausses situations sexualisées[14].

La malveillance et la désinformation politique sont deux motivations fréquente[29],[30],[31].

Sur la plateforme MrDeepFakes, la gratification sexuelle était un argument souvent cité ( gratification sexuelle non consensuelle fréquemment[14] Les statistiques des commentaires laissés sur le site (avant sa fermeture en mai 2025) montraient des commandes explicitement justifiées par une recherche de plaisir sexuel de la part de l'acheteur dans 23,7 % des demandes ; avec parfois une demande de contenu extrême (racialisé ou violent) ou fétichiste[32], parfois masculiniste, visant à exercer un contrôle – physique, émotionnel et/ou financier – de la personne ciblée, parfois explicitement violent : un acheteur, cité par Catherine Han (Stanford University) et ses collègues, disant que le créateur aurait des « points bonus » s'il parvenait à rendre le contenu de son deepFake « brutal » ou « douloureux ». Inversement, aussi quelques cas de demandes parasociale ont été signalées, où le commanditaire expliquait souhaiter la mise en scène d'une personne qu'il appréciait, "comme elle était"[14].

Dans 7 % des demandes, l'acheteur disait vouloir un contenu qu'il n'a pas trouvé ailleurs, et il présentait sa demande comme pouvant combler un manque pour la communauté et les consommateurs de pornographie en général[14].

Remove ads

Domaines d'application

Résumé

Contexte

Pornographie

Historiquement, Le terme « deepfake porn » (hypertrucage à vocation pornographique non consensuelle, c'est à dire réalisé sans le consentement préalable et éclairé de la personne concernée) est apparu avec de fausses vidéos érotiques (sextapes), mettant en scène des célébrités, et par de la pornodivulgation (revenge porn)[33]. À l'automne 2017, un utilisateur anonyme du site Reddit publie, sous le pseudonyme « Deepfakes », plusieurs vidéos pornographiques. La première à attirer l'attention, qui est l'une de celles ayant suscité le plus de réactions, mettait en scène l'actrice Daisy Ridley. Une autre montrait l'actrice Gal Gadot (vedette du fim Wonder Woman) ayant un rapport sexuel avec son beau-frère. D'autres vidéos similaires avaient déjà été publiées, mais ce cas d'une personnalité publique a déclenché un premier débat public à l'échelle du pays[34]. D'autres célébrités — Emma Watson, Katy Perry, Taylor Swift ou Scarlett Johansson — ont aussi été la cible de vidéos créées par ce même utilisateur « Deepfakes ». Avec le temps, le faussaire a corrigé les défauts des vidéos, les rendant de plus en plus réalistes. Ce phénomène a été dénoncé dès dans la section technique et scientifique du magazine Vice, suscitant l'apparition de nombreux reportages dans d'autres médias[35]. Il explose ensuite avec l'apparition de l'IA générative (IAg).

La législation a un temps de retard sur la violence des réseaux sociaux, mais dans de nombreux pays (comme le Royaume-Uni, le Canada, la France...)[36], le droit pénal permet de poursuivre les producteurs malveillants d'hypertrucages, par exemple pour harcèlement et atteinte aux droits de la personne. Néanmoins, des appels à faire de l'hypertrucage un délit, sépcifique et à part entière, émerge[37].

Parmi les cybermenaces qui affectent la société, Simon Robichaud-Durand (2023 note que l'hypertrucage pornographique, bien qu'il cause de grandes souffrances psychiques, et parfois le suicide, chez de nombreuses victimes, a moins suscité l'intérêt des élus et médias que les hypertrucages servant la désinformation et des propagandes politiques, issus de groupes politiques et d'intérêts, généralement proches de l'extrême droite, du libertarianisme de droite, ou de régimes populistes et illibéraux, et/ou liées aux ingérences étrangères cherchant à créer le chaos et une perte de confiance dans les institutions publiques, électorales notamment[38]. Ainsi, en 2023, la Loi électorale du Canada semble mieux protéger contre les dangers des hypertrucages à finalités politiques, que protéger les victimes de montages pornographiques et non consensuels, « toujours sans recours concret », nous proposons une solution multiapproche regroupant quatre volets : la législation, la sensibilisation, l'innovation et la collaboration[38].

Une comparaison des législations disponibles pour protéger les victimes de revenge porn a été faite pour neuf États membres de l'UE : trois de ces pays ont une incrimination distincte de cet acte, mais avec une portée juridique et des définition sensiblement différente faisant que les victimes ne peuvent faire valoir leurs droits de la même manière dans ces Etats[39].

Certains pays sont plus touchés que d'autres : selon un rapport de la société américaine de cybersécurité Security Hero, la Corée du Sud a été en 2023 le « pays le plus touché par la pornographie deepfake », souvent utilisée dans un contexte de harcèlement sexuel ou d'extorsion d'argent (en 2020, un réseau criminel a été reconnus coupables d'avoir fait chanter des dizaines de femmes à propos de vidéos sexuellement explicites)[40] ; les chanteurs et actrices du pays comptant pour plus de la moitié des personnes figurant dans la pornographie deepfake dans le monde[40]. Ce phénomène serait, selon Hong Nam-hee (de l'Institut des humanités urbaines de l'Université de Séoul), notamment lié à l'utilisation intensive du smartphone, dans une société coréenne très sexiste, à dominante « misogyne », qui « objectifie sexuellement les femmes », où l'éducation sexuelle et les droits humains sont peu abordés dans les écoles ; et où les médias et réseaux sociaux réglementent mal la protection des mineurs[40]. La police, lors d'une vague d'enquête a dit avoir arrêté 387 personnes pour des crimes présumés de deepfake en 2024 : plus de 80 % étaient des adolescents. Les grandes écoles et universités ne sont pas épargnées (parmi cinq hommes arrêtés par la police pour suspicion de production et diffusion de faux contenus explicites à l'encontre d'une vingtaine de femmes toutes diplômées de l'Université nationale de Séoul, l'école la plus réputée du pays ; deux fréquentaient la même université)[40]. En 2024, le Gouvernement coréen a décidé de criminaliser le visionnage, la sauvegarde ou la possession de deepfakes sexuellement explicites, avec des peine pouvant aller jusqu'à trois ans de prison et jusqu'à 30 millions de wons d'amende (22 600 dollars), selon le projet de loi ; la réalisation de deepfakes sexuellement explicites exposait déjà à jusqu'à cinq ans de prison ou 50 millions de wons (Loi sur la prévention des violences sexuelles et la protection des victimes), le projet de loi propose de porter à sept ans la durée maximale d'emprisonnement (quelle que soit l'intention de celui qui a produit le deepfake)[41]. Cette dynamique de lutte contre ce type de deepfake en Corée du Sud a coïncidé[42] avec l'enquête française sur Pavel Durov (fondateur de Telegram, mis en examen par la justice française en août 2024 et notamment soupçonné d'avoir contribué au crime organisé en n'ayant pas suffisamment modéré sa plateforme)[43],[44]. En 2024, la Corée du Sud a également ouvert une enquête sur Telegram et ordonné à la plateforme de l'aider à lutter contre les crimes sexuels numériques[42]. Cette même année 2024, une autre plateforme, Instagram propriété de Meta a quant à elle annoncé installer un contrôleur de nudité" qui va flouter les images explicites de nus sur Instagram pour protéger les mineurs du chantage aux photos de nu reçues via la messagerie (l'utilisateur choisit s'il veut les voir ou non) ; et une IA va bloquer les "dick pics" non sollicités, en floutant les images suspectes pour limiter le risque de cyberharcèlement.

Le site de la ligne d'assistance téléphonique créé au Royaume-Uni contre le revengePorn publie ses propres statistiques : les victimes y sont des femmes dans environ 75% des cas, et les auteurs sont presque toujours des hommes ; des sources laissent penser que les jeunes sont plus prudents dans la mise en ligne de leurs images d'eux-mêmes, mais le phénomène de sextorsion par des groupes organisés est en augmentation[45].

Politique

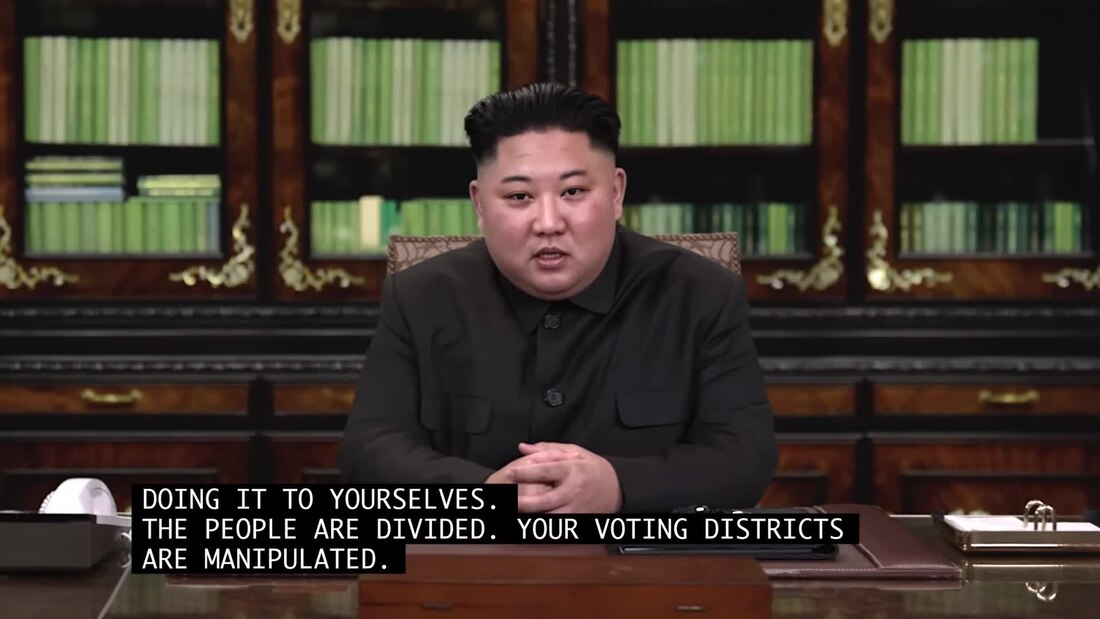

La permutation de visages a été utilisée pour donner une image fausse de politiciens connus sur des portails vidéo, des plates-formes de streaming et de discussion en ligne. Le visage du président argentin Mauricio Macri a ainsi été remplacé par celui d'Adolf Hitler et celui d'Angela Merkel par celui de Donald Trump[46],[47].

En , Jordan Peele et Jonah Peretti ont montré les dangers de l'hypertrucages en créant une fausse vidéo de Barack Obama faisant une annonce publique[48].

Le deepfake peut servir à influencer et modifier des sentiments et comportements de la population, ou chercher à discréditer une personnalité. En 2022, en pleine invasion russe de l'Ukraine, le site de la chaîne d'information Ukraine 24 a mis en ligne une vidéo prétendument tournée par le président ukrainien Volodymyr Zelensky, où il exhortait la population à rendre les armes. Ce deepfake a été partagé au même moment sur les réseaux sociaux Facebook et Telegram, probablement à l'initiative de la Russie ou d'un compte pro-russe, pour semer le trouble sur les intentions réelles du chef d'État[49].

Vidéo d'Art

En , l'artiste Joseph Ayerle publie la vidéo d'art intitulée Un'emozione per sempre 2.0. Il y met en scène une Ornella Muti virtuelle, recréée par intelligence artificielle qui a pu animer le visage de l'actrice italienne pour créer des scènes qu'elle n'a jamais jouées[50],[51].

Cinéma

Sorti en 2022, Fairytale, réalisé par le cinéaste russe Alexandre Sokourov, utilise une technologie de deepfake pour rassembler Staline, Hitler, Churchill et Mussolini au purgatoire.

Le procédé a permis d'insérer, dans une fiction cinématographique, une archive historique en substituant la silhouette et le visage de l'interprète du personnage historique à ceux du personnage historique lui-même[52].

Il peut être utilisé au cinéma pour modifier le mouvement des lèvres lors du doublage dans une autre langue[53].

Télévision

L'émission de télévision française humoristique et satirique C Canteloup sur TF1 utilise cette technologie à partir du 18 novembre 2019, depuis la diffusion d'un numéro spécial intitulé C'est Canteloup, La grande Métamorphose.

Le feuilleton télévisé français Plus belle la vie a pu poursuivre le tournage de son intrigue malgré l'absence d'une comédienne, Malika Alaoui, à l'isolement car cas contact au Covid-19, en greffant son visage sur celui d'une autre actrice[54].

Deep Fake Neighbour Wars, littéralement « La guerre des voisins façon deepfake », est une comédie en six épisodes de 30 minutes utilisant le deepfake, mise en ligne le sur ITV, la télévision privée du Royaume-Uni[55].

Remove ads

Programmes de trucage

Résumé

Contexte

Ils ont largement profité des progrès de l'IA, et en particulier de la hiérarchie de l'apprentissage profond (c'est à dire de l'organisation en plusieurs couches des réseaux neuronaux artificiels) et des réseaux antagonistes génératifs (GAN).

Par exemple, FakeApp utilise la puissance de la carte graphique plus 3 ou 4 Go de stockage pour générer le rendu final, mais ses algorithmes d'apprentissage profond nécessitent encore, pour un bon rendu, beaucoup de photos de la personne afin d'apprendre quels aspects de la vidéo cible doivent être modifiés. Le logiciel utilise TensorFlow, développé par Google et entre autres, utilisé pour créer DeepDream.

Programmes d'hypertrucage audio

- Adobe Voco est un logiciel prototype d'édition et de production d'hypertrucage audio conçu par Adobe qui permet la création et la modification audio novatrices. Surnommé « Photoshop-for-Voice », il a été présenté pour la première fois lors de l'événement Adobe MAX en novembre 2016.

La technologie présentée dans Adobe MAX était un aperçu pouvant potentiellement être intégré à Adobe Creative Cloud. À compter de juillet 2019, Adobe n'a pas encore publié d'informations supplémentaires sur une date de sortie potentielle[17].

- LyreBird

- WaveNet est un réseau de neurones profond permettant de générer du son brut, créé par des chercheurs de la société d'intelligence artificielle basée à Londres. Selon un document de septembre 2016, elle peu générer des voix de type humain, relativement réalistes, en modélisant des formes d'onde via un réseau neuronal entraîné avec des enregistrements de parole réelle. Des tests avec l'anglais américain et le mandarin auraient montré que le système surpasse les meilleurs systèmes de synthèse vocale existants de Google, même si, en 2016, sa synthèse textuelle était encore moins convaincante que le discours humain réel. La capacité de WaveNet à générer des formes d'ondes brutes lui permet de modéliser tout type d'audio (musique y compris)[56].

Remove ads

Critiques

Résumé

Contexte

Abus

Le quotidien suisse germanophone Aargauer Zeitung affirme que la retouche d'images et de vidéos à l'aide de l'intelligence artificielle pourrait devenir un phénomène de masse dangereux. Cependant, la falsification d'images et de vidéos est antérieure à l'avènement des logiciels de montage vidéo et des programmes de retouche d'images ; dans ce cas, c'est le réalisme, la facilité et la rapidité de la modification et son caractère de plus en plus difficile à détecter qui créent un nouveau problème.

Il est également possible d'utiliser l'hypertrucage pour des canulars ciblés et de la pornodivulgation à des fins idéologiques ou de cyberharcèlement[57],[58]. Le 24 octobre 2023, la Commission du Sénat américain sur la cybersécurité, les technologies de l'information et l'innovation gouvernementale, lors d'une session consacrée à l'état des avancées de la technologie du deepfake, a auditionné trois témoins (Dana Rao, vice-président exécutif, directeur juridique et directeur de la confiance chez Adobe, le docteur David Doermann, président par intérim de l'université d'État d'informatique et d'ingénierie de New York à Buffalo ,et Sam Gregory, directrice exécutive de WITNESS). Tous trois sont convenus que fabriquer un deepfake très réaliste devient de plus en plus accessible et facile, ce qui implique un risque d'utilisation accrue pour diffuser de fausses informations ou nuire à la réputation de quelqu'un, y compris via des contenus à caractère sexuel non consenti[59]. Selon Dana Rao, les deepfakes peuvent être encore améliorés via des techniques sophistiquées. Pour Sam Gregory, il est urgent d'améliorer les technologies de détection, de créer une législation dédiée et de sensibiliser le public aux risques posés par les deepfakes[59].

Effets sur la crédibilité et l'authenticité

Un autre effet de l'hypertrucage est qu'on ne peut plus distinguer si le contenu est satirique, malveillant ou authentique. Interrogé, en 2018, par le site américain The Verge (qui traite de l'actualité technologique, de l'information et des médias), le chercheur en intelligence artificielle américain Alex Champandard (programmeur et cofondateur de la startup Creative) estime que

« tout le monde devrait être conscient de la rapidité à laquelle les choses peuvent être modifiées aujourd'hui à l'aide de cette technique et que le problème ne doit pas venir de la technique mais plutôt être résolu par la confiance des personnes dans l'information et le journalisme. Le principal danger est de voir arriver le moment où les humains ne pourront plus déterminer si ce qui se trouve dans une vidéo correspond à la vérité ou non[60]. »

Informations immatérielles et non palpables, les infox vidéo brisent la confiance du fait qu'elles trompent les individus[61].

Remove ads

Réactions

Résumé

Contexte

Mesures juridiques (lois, projets de loi...)

- À partir du , la Chine interdit tout contenu ne mentionnant pas l'utilisation de superpositions de vidéos et d'audios ; les infox vidéo qui ne sont pas mentionnées comme telles seront considérées comme illégales[62],[63].

- Aux États-Unis, en 2023, aucune loi fédérale n'interdit les contrefaçons numériques d'images ou de vidéos présentant un caractère intime sexuel ou pornographique, créées via une IA et inspirées de personnes réelles ; un projet de loi déposé en 2023, proposant des peines allant jusqu'à 10 ans de prison, n'avait pas avancé. Seuls quelques États avaient voté leurs propres lois : au Texas, les auteurs risquent jusqu'à un an d'emprisonnement, et en Californie, ils peuvent se voir infliger des dommages et intérêts.

Début 2024, après la circulation de fausses images sexuellement explicites de Taylor Swift dans les médias sociaux, des élus ont déposé un nouveau projet de loi fédérale, dit Disrupt Explicit Forged Images and Non-Consensual Edits Act of 2024 ou DEFIANCE Act of 2024, qui devrait permettre à des victimes de plus facilement poursuivre en justice (recours civil fédéral) les auteurs présumés de deepfakes à caractère explicitement sexuel ou pornographique, réalisés et publiés sans le consentement du sujet. Le projet (janvier 2024) de loi vise aussi les personnes en possession de faux contenu dans le but de le distribuer, de même que ceux qui ont reçu ou distribué ce type de deepfakes si elles « savaient ou ont ignoré par imprudence » que la victime n'a pas donné son consentement[64]. - Au Canada, le projet de loi n° 730 de l'Assemblée interdit la distribution de faux médias audio ou visuels malveillants ciblant un candidat candidat à une fonction publique dans les 60 jours suivant son élection[65].

Contre mesures et développement de moyens de détection

Deux outils majeurs de la « criminalistique numérique » émergente (destinée analyser et traiter les deepfakes et manipulations multimédias, notamment sur les plateformes sociales et d'information) sont :

- le filigrane cryptographique (un marqueur invisible contenant un identifiant unique et d'éventuelles autres métadonnées, imperceptible et immuable, garantissant l'origine d'un fichier, multimédia ou non) est l'un des moyens de limiter les risques d'altération et de manipulations, qui peut aussi contribuer à la protection de la propriété intellectuelle ; mais il doit être résistant aux changements tels que la compression et la déformation, facile à "lire", et ne peut être apposé que dans des contenus nouveaux (ou réédités par une autorité crédible) ;

- l'utilisation de l'IA basée sur l'apprentissage profond pour détecter et évaluer les indices de trucages, d'altérations et d'attaques d'empoisonnement[66], si possible dans le flux des plateformes de consultation et de streaming[66] et des réseaux et média sociaux[67]

Audio

Détecter de l'audio falsifié s'avère de plus en plus complexe, mais l'IA qui a permis de créer des fakes peut aussi, via l'apprentissage profond, détecter ces fakes. La préparation des caractéristiques et l'augmentation du masquage se sont avérées efficaces pour améliorer les performances[68].

Vidéo

Dans les années 2010, la recherche académique sur les deepfakes s'est surtout concentrée sur la détection des vidéos deepfakes[69].

Des logiciels, tels qu'InVid et Amnesty Youtube Dataviewer (outil proposé depuis 2014, par l'ONG Amnesty International, permettent aux journalistes de déterminer si une vidéo est truquée ou manipulée[61],[70].

Divers types d'algorithmes peuvent détecter des faux et de subtiles incohérences caractéristiques des vidéos deepfakes[69], par exemple concernant l'éclairage[71]. Ainsi, des chercheurs de l'université de Buffalo ont montré, en octobre 2020, que l'analyse des reflets de la lumière dans les yeux des personnes représentées permettaient de repérer la plupart des deepfakes sans même avoir besoin de l'assistance d'une IA, du moins à cette époque[72]. Cependant, la technique de production de deepfakes continue aussi à progresser, imposant une amélioration constante des algorithmes de détection[69].

Pour encourager et évaluer les algorithmes de détection de contenu manipulé, et sélectionner les plus efficaces des systèmes de détection, une coalition d'entreprises technologiques a lancé un concours : le Deepfake Detection Challenge[73]. Le modèle gagnant du Deepfake Detection Challenge était précis à 65 % sur un ensemble de 4 000 vidéos[74]. Fin 2021, une équipe du MIT (Massachusetts Institute of Technology) a démontré que les humains ordinaires pouvaient, avec une précision de 69 à 72 %, identifier les fakes dans un échantillon aléatoire de 50 de ces vidéos[75].

Pour le cas d'individus bien « documentés » (ex. : personnalités politiques et du spectacle), des algorithmes ont été conçus pour distinguer les différences avec leur réelles manières faciales, gestuelles et vocales[76].

Wael AbdAlmageed et ses collègues du Laboratoire d'intelligence visuelle et d'analyse multimédia (VIMAL) de l'Institut des sciences de l'information de l'université de Californie du Sud ont développé deux générations[77],[78] de détecteurs de deepfake basés sur des réseaux neuronaux convolutifs. La première génération[78] utilisait des réseaux de neurones récurrents pour repérer les incohérences spatio-temporelles et identifier les artefacts visuels laissés par le processus de génération de deepfake. L'algorithme a atteint une précision de détection de 96 % (sur FaceForensics++, le seul benchmark deepfake à grande échelle disponible à l'époque). La seconde génération a utilisé des réseaux profonds de bout en bout pour différencier les artefacts et les informations faciales sémantiques de haut niveau à l'aide de réseaux à deux branches. La première branche propage les informations de couleur tandis que l'autre branche supprime le contenu facial et amplifie les fréquences de bas niveau à l'aide du laplacien de gaussien (LoG). De plus, ils ont inclus une nouvelle fonction de perte qui apprend une représentation compacte des visages authentiques tout en dispersant les représentations (c'est-à-dire les caractéristiques) des deepfakes. L'approche de VIMAL a montré des performances de pointe sur les benchmarks FaceForensics++ et Celeb-DF et, le 16 mars 2022 (le jour même de la sortie), a détecté le deepfake de Volodymyr Zelensky sans aucune connaissance de l'algorithme avec lequel le deepfake a été créé.

Facebook lance un concours « Deepfake Detection Challenge » (DDC), afin de créer des technologies et logiciels capables de déceler des vidéos utilisant la technique d'infox vidéo[79].

En 2021, environ 5 milliards de vidéos étaient visionnées chaque jour sur YouTube, sans aucun moyen fiable de facilement vérifier leur légitimité[80].

Twitter et Gfycat ont annoncé qu'ils allaient supprimer les hypertrucages et bloquer leurs auteurs. Auparavant, la plate-forme Discord avait bloqué un canal de discussion comportant des hypertrucages. Le site pornographique Pornhub prévoyait, lui aussi, de bloquer ces contenus, mais cette interdiction n'a pas été appliquée en 2017 et 2018[81],[82].

Chez Reddit, la situation était restée incertaine jusqu'à ce que le subreddit — la sous-partie thématique en question — soit suspendu le en raison de la violation de la politique de « pornographie involontaire »[83],[84],[85],[86].

En mai 2022, Google modifie ses conditions d'utilisation de Jupyter Notebook, une application Web multimédia pour la création et le partage de documents informatiques, interdisant son utilisation pour créer des deepfakes[87]. Ce changement intervient peu après la publication d'un article de Vice affirmant que « la plupart des deepfakes sont du porno non consensuel », souvent générés par le logiciel alors le plus populaire de deepfake DeepFaceLab (DFL), utilisé par la Walt Disney Company pour des clips vidéo officiels et la websérie Sassy Justice, des créateurs de South Park, mais aussi via GitHub ou Discord pour générer des deepfakes pornographiques[88].

D'autres suggestions ont été faites :

- utiliser des méthodes de pointe, basées sur l'apprentissage automatique, l'apprentissage profond et des architectures multimodales dédiées pour détecter les deepfake et répondre rapidement aux « attaques adverses », mais au risque d'une couteuse course technologique posant pour l'humanité des défis technologiques et sociétaux[89] ;

- utiliser la blockchain pour enregistrer chaque média émis par une source supposée fiable pour que l'origine d'une vidéo puisse ensuite être vérifiée via son « grand livre » avant d'être diffusée sur des plates-formes de médias sociaux[90] et pour authentifier les fichiers mis en ligne[91]. Mais outre que cette solution serait, à grande échelle, très consommatrice d'énergie et de ressources informatiques, il serait très facile à tout producteur de fausse vidéo de faire enregistrer son travail dans la blockchain ;

- utiliser une signature numérique native, codée de difficilement falsifiable, dans toutes les vidéos et images faites par des appareils-photo, smartphones ou caméras vidéo. Ainsi, Solange Ghernaouti (spécialiste en cybersécurité et cyberdéfense) suggère que les images et vidéos numériques devraient être dotées de tatouages numériques identifiant l'origine du contenu.

Cependant, non seulement cela n'empêcherait pas les fausses vidéos, mais une telle « signature » permettrait à des dictatures et à des États répressifs de retracer l'origine de chaque photographie ou vidéo en facilitant aussi la traque de détracteurs, photo-journalistes ou lanceurs d'alerte, prévenait Kalev Leetaru en 2018[92] ; - pour savoir si une personne à l'écran, lors d'un appel vidéo « en direct » et « en temps réel », est vraie ou s'il s'agit d'une image animée par une IA, un moyen simple est de demander à l'appelant de se tourner de côté. Au début des années 2020, les vidéos deepfakes ne sont généralement pas très efficaces pour générer des vues de profil[93].

Remove ads

Voir aussi

Documentaire

- (en) [vidéo][Production de télévision] « Deepfakes : la nouvelle donne », Shuchen Tan (réalisation), Soraya Pol (recherche), sur Arte, , 50 min, Pays-Bas (consulté le )

Articles connexes

Liens externes

- « Deepfake : l'IA met de l'huile sur le faux », La Science, CQFD, France Culture, 27 février 2025.

- Le "deep fake" : vers la fin de la vérité dans l'image numérique ?, Xavier de La Porte, France Inter, 21 mai 2019

- Le Congrès américain veut combattre les hypertrucages, Radio-Canada, 13 juin 2019

- Deepfake : faut-il le voir pour le croire ?, La Méthode scientifique, France Culture, 26 juin 2019

- Internet : les deepfakes, comment ça marche ? France info, 12 septembre 2019

- Fabien Soyez, Au-delà du politique et du porno, le deepfake changera aussi le cinéma, Cnet, 11 octobre 2019

- Morgane Tual, Deepfakes : faut-il avoir peur de ces vidéos trafiquées ?, Le Monde, 24 novembre 2019

- Jennifer Mertens, Le deepfake audio, la nouvelle arnaque tendance développée par les hackers, Bibliothèque du Parlement, 2020, 20 Minutes, [lire en ligne].

- Benoit Marini, Deepfakes : Quand l'Intelligence Artificielle transforme nos réalités ?, TedX Bordeaux, 3 novembre 2018

Bibliographie

- Ajder, Henry, Giorgio Patrini, Francesco Cavalli and Laurence Cullen. 2019. ‘The State of Deepfakes: Landscape, Threats, and Impact.’ Deeptrace.

- Breland, Ali. 2019. ‘The Bizarre and Terrifying Case of the “Deepfake” Video that Helped Bring an African Nation to the Brink.’ Mother Jones, Politics. March 15. Accessed April 25, 2020. https://www.motherjones.com/politics/2019/03/deepfake-gabon-ali-bongo/(open in a new window).

- Chesney, Robert and Danielle K. Citron. 2019a. ‘Deep Fakes: A Looming Challenge for Privacy, Democracy, and National Security.’ California Law Review 107 (6): 1753–1820.

- Chesney, Robert and Danielle K. Citron. 2019b. ‘Deep Fakes and the New Disinformation War: The Coming Age of Post-Truth Geopolitics.’ Foreign Affairs 98 (1): 147–155.

- Cole, Samantha. 2017. ‘AI-Assisted Fake Porn is Here and We’re All Fucked.’ Vice. December 11. Accessed April 25, 2020. https://www.vice.com/en_us/article/gydydm/gal-gadot-fake-ai-porn

- Cole, Samantha. 2018. ‘We Are Truly Fucked: Everyone is Making AI-Generated Fake Porn Now.’ Vice. January 24. Accessed April 25, 2020. https://www.vice.com/en_us/article/bjye8a/reddit-fake-porn-app-daisy-ridley

- Coleman, Alistair. 2019. ‘“Deepfake” App Causes Fraud and Privacy Fears in China.’ BBC Monitoring. September 4. Accessed April 25, 2020. https://www.bbc.com/news/technology-49570418

- Dassanayake, Dion. 2018. ‘Pirate Bay SHUTDOWN: End Nearing for Torrent Site? Shock Claims as Major Outage Hits.’ Express. June 30. Accessed April 25 2020. https://www.express.co.uk/life-style/science-technology/981576/Pirate-Bay-shut-down-torrents-website-servers-down-outage

- Department of Homeland Security. Increasing threat of deepfake identities. Technical report, Department of Homeland Security, 2021.

- Farid, Hany. 2018. ‘Digital Forensics in a Post-Truth Age.’ Forensic Science International 289: 268–269. doi: 10.1016/j.forsciint.2018.05.047

- Galston, William A. 2020. ‘Is Seeing Still Believing? The Deepfake Challenge to Truth in Politics.’ Brookings. January 8. Accessed April 25, 2020. https://www.brookings.edu/research/is-seeing-still-believing-the-deepfake-challenge-to-truth-in-politics/

- Güera, David and Edward J. Delp. 2018. ‘Deepfake Video Detection Using Recurrent Neural Networks.’ 15th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS), 1–6. doi: 10.1109/AVSS.2018.8639163

- Harris, Douglas. 2019. ‘Deepfakes: False Pornography Is Here and The Law Cannot Protect You.’ Duke Law and Technology Review 17 (1): 99–128.

- Kolina Koltai. Anydream: Secretive AI platform broke stripe rules to rake in money from nonconsensual pornographic deepfakes. Bellingcat, 2023.

- Kushner, David. 2019. ‘A Brief History of Porn on the Internet.’ Wired. September 4. Accessed April 25 2020. https://www.wired.com/story/brief-history-porn-internet/(open in a new window).

- Nir Kshetri. The economics of deepfakes. Computing’s Economics, 2023.

- Kweilin T Lucas. Deepfakes and domestic violence: perpetrating intimate partner abuse using video technology. Victims & Offenders, 17(5), 2022.

- Maras, Marie-Helen and Alex Alexandrou. 2019. ‘Determining Authenticity of Video Evidence in the Age of Artificial Intelligence and in the Wake of Deepfake Videos.’ The International Journal of Evidence & Proof 23 (3): 255–262. doi: 10.1177/1365712718807226

- Roettgers, Janko. 2018. ‘Porn Producers Offer to Help Hollywood Take Down Deepfake Videos.’ Variety. February 21. Accessed April 25, 2020. https://variety.com/2018/digital/news/deepfakes-porn-adult-industry-1202705749/ .

- Solo, Ashu M. G. 2019. ‘Combating Online Defamation and Doxing in the United States.’ In Proceedings of the 2019 International Conference on Internet Computing and Internet of Things (ICOMP ‘19), edited by Hamid R. Arabnia, Leonidas Deligiannidis and Fernando G. Tinetti, 75–77. Athens, GA: CSREA.

- Tay, Rachel. 2019. ‘“One Day You May See My Picture Also Like That”: Mahathir Says Sex Tapes of Minister Are Fake and Politically Motivated.’ Business Insider Malaysia. June 13. Accessed April 25, 2020. https://www.businessinsider.my/one-day-you-may-see-my-picture-also-like-that-mahathir-says-sex-tapes-of-minister-are-fake-and-politically-motivated/(open in a new window).

Bases de données et dictionnaires

- Ressource relative à l'audiovisuel :

Remove ads

Références

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads