Топ питань

Часова шкала

Чат

Перспективи

Тензорний блок обробки

розроблений «Google» співпроцесор для прискорення роботи нейронних мереж З Вікіпедії, вільної енциклопедії

Remove ads

Тензорний блок обробки (англ. tensor processing unit, TPU) — це інтегральна схема специфічного застосування (ASIC) призначена для прискорення розрахунків штучного інтелекту, що була розроблена компанією Google спеціально для машинного навчання нейронних мереж.

Огляд

Узагальнити

Перспектива

Тензорний блок обробки був анонсований у травні 2016 року на конференції Google I/O, де компанія оголосила, що TPU вже більше року використовується в її дата-центрах.[1][2] Чип було розроблено спеціально для програмного каркаса TensorFlow, математичної бібліотеки символьних обчислень, що використовується для таких застосунків машинного навчання як штучні нейронні мережі.[3] Водночас Google продовжував використовувати центральні і графічні процесори для інших видів машинного навчання.[1] Окрім тензорного блоку від Google, з'являються й інші різновиди прискорювачів штучного інтелекту від інших виробників, що, зокрема, націлені на ринки вбудованої електроніки та робототехніки.

TPU є власністю Google і комерційно не розповсюджується, хоча 12 лютого 2018 року The New York Times повідомила, що Google «дозволить іншим компаніям купувати доступ до цих чипів за допомогою служби хмарних обчислень».[4] Google стверджує, що TPU були використані в серії ігор у ґо комп'ютера проти людини, у яких програма AlphaGo здобула перемогу над корейський майстром Лі Седолом, а також у системі AlphaZero, яка навчилася грати у шахи, сьоґі і ґо на надлюдському рівні знаючи лише правила цих ігор та здобула перевагу над іншими провідними програмами в цих іграх.[5] Google також використовувала TPU для обробки тексту в Google Street View і змогла знайти весь текст у власній базі даних менш ніж за п'ять днів. В Google Фото окремий TPU може обробляти більше 100 мільйонів фотографій на день. TPU також використовується в системі RankBrain, яку Google використовує для надання результатів пошуку.[6]

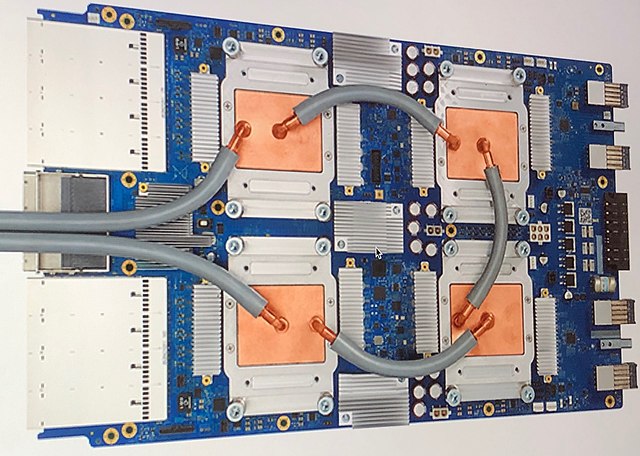

У порівнянні з графічним процесором, TPU розрахований на великі обсяги обчислень з низькою точністю (наприклад, лише 8-бітною точністю)[7], з вищою кількістю операцій вводу-виводу в секунду на ват. У TPU відсутністі апаратні засоби для растрування/відображення текстур.[2] Чип TPU монтується разом із радіатором та може розміститися в гнізді жорсткого диска в стійці центру обробки даних.[1]

У 2018 році TPU були використані для навчання ботів, що грають у StarCraft, поширену комп'ютерну стратегію реального часу. Таким чином комп'ютер вперше зміг здобути переконливу перемогу над професійними гравцями. Для навчання боти (окремі версії програми) грали між собою у турнір. Кожен бот використовував 16 тензорних процесорів TPU (що, за словами керівника DeepMind, відповідало потужності близько 50 графічних процесорів). Натреновані таким чином на тензорних блоках нейронні мережі були застосовані на типовому графічному процесорі для гри проти професійних гравців-людей.[8]

Remove ads

Покоління

Узагальнити

Перспектива

Перше покоління

TPU першого покоління є 8-бітним процесором множення матриць, який керується командами CISC від головного процесора через шину PCIe 3.0. Він виготовлений на процесі 28 нм з розміром кристалу ≤ 331 мм2. Тактова частота 700 МГц, тепловий розрахунок на потужність 28-40 Вт. Має 28 МіБ пам'яті на чипі і 4 МіБ 32-розрядних акумуляторів, які отримують результати систолічного масиву розміру 256х256 з 8-бітних множників.[9] Всередині TPU також міститься 8 ГіБ двоканальної оперативної пам'яті DDR3 SDRAM з частотою 2133 МГц, що пропонує 34 Гб/с пропускної спроможності.[10] Команди переносять дані на або з головного процесора, виконують множення матриць, згортки, застосовують функції активації.[9]

Друге покоління

TPU другого покоління було анонсовано у травні 2017 року.[11] У Google заявили, що продуктивність першого покоління TPU була обмеженою через недостатню пропускну здатність оперативної пам'яті. У другому поколінні було використано 16 Гб пам'яті High Bandwidth Memory[en], через що пропускна здатність збільшилася до 600 Гб/с, а продуктивність — до 45 TFLOPS.[10] Нові TPU було об'єднано в модулі з чотирьох чипів із загальною продуктивністю 180 TFLOPS.[11] 64 таких модулі об'єднувалися у блоки модулів із 256-ма чипами та загальною продуктивністю 11,5 PFLOPS.[11] В той час як TPU першого покоління обмежувалися цілими числами, TPU другого покоління також можуть обчислювати числа з рухомою комою. Це робить TPU другого покоління корисними як для навчання, так і для застосування моделей машинного навчання. У Google заявили, що TPU другого покоління будуть доступні на Google Compute Engine для використання у застосунках TensorFlow.[12]

Третє покоління

TPU третього покоління було анонсовано 8 травня 2018 року.[13] Google оголосив, що самі процесори вдвічі потужніші, ніж TPU другого покоління, а кожен блок модулів міститиме вчетверо більше чипів, ніж в попередньому поколінні.[14][15] Відтак, кожен блок модулів буде увосьмеро продуктивнішим порівняно з другим поколінням.

Remove ads

Див. Також

- Зоровий процесор — подібний пристрій спеціалізований для машинного зору.

- Структурний тензор, математична основа тензорних блоків обробки

- ШІ-прискорювач

Примітки

Посилання

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads