トップQs

タイムライン

チャット

視点

アーティキュレートリー・シンセシス

ウィキペディアから

Remove ads

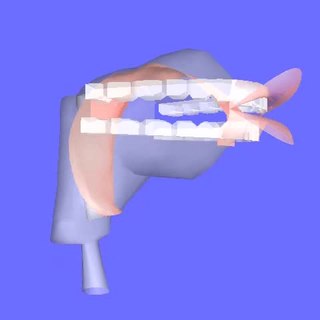

アーティキュレートリー・シンセシス (英: articulatory synthesis)、調音合成 (ちょうおんごうせい) あるいは 調音音声合成 とは、人間の声道のモデルと そこで行なわれる調音プロセス (articulation) に基づいて音声合成を行なうための計算手法である。声道の形状は通常、舌や顎、唇といった調音器官の位置変更と関連した数多くの調音方法で制御できる。声道の表現を介した空気の流れのデジタル・シミュレーションで、音声が生成される。

機械式語り手

→「音声合成 § 歴史」も参照

機械式「語り手」(talking heads) の製作の試みには長い歴史がある。[2] オーリヤックのジェルベール (–1003)、アルベルトゥス・マグヌス (1198–1280)、ロジャー・ベーコン (1214–1294) らは皆、喋る頭 (speaking heads) を作ったと言われている (Wheatstone 1837[要出典])。しかしながら、歴史的に確認された音声合成の始まりは訳注: クリスティアン・クラッツェンシュタイン (1723–1795)[3] とヴォルフガング・フォン・ケンペレン (1734–1804)であり、ケンペレンは1791年に研究報告[4]を出版した。(Dudley & Tarnoczy (1950)も参照)

電子式声道

最初の電子式アナログ声道は、Dunn (1950)やStevens, Kasowski & Fant (1953)、Fant (1960)のように静的なものだった。Rosen (1958)は動的な声道 (DAVO)を組み立て、後にDennis (1963)がコンピュータ制御を試みた。Dennis & et al. (1964))[要出典]、比企 & et al. (1968))[要出典]、Baxter & Strong (1969)らもアナログ声道ハードウェアについて説明している。

最初のコンピュータ・シミュレーションは、Kelly & Lochbaum (1962)が行なった; その後デジタルコンピュータによるシミュレーションを、例えば中田 & 光岡 (1965)、松井 (1968)、Mermelstein (1971))[要出典]が行なった。本多, 井上 & 小川 (1968)はアナログコンピュータによるシミュレーションを行なった。

Remove ads

Haskinsと前田のモデル

研究室の実験で定期的に使用される 最初のソフトウェアによる調音シンセサイザーは、1970年代半ばにHaskins Laboratoriesで Philip Rubin, Tom Baer, Paul Mermelstein により開発された。ASY (Articulatory Synthesis)[5]として知られるこのシンセサイザーは、1960年代–1970年代にベル研究所で Paul Mermelstein, Cecil Coker, およびその同僚らによって開発された声道モデルに基づく音声生成の計算モデルだった。もう一つの頻繁に使用された著名なモデルは、前田 眞治 (Shinji Maeda)による、舌の形状制御に因子ベースのアプローチ (factor-based approach) を使ったモデルである。[要出典][要説明]

現代的なモデル

音声生成イメージング、調音制御モデリング、舌の生体力学モデリング の最近の進展は、調音合成が行われる方法に変化をもたらしている。[6] 一例として、Philip Rubin, Mark Tiede,[7] Louis Goldstein[8] が設計したHaskins CASYモデル (Configurable Articulatory Synthesis)[9]では、声道の縦断面を実際の核磁気共鳴画像(MRI)データと一致させており、MRIデータを声道の3次元モデルの構築に使用している。 フル3次元の調音合成モデルは Olov Engwall[10]が説明している。[11] 幾何学的に基づいた[要出典]3次元調音スピーチ・シンセサイザーはPeter Birkholzにより開発されている。(VocalTracLab[12]参照) ArtiSynthプロジェクト[13]は、 ブリティッシュコロンビア大学のSidney Fels[14]が率いており、人間の声道と上気道のための3次元生体力学モデリング・ツールキットを提供している。 舌などの調音器官の生体力学モデリングは、Reiner Wilhelms-Tricarico,[15] Yohan Payan[16] と Jean-Michel Gerard, [17] 党 建武 (Jianwu Dang)[18] と 本多 清志 (Kiyoshi Honda)[19] など数多くの科学者によって開拓されている。

Remove ads

商用モデル

数少ない商用の調音スピーチ・シンセシス・システムの一つは、NeXTベースのシステムで、多数の独自研究が実施されていたカナダのカルガリー大学のスピンオフ企業 Trillium Sound Researchにより開発・販売された。 1980年代後半スティーブ・ジョブスが設立し、1997年Apple Computerと合併した NeXTの様々な転生が消滅した後、TrilliumのソフトウェアはGNU General Public Licenseで公開され、Gnuspeech[20]として継続している。 1994年に最初に発売されたこのシステムは、René Carré[21]の"Distinctive Region Model" (DRM)[22][23]で制御される、人間の口腔および鼻腔の導波路 (waveguide) モデルもしくは 伝送路アナログ(transmission-line analog) を使った[24](訳注: Tube Resonance Model (TRM)[25])、フル調音ベースのテキスト読み上げ変換を提供する。

Remove ads

関連項目

脚注

参考文献

外部リンク

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads