Timeline

Chat

Prospettiva

Algoritmo

in informatica e matematica, il termine algoritmo indica un procedimento che risolve un determinato problema Da Wikipedia, l'enciclopedia libera

Remove ads

In matematica e informatica un algoritmo è la specificazione di una sequenza finita di operazioni (dette anche istruzioni) che consente di risolvere tutti i quesiti di una stessa classe o di calcolare il risultato di un'espressione matematica.

Un algoritmo deve essere

- finito: è costituito da un numero finito di istruzioni e deve sempre terminare;

- deterministico: partendo dagli stessi dati in ingresso, si devono ottenere i medesimi risultati;

- non ambiguo: le operazioni non devono poter essere interpretate in modi differenti;

- generale: deve essere applicabile a tutti i problemi della classe a cui si riferisce, o ai casi dell'espressione matematica.

Il termine deriva dalla trascrizione latina del nome del matematico persiano al-Khwarizmi,[1] vissuto nel IX secolo d.C., che è considerato uno dei primi autori ad aver fatto riferimento a questo concetto nel suo libro: ‘Regole di ripristino e riduzione’.[2]

Le prime nozioni di algoritmo si trovano in documenti risalenti al XVII secolo a.C., conosciuti come i papiri di Ahmes, noti anche come papiri di Rhind,[3] che contengono una collezione di problemi con relativa soluzione comprendendo un problema di moltiplicazione che lo scrittore dichiara di aver copiato da altri papiri anteriori di due secoli.

L'algoritmo è un concetto fondamentale dell'informatica, anzitutto perché è alla base della nozione teorica di calcolabilità: un problema è calcolabile quando è risolvibile mediante un algoritmo. Inoltre, l'algoritmo è un concetto cardine anche nella fase di programmazione dello sviluppo di un software: preso un problema da automatizzare, la programmazione costituisce essenzialmente la traduzione o codifica di un algoritmo per tale problema in programma, scritto in un certo linguaggio, che può essere quindi effettivamente eseguito da un calcolatore rappresentandone la logica di elaborazione.

Remove ads

Definizione

Riepilogo

Prospettiva

Il primo algoritmo informatico è stato ideato dalla matematica britannica Ada Lovelace, per il calcolo dei numeri di Bernoulli. Nel XX secolo, il concetto di algoritmo venne formalizzato per risolvere il problema matematico della "decisione" (Entscheidungsproblem), posto da David Hilbert nel 1928, e altre successive formalizzazioni giunsero con lo sviluppo dei concetti di "calcolabilità effettiva"[4] e di "metodo effettivo"[5]. Le formalizzazioni matematiche più famose sono le funzioni ricorsive di Gödel–Herbrand–Kleene del 1930, 1934 e 1935; il lambda calcolo di Alonzo Church e la Formulation 1 di Emil Leon Post del 1936; e, infine, la macchina di Turing del 1936–37 e 1939. Nonostante ciò, una definizione del concetto di algoritmo che sia formale e non tecnica manca tuttora[6] e si è pertanto costretti ad accontentarsi dell'idea intuitiva di algoritmo come "una sequenza ordinata e finita di passi (operazioni o istruzioni) elementari che conduce a un ben determinato risultato in un tempo finito".

Modelli formali

La definizione di algoritmo appena riportata è piuttosto informale, mentre era necessario disporre di una definizione più rigorosa per trattare il concetto di algoritmo con strumenti matematici. Al tal fine sono stati definiti alcuni modelli matematici di algoritmo, fra i quali uno dei più celebri è la macchina di Turing. Essa rappresenta una sorta di computer ideale corredato di un programma da eseguire, ma, rispetto a un computer reale, la macchina di Turing ha un funzionamento estremamente più semplice che possa essere facilmente descritto con termini matematici, facendo uso di concetti come insieme, relazione e funzione.

La macchina di Von Neumann, che è il modello di architettura primigenio di tutti i computer attuali, è equivalente, in termini di potere di calcolo, alla macchina di Turing. In altre parole, è stato dimostrato che un certo problema può essere risolto da un computer (opportunamente programmato) se e solo se esso può essere risolto anche da una macchina di Turing. Oltre alla macchina di Turing, proposta da Alan Turing nel 1936, nello stesso periodo altri matematici hanno elaborato diverse rappresentazioni formali del concetto di algoritmo, fra i quali ricordiamo, per esempio, il lambda calcolo. Dopo alcuni anni, emerse che tutti questi modelli erano equivalenti: i problemi che una macchina di Turing poteva risolvere erano gli stessi che poteva risolvere una macchina di von Neumann e anche gli stessi che poteva risolvere una funzione costruita col lambda calcolo[senza fonte].

Da questi risultati, tra l'altro, scaturì la tesi di Church-Turing, che afferma che qualsiasi algoritmo sia modellabile con una macchina di Turing. In altri termini, questa tesi sostiene che è sostanzialmente impossibile cercare di immaginare un modello di algoritmo più potente e, di conseguenza, che nessuna macchina potrà mai risolvere problemi che una macchina di Turing non possa risolvere in linea di principio. Non si tratta di un teorema dimostrato matematicamente, poiché la tesi stabilisce l'eguaglianza di due concetti, l'algoritmo e la macchina di Turing, ma il primo non possiede una definizione formale. La tesi è oggi generalmente condivisa, sebbene i progressi nelle ricerche nel settore dell'ipercomputazione sembrino talvolta metterla in discussione.

Vi è anche l'algoritmo di Hirschberg, dal nome del suo creatore, Dan Hirschberg, di programmazione dinamica che trova l'allineamento ottimale della sequenza tra due stringhe.

Proprietà fondamentali degli algoritmi

Dalla precedente definizione di algoritmo si evincono alcune proprietà necessarie, senza le quali un algoritmo non può essere definito tale:

- i passi costituenti devono essere "elementari", ovvero non ulteriormente scomponibili (atomicità);

- i passi costituenti devono essere interpretabili in modo diretto e univoco dall'esecutore, sia esso umano o artificiale (non ambiguità);

- l'algoritmo deve essere composto da un numero finito di passi e richiedere una quantità finita di dati in ingresso (finitezza)

- l'esecuzione deve avere termine dopo un tempo finito (terminazione);

- l'esecuzione deve portare a un risultato univoco (effettività).

Così, ad esempio, "rompere le uova" può essere considerato legittimamente un passo elementare di un "algoritmo per la cucina" (ricetta), ma non potrebbe esserlo anche "aggiungere sale quanto basta" dato che l'espressione "quanto basta" è ambigua, e non indica con precisione quali passaggi servano per determinare la quantità necessaria.

All'istruzione non elementare di preparazione della crema potrebbe, però, essere associato un opportuno rimando a un'altra sezione del ricettario, che fornisca un sotto-algoritmo apposito per questa specifica operazione. Questo suggerisce che, per comodità d'implementazione, gli algoritmi possano essere modulari, ovvero orientati a risolvere specifici sotto-problemi, e gerarchicamente organizzati. Inoltre, una ricetta che preveda la cottura a microonde non può essere preparata da un esecutore sprovvisto dell'apposito elettrodomestico; questo rimanda al problema della realizzabilità degli algoritmi, ovvero della loro compatibilità con le risorse materiali e temporali a disposizione. Infine, possono darsi più algoritmi validi per risolvere uno stesso problema, ma ognuno con un diverso grado di efficienza.

L'algoritmo viene generalmente descritto come "procedimento di risoluzione di un problema". In questo contesto, i "problemi" che si considerano sono quasi sempre caratterizzati da dati di ingresso (input) variabili, su cui l'algoritmo stesso opererà per giungere fino alla soluzione. Per esempio, il calcolo del massimo comune divisore fra due numeri è un esempio di "problema", e i suoi dati di ingresso, variabili di volta in volta, sono i due numeri in questione. A un non matematico questa potrebbe apparire come una "famiglia di problemi" (il problema di calcolare il massimo comune divisore fra 10 e 15, il problema di calcolarlo fra 40 e 60, fra 35 e 95, e così via). Il matematico e l'informatico identificano con la parola "problema" l'intera famiglia e con "istanza" o "x" ciascuno dei quesiti specifici ottenuti fissando due particolari valori. Data questa premessa, un algoritmo risolve un problema se per qualunque istanza del problema esso produce in un tempo finito la soluzione desiderata, ovvero un certo risultato o dato in uscita (output) a partire da dei dati in ingresso (input).

Se questa idea aveva già una certa importanza per il calcolo matematico, l'avvento dell'informatica l'ha arricchita di una nuova importanza, ed è infatti con l'informatica che il termine "algoritmo" ha iniziato a diffondersi. Difatti, se per ottenere un certo risultato (risolvere un certo problema) esiste un procedimento infallibile, che può essere descritto in modo non ambiguo fino ai dettagli, e conduce sempre all'obiettivo desiderato in un tempo finito, allora esistono le condizioni per affidare questo compito a un computer, semplicemente introducendo l'algoritmo in questione in un programma scritto in un opportuno linguaggio comprensibile alla macchina.

Inizialmente un algoritmo può essere descritto attraverso l'uso di un diagramma di flusso o ricorrendo a uno pseudocodice. Successivamente, nella fase di programmazione l'algoritmo così scritto verrà tradotto in linguaggio di programmazione a opera di un programmatore sotto forma di codice sorgente dando vita al programma che sarà eseguito dal calcolatore, eventualmente dopo un'ulteriore traduzione in linguaggio macchina. Particolare rilevanza teorica in tale ambito assume il teorema di Böhm-Jacopini che afferma che qualunque algoritmo può essere implementato utilizzando tre sole strutture, la sequenza, la selezione e il ciclo (iterazione), da applicare ricorsivamente alla composizione di istruzioni elementari. Nella pratica corrente il programmatore professionista nel suo lavoro svolge automaticamente questo processo di traduzione scrivendo direttamente il codice sorgente necessario nelle suddette modalità avendo già trovato la soluzione al problema dato.

Remove ads

Approccio matematico

Riepilogo

Prospettiva

Esistono numerosi modelli matematici di algoritmo. In generale, un algoritmo riceve un insieme di valori (dati) in input e ne genera uno in output (chiamato soluzione). Dato dunque un algoritmo A si denota con fA la funzione che associa a ogni ingresso x di A la corrispondente uscita.

Questa corrispondenza tra input e output non rappresenta il problema risolto dall'algoritmo. Formalmente, un problema è una funzione definita su insieme Di di elementi che chiameremo restanze, a valori su un insieme Ds di risoluzioni.

Lo studio di un algoritmo viene suddiviso in due fasi:

- sintesi (detta anche disegno o progetto): dato un problema A, costruire un algoritmo f per risolvere A, cioè tale che f=fa.

- analisi: dato un algoritmo f e un problema A, dimostrare che f risolve A, cioè f=fa (correttezza) e valutare la quantità di risorse usate da f (complessità concreta).

Formalizzazione di un problema

A ogni problema si ha che: dove sono le istanze del problema e sono le soluzioni e sia una soluzione al problema per l'istanza x.

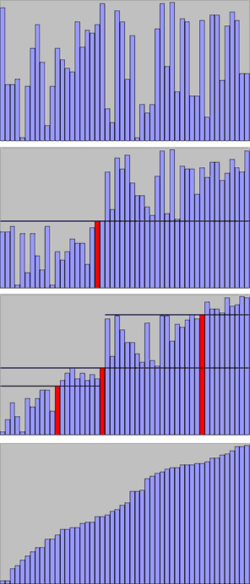

Studio della complessità computazionale di un algoritmo

Un'ampia porzione della teoria degli algoritmi è lo studio della complessità, computazionale e spaziale. Vogliamo cioè sapere, al crescere della complessità del problema, in che modo cresce il tempo necessario a eseguire l'algoritmo e lo spazio di memoria occupato in un calcolatore.

La complessità di un algoritmo si misura asintoticamente. Vi sono quattro metodi per calcolare la complessità di un algoritmo:

- metodo di sostituzione

- metodo dell'iterazione

- metodo dell'albero

- metodo dell'esperto

Si definisce asintotica per due motivi:

- poiché ogni calcolatore può implementare algoritmi in modo differente, non si può stimare il tempo preciso

- si vuole dare un'idea quantitativa di come l'algoritmo possa crescere in consumo di tempo all'aumentare dell'input, per valori sempre maggiori.

Presa una funzione associata a un algoritmo del tipo:

si può definire la funzione peso come

che esprime la dimensione dei dati in ingresso, ossia il numero di bit che servono per codificare i dati in input all'algoritmo. Ad esempio su un vettore la lunghezza dello stesso determinerà il numero di bit necessari a codificarlo e sulle matrici il numero dell'ordine, ossia presa ad esempio una matrice quadrata l'ordine della stessa è determinata da una delle due dimensioni (orizzontale oppure verticale).

La complessità di un algoritmo si definisce come:

che indica per ogni valore intero n (ossia la dimensione del problema) la quantità di tempo e/o spazio impiegata dall'algoritmo per elaborare dati di dimensione n. Un algoritmo può comportarsi in modo sensibilmente differente anche per istanze che abbiano ugual dimensione (ossia lo stesso peso).

Si dimostra che la complessità di un algoritmo è una funzione strettamente crescente, per quale vale

Infatti è banale dimostrare che tende all'infinito al crescere di (cioè del numero di dati da elaborare), perché essa è minorata da (è un ) in quanto il numero minimo di spazi di memoria per memorizzare un insieme di dati è la sua cardinalità. Si noti che per le matrici sparse si deve considerare come numero di dati gli elementi non nulli.

Due misure per sistemi di calcolo sequenziali sono i valori e che rappresentano rispettivamente il tempo e lo spazio di memoria richiesti da un algoritmo su input . Per la sopra citata proprietà il dominio deve dunque coincidere con l'insieme . Possiamo pertanto considerare e come funzioni intere positive che rappresentano il numero di operazioni (non il tempo di esecuzione effettivo) elementari eseguite e dal numero di celle di memoria utilizzate durante l'esecuzione di sull'istante .

Descrivere le funzioni e può essere molto complicato poiché la variabile assume valori sull'insieme di tutti gli input. Una soluzione che fornisce buone informazioni su e consiste nell'introdurre il concetto di dimensione di un'istanza, raggruppando in tal modo gli input che hanno la stessa dimensione: la funzione dimensione associa a ogni ingresso un numero naturale che rappresenta intuitivamente la quantità di informazione contenuta nel dato considerato. Per esempio la dimensione naturale di un intero positivo è , cioè il numero di cifre necessario per rappresentare in notazione binaria. Analogamente la dimensione di un vettore di elementi è solitamente costituita dal numero delle sue componenti, mentre la dimensione di un grafo è data congiuntamente dal numero dei suoi nodi e dei suoi archi. La dimensione di si denota con .

Dato un algoritmo su un insieme di input , può accadere che due istanze , di ugual dimensione cioè . = . diano luogo a tempi diversi di esecuzione per uno stesso algoritmo. Si parla dunque di complessità dell'input e se ne distinguono tre casi:

- complessità nel caso peggiore

- complessità nel caso medio

- complessità nel caso migliore

Il caso medio permette di studiare l'algoritmo in base alla frequenza con cui si verificano gli input e alla complessità dell'algoritmo per ciascuno di essi:

Quando i casi sono tutti equiprobabili, il caso medio è calcolato come media aritmetica della complessità calcolata su tutti i possibili input:

Ad esempio, in un algoritmo di ricerca lineare, se l'elemento cercato è il primo della lista ci troviamo nel caso migliore, . La complessità nel caso medio è . Nel caso peggiore l'elemento cercato è l'ultimo della lista: in questo caso , ossia sono richiesti tutti gli passi per trovare la soluzione.

Il caso peggiore è quello che viene solitamente considerato per descrivere la complessità di un algoritmo. In alcuni casi (ad esempio il quicksort) viene considerato il caso medio, poiché il caso peggiore avviene molto raramente o addirittura con probabilità zero.

Complessità e stabilità

Controparte della complessità di un algoritmo, è la sua stabilità numerica: essa stabilisce quanto un algoritmo è "resistente" a degli insiemi di dati particolari. Ovviamente il discorso è generalmente correlato all'analisi numerica, e alle implementazioni di algoritmi su macchine specifiche, tuttavia potrebbero darsi algoritmi prettamente matematici che per alcuni dati forniscono risultati indeterminati, tipo , mentre altri algoritmi equivalenti con gli stessi dati arrivano comunque a dare risposte: i primi sono meno stabili dei secondi. Un esempio sono i limiti calcolati col metodo canonico, oppure col metodo di De l'Hôpital.

Esempio: studio della complessità di risoluzione dei sistemi lineari

Vogliamo trovare un algoritmo efficiente per risolvere un sistema lineare di equazioni in incognite (anche 100, 1000...). Dobbiamo cioè valutare, tra tutti gli algoritmi risolutivi disponibili, quello che impiega meno tempo e consuma meno spazio degli altri. L'Algebra ci offre due importanti metodi risolutivi di enorme interesse ai fini dello studio della complessità degli algoritmi.

- NOTA

- negli esempi si tiene conto che il sistema sia univocamente determinato. In sede di approfondimento è possibile conoscere quali sono le condizioni affinché gli algoritmi che stiamo per esporre sono applicabili

La Regola di Cramer permette la risoluzione di un sistema lineare nel modo più semplice grazie a una singola definizione:

dove è la matrice formata sostituendo la i-esima colonna di con il vettore dei termini noti. Il determinante della matrice può essere calcolato a priori, dunque serve solo il calcolo di determinanti per risolvere il sistema. Il determinante è solitamente definito tramite lo sviluppo di Laplace, che fornisce direttamente un algoritmo ricorsivo:

dove è l'elemento di coordinate e è il minore ottenuto sopprimendo la -esima riga e la -esima colonna. La complessità di questo algoritmo per il calcolo del determinante è , perché per ogni determinante di ordine si devono calcolare determinanti di ordine .

Vengono perciò utilizzati altri algoritmi con complessità migliore. (Incidentalmente, tali algoritmi sono anche alla base di metodi più efficienti per il calcolo del determinante). Uno di questi è il metodo di eliminazione di Gauss, basato su due importanti principi.

Il primo è che due sistemi lineari

- e

sono uguali se si ottiene sostituendo le righe e le colonne di con loro combinazioni lineari e gli elementi di sono combinazioni lineari degli elementi di in base ai coefficienti di .

Il secondo è che per risolvere un sistema triangolare (dove cioè la matrice dei coefficienti gode della proprietà di triangolarità) è sufficiente utilizzare l'algoritmo di sostituzione in avanti o all'indietro (la complessità computazionale è ).

Si dimostra che per trasformare il sistema in triangolare occorre un algoritmo la cui complessità è . Applicando a questo sistema l'algoritmo di sostituzione diretta si trovano le soluzioni esatte del sistema, e si dimostra che la complessità totale dell'algoritmo di Gauss è sempre .

Per quanto riguarda la complessità spaziale:

- l'algoritmo basato sulla regola di Cramer richiede soltanto una variabile aggiuntiva, dove memorizzare il determinante della matrice dei coefficienti, dunque la sua complessità è minima: (cioè per memorizzare la matrice dei coefficienti, per memorizzare il vettore dei termini noti e le soluzioni, più uno spazio anch'esso pari a per il calcolo dei determinanti)

- l'algoritmo di Gauss non richiede altro spazio oltre a quello necessario per memorizzare la matrice dei coefficienti e il vettore dei termini noti. Al termine dell'algoritmo il vettore dei termini noti conterrà la soluzione. Pertanto la sua complessità spaziale è anch'essa minima: .

Remove ads

Strutture di dati

La maggior parte degli algoritmi si avvalgono di tecniche per rappresentare ed organizzare i dati utilizzati nel calcolo e tali rappresentazioni, chiamate strutture dati, non sono necessariamente altrettanto sofisticate rispetto all'algoritmo che le usa: algoritmi semplici possono richiedere strutture dati complesse e viceversa.

Per agevolare ed astrarre la gestione e l'interazione di strutture dati complesse, vengono sviluppati appositi algoritmi che implementano le operazioni più comuni da svolgere su di esse. Esempi di strutture dati comuni sono i vettori, le liste, le code, le pile, gli alberi e i grafi.

Catalogazione degli algoritmi

Riepilogo

Prospettiva

Gli algoritmi vengono raggruppati e catalogati a seconda della loro funzione o delle tecniche utilizzate per realizzarli, tuttavia una catalogazione rigorosa e completa è ormai diventata impossibile.

In informatica è possibile catalogare gli algoritmi in:

- Algoritmi iterativi

- Algoritmi ricorsivi

- Algoritmi di ordinamento

- Algoritmi di ricerca

- Genetici evolutivi

- Swarm Intelligence

- Algoritmo combinatorio

- Codice automodificante

- Conversione e codifica

- Algoritmi di compressione

- Senza perdita di informazioni:

- Run-length encoding

- PackBits

- PCX

- Codifica a riduzione locale di Entropia

- Codifica a dizionario

- Trasformata di Burrows-Wheeler

- PPM

- Run-length encoding

- Con perdita di informazione

- Trasformata discreta del coseno (DCT)

- Compressione frattale

- Trasformazione frattale

- Wavelet

- Senza perdita di informazioni:

Molte categorie di algoritmi sono strettamente legate all'organizzazione dei dati in memoria (strutture dati).

Altri algoritmi

- Algoritmi quantistici

- Algoritmo apriori

- Algoritmo di Berger

- Algoritmo di Sturm

- Algoritmo online

- Algoritmo di pitch detection

- Algoritmo di sommatoria di Kahan

- Algoritmo di Euclide

- Algoritmo di prostaferesi

- Algoritmo di pattern matching su stringhe

- Algoritmo Doomsday

- Algoritmo di Dijkstra

- Algoritmo di Boyer-Moore

- Algoritmo di Knuth-Morris-Pratt

- Algoritmo di Prim

- Algoritmo di Gauss-Newton

- Algoritmo della linea di Bresenham

- Algoritmo del simplesso

- Algoritmo delle colonie di formiche

- Algoritmo del banchiere

- Algoritmo del fornaio

- Algoritmo dell'ascensore

- Algoritmo del puzzle

- Algoritmo del biglietto

- Algoritmo dello spaccone

Remove ads

Note

Bibliografia

Voci correlate

Altri progetti

Collegamenti esterni

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads

![{\displaystyle [1+log_{2}{k}]}](http://wikimedia.org/api/rest_v1/media/math/render/svg/fde362a38bfbaacd693685bf0a7dafb069a20f72)