Najlepsze pytania

Chronologia

Czat

Perspektywa

Zależność zmiennych losowych

Z Wikipedii, wolnej encyklopedii

Remove ads

Zależność statystyczna zmiennych losowych (korelacja, asocjacja[1]) – związek pomiędzy dwiema zmiennymi losowymi i

Intuicyjnie, zależność dwóch zmiennych oznacza, że znając wartość jednej z nich, dałoby się przynajmniej w niektórych sytuacjach dokładniej przewidzieć wartość drugiej zmiennej, niż bez tej informacji.

W dalszej części artykułu będziemy rozważać zmienne losowe o wartościach rzeczywistych i zdarzenia określone na ustalonej przestrzeni probabilistycznej Jeśli jest zmienną losową, to symbolem oznaczać będziemy jej rozkład.

Remove ads

Zmienne rzeczywiste

Podsumowanie

Perspektywa

Niezależność statystyczna

Mówimy, że zmienne losowe są niezależne, gdy dla każdych liczb rzeczywistych zachodzi równość

Powyższy wzór jest uogólniany na dowolną liczbę zmiennych (por. rozdział Zmienne losowe o wartościach rzeczywistych.)

W szczególności niezależność każdej dla pary zmiennych nie oznacza koniecznie niezależności wszystkich zmiennych

Zależność statystyczna

Mówimy, że zmienne losowe są zależne, gdy nie są one niezależne – to znaczy, dla pewnych liczb rzeczywistych

lub w języku dystrybuant:

Szczególne przypadki

Zależność monotoniczna

Dodatnia zależność monotoniczna zachodzi, gdy zwiększenie wartości jednej ze zmiennych oznacza zwiększenie wartości oczekiwanej drugiej zmiennej. Analogicznie ujemna zależność monotoniczna zachodzi, gdy zwiększenie jednej ze zmiennych oznacza zmniejszenie drugiej.

Ściśle zależność monotoniczna (a konkretniej jej odmiana zwana Quadrant Dependence) została określona przez Lehmana (1966). Dodatnia zależność monotoniczna:

Ujemna zależność monotoniczna:

Istnieją też inne definicje zależności monotonicznej. Lehman podał także dwie silniejsze definicje, a Kowalczyk i Pleszczyńska (1977) także definicję słabszą.

Powyższe definicje obejmują skrajny przypadek zależności zmiennych W praktyce zależność nie musi być pełna. Miarą stopnia zależności monotonicznej są współczynniki korelacji rangowej.

Zależność liniowa

- Szczególnym przypadkiem zależności monotonicznej jest zależność liniowa. W przypadku skrajnym zachodzi, gdy jedna ze zmiennych jest liniowo zależna od drugiej zmiennej. W praktyce tu również zależność nie musi być pełna. Miarą stopnia zależności liniowej jest np. współczynnik korelacji Pearsona.

- Jeżeli zmienne losowe są niezależne i całkowalne, to ich kowariancja jest równa zeru. Bezpośrednim wnioskiem z tego twierdzenia jest następujący fakt:

- Jeżeli zmienne losowe są całkowalne i parami niezależne, to

Remove ads

Zmienne losowe o wartościach rzeczywistych

Podsumowanie

Perspektywa

Zmienne losowe nazywamy niezależnymi, gdy dla każdego ciągu zbiorów borelowskich (na prostej) spełniony jest warunek

Innymi słowy, zmienne są niezależne wtedy i tylko wtedy, gdy generowane przez nie σ-ciała[2] są niezależne.

Używając zmiennych losowych, możemy opisywać niezależność zdarzeń. I tak, zdarzenia są niezależne wtedy i tylko wtedy, gdy niezależne są ich funkcje charakterystyczne rozpatrywane jako zmienne losowe. Często wygodnie jest używać następującej charakteryzacji niezależności zmiennych losowych:

Jeśli są zmiennymi losowymi, to każde dwa z następujących zdań są równoważne:

- Zmienne losowe są niezależne.

- tzn. rozkład łączny wektora losowego jest produktem rozkładów odpowiednich zmiennych losowych.

- dla każdych liczb rzeczywistych tzn. dystrybuanta wielowymiarowa wektora losowego jest iloczynem dystrybuant odpowiednich zmiennych losowych.

Ponadto, jeśli zmienne losowe mają rozkłady ciągłe, a są ich gęstościami, to są one niezależne gdy funkcja

jest gęstością wektora losowego

Jeżeli są zmiennymi losowymi o rozkładach dyskretnych, a są takimi zbiorami przeliczalnymi, że

to zmienne te są niezależne wtedy i tylko wtedy, gdy dla każdych liczb zachodzi równość

Jeżeli, natomiast, zmienne losowe są niezależne, a jest ściśle rosnącym ciągiem liczb ze zbioru to σ-ciała

są niezależne.

Niezależność dowolnej rodziny zmiennych losowych

Jeśli gdzie jest pewnym zbiorem indeksów, jest rodziną zmiennych losowych określonych na tej samej przestrzeni probabilistycznej, to mówimy, że jest ona niezależna, gdy dla każdej liczby naturalnej oraz dla każdego zbioru indeksów będacego podzbiorem niezależne są zmienne losowe

Wartość oczekiwana iloczynu niezależnych zmiennych losowych

Korzystając z twierdzenia Fubiniego, można dowieść, że jeśli są niezależnymi zmiennymi losowymi, to wartość oczekiwana modułu ich iloczynu wyraża się wzorem

Jeśli ponadto, zmienne te są całkowalne, to

Twierdzenie odwrotne nie jest jednak prawdziwe – niech oraz niech będzie σ-ciałem zbiorów borelowskich na tym zbiorze, a będzie obcięciem miary Lebesgue’a do tego σ-ciała. Rozważmy następujące zmienne losowe

Wartość oczekiwana każdej z nich oraz ich iloczynu wynosi 0, natomiast zmienne te nie są niezależne, gdyż w przeciwnym razie byłyby niezależne zmienne

czyli w konsekwencji dla każdego zbioru borelowskiego byłby spełniony warunek

co oczywiście nie jest prawdą.

Remove ads

Niektóre twierdzenia wykorzystujące założenie niezależności zmiennych

- Funkcja charakterystyczna sumy niezależnych zmiennych losowych jest iloczynem funkcji charakterystycznych tych zmiennych.

- Funkcja tworząca sumy niezależnych zmiennych losowych (przyjmujących wartości w zbiorze liczb naturalnych z zerem) jest iloczynem funkcji tworzących tych zmiennych losowych.

- Prawo zero-jedynkowe Kołmogorowa

- Jeżeli jest ciągiem niezależnych zmiennych losowych, to

- Rozkład sumy niezależnych zmiennych losowych, z których choć jedna ma rozkład ciągły, jest rozkładem ciągłym.

- Gęstością sumy niezależnych zmiennych losowych o rozkładach ciągłych jest splot gęstości tych zmiennych losowych.

- Rozkładem (dystrybuantą) sumy niezależnych zmiennych losowych jest splot rozkładów (dystrybuant) tych zmiennych.

- Twierdzenie Kołmogorowa-Prochorowa

- Tożsamość Walda

- Nierówność Kołmogorowa

- Twierdzenie Kołmogorowa

- Twierdzenie Poissona

- Twierdzenie Gliwenki

Popularne błędy

Podsumowanie

Perspektywa

Zależność a rozkłady zmiennych

Znając rozkłady brzegowe każdej ze zmiennych z osobna, nic nie da się powiedzieć o ewentualnej zależności lub braku zależności pomiędzy nimi. Na przykład między dwiema zmiennymi i przyjmującymi każdą z wartości {1,2,3,4,5,6} z tym samym prawdopodobieństwem (rozkład jednostajny dyskretny), może istnieć korelacja ujemna, dodatnia, lub mogą być niezależne:

- Jeśli zmienna jest wynikiem rzutu kostką, a to zmienne i są zależne, współczynnik korelacji wynosi -1

- Jeśli zmienna jest wynikiem rzutu kostką, a to zmienne i są zależne, współczynnik korelacji wynosi +1

- Jeśli każda z nich modeluje wyniki rzutu inną kostką, to zmienne i są niezależne, współczynnik korelacji wynosi 0.

- Jeśli zmienna jest wynikiem rzutu kostką, a jest w części przypadków równe a w pozostałych przypadkach równe wynikowi rzutu drugą kostką, to zmienne i są zależne, współczynnik korelacji będzie gdzieś pomiędzy 0 a +1.

W każdym z tych przypadków rozkład brzegowy każdej ze zmiennych jest identyczny, jednak różni się ich rozkład łączny. W trzech pierwszych przypadkach różni się np. zbiór możliwych wartości pary

- W pierwszym przypadku jest to

- W drugim przypadku

- W trzecim przypadku Zmienne są niezależne, bo informacja o wartości jednej z nich nic nie mówi o wartości drugiej.

- W czwartym przypadku zbiór możliwych wartości jest taki sam jak w trzecim, jednak różnią się prawdopodobieństwa, z jakimi są one przyjmowane. Znajomość zmiennej pozwala dokładniej przewidywać znajomość zmiennej (formalnie: rozkład warunkowy zmienia się w zależności od ), więc są zależne.

Zależność jest więc cechą rozkładu łącznego porównywanych zmiennych.

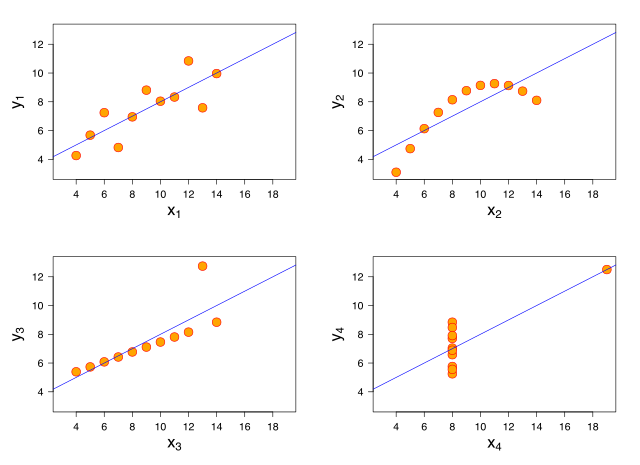

Zależność a współczynnik korelacji

Często błędnie zakłada się, że zależność statystyczna jest równoważna niezerowemu współczynnikowi korelacji. Nie jest to prawda. Na przykład zmienne i mogą być związane zależnością:

Jest to przykład ścisłej zależności. Jednak zarówno klasyczna korelacja Pearsona, jak i rangowa dadzą wartość zero (dla próbki – bliską zeru), gdyż zależność ta nie jest monotoniczna, ani tym bardziej liniowa.

Zależność a wynikanie

Częstym błędem jest przyjmowanie, że zmienna nawet silnie skorelowana z inną jest jej skutkiem. Uświadamia to taki oto przykład: dźwięk dworcowego zegara wybijającego godzinę pierwszą jest niezwykle silnie skorelowany z odjazdem pociągu o 1:00 ze stacji, nie jest on jednak żadną przyczyną ruchu – i odwrotnie, odjazd pociągu nie jest przyczyną dźwięku. W tym wypadku mamy jedynie do czynienia ze współwystępowaniem zjawisk, a nie związkiem przyczynowo-skutkowym. W związku z tym jeśli czynnik A (np. wykształcenie) i czynnik B (np. zarobki) korelują ze sobą, to powinno się tworzyć przynajmniej kilka hipotez na temat ewentualnego związku przyczynowego między nimi:

- Czynnik A wpływa na czynnik B. Tu: wykryto związek między zarobkami a wykształceniem, bo wyższe wykształcenie powoduje że dana osoba więcej zarabia.

- Czynnik B wpływa na czynnik A. Tu: ludzie zamożniejsi mają lepszy dostęp do wykształcenia i dlatego istnieje związek między zarobkami a wykształceniem.

- Jednocześnie A wpływa na B i B na A Tu: z jednej strony ludzie zamożniejsi mają lepszy dostęp do wykształcenia, ale z drugiej ludzie lepiej wykształceni mają lepsze zarobki.

- Istnieje czynnik C niezidentyfikowany w badaniu, który koreluje z A i z B. Tu: miejsce zamieszkania (lub ambicje) mogą być czynnikiem, który z jednej strony powoduje, że ktoś więcej zarabia, a z drugiej, że ma wyższe wykształcenie.

Korelacja nie dowodzi więc żadnego związku przyczynowo-skutkowego.

Wśród statystyków jako przykład podawana jest anegdota o tym, że wykryto istotną statystycznie dodatnią zależność pomiędzy liczbą bocianów przypadających na km² w danym skupisku ludzkim, a przyrostem naturalnym na tym obszarze. Oczywiście nie dowodzi to, że bociany przynoszą dzieci. Na wsi jest średnio większy przyrost naturalny i czasem żyją tam bociany. W mieście przyrost jest mniejszy i nie ma bocianów. Istnienie trzeciej zmiennej – miasto / wieś, skorelowanej zarówno z liczbą bocianów, jak i z przyrostem naturalnym powoduje powstanie zależności także tamtych dwóch zmiennych.

W innej wersji mówi się o korelacji liczby bocianów z liczbą dzieci na tym samym terenie wiejskim w skali wielu lat. Okazuje się, że liczba bocianów jest skorelowana dodatnio z ciepłym latem, a przy dobrej pogodzie wzrastać ma też liczba par kochających się na łonie natury.

Prawdopodobnie nie są to wyniki poważnych badań, lecz tylko legenda, niemniej jest ona dobrą ilustracją, jak może powstawać zależność, niebędąca związkiem przyczynowo-skutkowym[3].

Podobnie, można by się dopatrzyć silnej dodatniej korelacji między wzrostem liczby ludności w Indiach a liczbą samochodów w Polsce, choć jest to jedynie czysto statystyczna korelacja, współwystępowanie zjawisk, a nie jakikolwiek związek przyczynowo-skutkowy.

Innym przykładem jest korelacja liczby zgonów osób bezdomnych w Indiach a poziomem spożycia lodów w Stanach Zjednoczonych. Tu trzecią zmienną jest średnia temperatura lata na półkuli północnej. Jej zwiększenie powoduje więcej zgonów spowodowanych upałem i oczywiście zwiększenie spożycia lodów.

Niesprawdzanie istotności statystycznej oraz wielkości efektu

Przy zbyt małej próbie fałszywe korelacje mogą powstać zupełnie przypadkowo[4], stąd ważne jest sprawdzanie istotności statystycznej uzyskanego wyniku. Przy bardzo dużych próbach – a co za tym idzie, bardzo wysokiej mocy statystycznej – istotność osiągają nawet mikroskopijne współzmienności, co z kolei wskazuje na to, że ważne jest branie pod uwagę wielkości efektu zaobserwowanych zależności. Miarą wielkości efektu dla korelacji jest współczynnik korelacji.

Obserwacje odstające

Innym częstym błędem jest niesprawdzanie, czy w próbie nie występują obserwacje odstające, które mogą całkowicie przekłamać wartość i znak współczynnika korelacji Pearsona.

Remove ads

Zobacz też

Przypisy

Bibliografia

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads

![{\displaystyle \Omega =[0,1]}](http://wikimedia.org/api/rest_v1/media/math/render/svg/a16b39940ed262a459907035d290bf78c18134b8)

![{\displaystyle P(\{\omega \in [0,1]\colon \,\sin(2\pi \omega )\in B\})\in \{0,1\},}](http://wikimedia.org/api/rest_v1/media/math/render/svg/8220afb7ff7698ccf8df0969408a161693ecba13)