Najlepsze pytania

Chronologia

Czat

Perspektywa

Historia informatyki

aspekt historii Z Wikipedii, wolnej encyklopedii

Remove ads

Historia informatyki – rozpoczyna się w XVII wieku, kiedy to podjęto pierwsze próby skonstruowania maszyny mechanicznej, mogącej dokonywać automatycznych obliczeń. Duże znaczenie dla rozwoju informatyki przyniosły prace Charlesa Babbage’a nad maszynami liczącymi. Gwałtowny rozwój informatyki przypadł na lata 40. XX wieku, gdy powstały pierwsze elektromechaniczne maszyny cyfrowe, elektroniczne maszyny cyfrowe, a następnie pierwszy komputer. Do rozwoju informatyki przyczyniły się również prace teoretyczne Alana Turinga i Johna von Neumanna. Wynalezienie mikroprocesora na przełomie lat 70. i 80. umożliwiło upowszechnienie komputerów.

Remove ads

Pierwsze maszyny liczące

Podsumowanie

Perspektywa

Pierwsze próby konstrukcji maszyn mechanicznych mogących dokonywać automatycznych obliczeń podjęto w wiekach XVII–XIX[1]. Maszyny liczące konstruowali m.in. Wilhelm Schickard (1623 lub 1624[2][3]), Blaise Pascal (tzw. Pascalina; 1642[4] lub 1641–1645[5]), Samuel Morland (1666 lub 1668[5][6]) czy Gottfried Wilhelm Leibniz (1671)[7]. Jako pierwszy przykład komputera jest również wymieniany mechanizm z Antykithiry zbudowany między 150 a 100 rokiem p.n.e.[8] Mechanizm służył do obliczania ruchu Słońca, Księżyca, Merkurego, Wenus, Marsa, Jowisza i Saturna, przewidywania zaćmień Księżyca i Słońca[9].

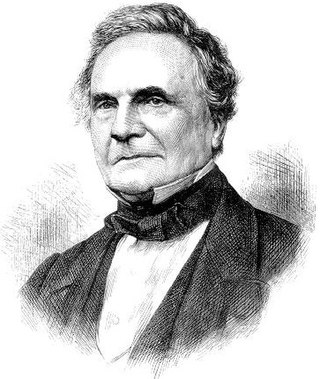

W latach 30. XIX wieku Charles Babbage skonstruował uniwersalną automatyczną maszynę analityczną[10]. Jej podstawy opracował w 1822 roku[11]. Była ona wyposażona w pamięć i jednostkę liczącą sterowaną programem zapisanym na karcie perforowanej[10]. Współpracowniczką Babbage’a była lady Ada Lovelace, której przypisywane jest napisanie w 1843 roku ciągu szczegółowych instrukcji, które pozwalały w sposób systematyczny wygenerować liczby Bernoulliego[12][13][a]. Zestaw instrukcji uchodzi za pierwszy zapis programu komputerowego[14]. W XIX w. prototypy maszyn analitycznych opracowali również George Boole i Augustus De Morgan. Boole zasłynął również z wprowadzenia metod algebraicznych do logiki, współtworząc logikę matematyczną[15].

W 1931 roku Kurt Gödel wykazał, że każde rozumowanie matematyczne można przedstawić w formie algorytmu[16]. W 1936 roku Alan Turing przedstawił koncepcję abstrakcyjnego modelu urządzenia wykonującego algorytmy (tzw. maszynę Turinga). Pomysł Turinga zakładał nieskończenie długą taśmę podzieloną na kwadratowe komórki ułożone w szeregu. Wnętrze komórek było wypełnione cyframi 0, 1 lub pozostawało puste. W maszynie Turinga znajdował się również procesor odczytujący taśmę i wykonujący jedno z sześciu prostych działań. Wynikiem pracy procesora była zapisana na taśmie wartość końcowa[17]. W 1937 roku Claude Shannon zaprezentował syntezę technologii elektromechanicznej, algebry Boole’a i systemu binarnego[16]. John von Neumann (przez wiele lat nazywany „ojcem komputerów”) opracował ideę maszyny cyfrowej, która miała opierać się m.in. na binarnym układzie arytmetycznym i rozdziale programu i danych w pamięci[16].

W latach 1937–1942 John Vincent Atanasoff i jego asystent Clifford Berry zbudowali komputer Atanasoff-Berry Computer (ABC), będący pierwszym elektronicznym komputerem cyfrowym. Choć ABC był pierwszym komputerem cyfrowym, aż do 1973 roku patent na urzędzenie tego typu należał do komputera ENIAC z 1946 roku[18]. Za wynalezienie elektronicznego komputera Atanasoff został w 1990 roku odznaczony medalem National Medal of Technology[19].

Remove ads

Lata 40. i 50. XX wieku

Podsumowanie

Perspektywa

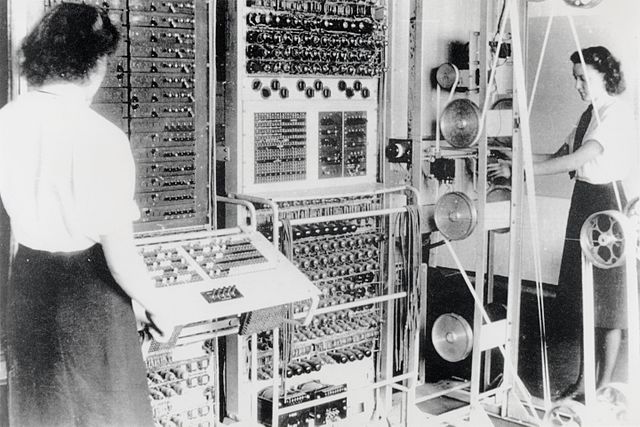

Podczas II wojny światowej udoskonalono maszyny matematyczne, głównie na potrzeby wojskowe[10]. Alan Turing pracował nad maszynami obliczeniowymi, które umożliwiłyby złamanie kodów Enigmy. Efektem prac była tzw. bomba Turinga, stanowiąca rozwinięcie bomby kryptologicznej skonstruowanej przez Mariana Rejewskiego[20][21]. Następnie Turing pracował nad Colossusem, pierwszą w pełni programowaną maszyną cyfrową do łamania szyfrów, uruchomioną w grudniu 1943 roku[20][10][22].

W 1944 roku na Uniwersytecie Harvarda zakończono prace nad komputerem elektromechanicznym ogólnego zastosowania ASCC (również znanym jako Harvard Mark I). Komputer przeprowadzał trzy operacje dodawania i odejmowania albo jedną operację mnożenia na sekundę[10]. Głównym konstruktorem Mark I był Howard Aiken. W pracach nad serią komputerów Mark (I, II i III) aktywnie uczestniczyła Grace Hopper[23]. Na zbudowanym w 1947 roku komputerze Mark II zarejestrowano pierwszy błąd komputerowy: w złączach znaleziono owada (ang. bug), który powodował awarie doprowadzające do generowania nieprawidłowych wyników obliczeń[24]. Grace Hopper przypisuje się stworzenie i upowszechnienie terminu „bug” jako nazwę błędu sprzętu lub oprogramowania[24].

6 maja 1949 roku na Uniwersytecie Cambridge uruchomiono komputer lampowy z programowalną pamięcią EDSAC[25][26]. Kierownikiem prac nad budową EDSAC był Maurice Wilkes. Był to pierwszy komputer, w którym przebieg programu i obróbka danych była zakodowana w pamięci urządzenia[25].

W III Rzeszy głównym konstruktorem maszyn liczących był Konrad Zuse. W 1938 roku stworzył maszynę liczącą Z1, która wykorzystywała system binarny i liczby zmiennoprzecinkowe[27][28]. W 1941 roku Zuse uruchomił Z3[29]. Był to pierwszy elektroniczny komputer w historii[30]. Cztery lata później ukończył pracę nad językiem programowania Plankalkül[31].

15 lutego 1946 roku w Stanach Zjednoczonych John William Mauchly i John Presper Eckert skonstruowali komputer ENIAC[27]. Składający się z około 18 tys. lamp elektronowych ENIAC umożliwiał zsumowanie 5 tys. liczb w ciągu sekundy. Główną wadą ENIAC–a była jego skomplikowana budowa (ustawienie programu obliczeń trwało kilka godzin i polegało na połączeniu wielu kabli i ręcznym przełączaniu sześciu tysięcy przełączników), stosowane setek kart perforowanych przed uruchomieniem programu, duża energochłonność, zawodność lamp próżniowych oraz wydzielanie bardzo dużej ilości ciepła przez nie[10]. Opinia publiczna dowiedziała się o istnieniu komputera latem 1946 roku[27]. Powszechnie przyjmuje się, że ENIAC był pierwszym elektronicznym komputerem w historii, choć faktycznie wcześniej powstały modele Atanasoffa i Berry’ego, Zusego oraz brytyjski Colossus[30][32]. Informacje o Colossusie odtajniono w 1975 roku[32]. W październiku 1955 roku ENIAC został wyłączony[27].

Prace nad komputerami prowadził również IBM. 7 sierpnia 1944 roku IBM wraz z Howardem Aikenem skonstruował cyfrową maszynę liczącą ASCC (ang. Automatic Sequence Controlled Calculator)[33]. W 1948 roku IBM uruchomiło swoją pierwszą maszynę liczącą. SSEC (Selective Sequence Electronic Calculator) był kalkulatorem umożliwiającym wybór sekwencji obliczeń. Komputer był stosowany w celach naukowych, przy jego pomocy wyprodukowano tablice ruchu Księżyca, których użyto podczas misji Apollo 11[34].

Remove ads

Rozwój informatyki w latach 60. i 70. XX wieku

Podsumowanie

Perspektywa

Pierwsze komputery stosowano do obliczeń naukowo-technicznych. Ich szersze zastosowanie w ośrodkach naukowych, wojsku, a następnie wśród przedsiębiorców, nastąpiło po 1951 roku, gdy opracowano metody przetwarzania danych[35]. W 1950 roku taśma magnetyczna zaczęła wypierać taśmy dziurkowane i karty perforowane[36]. 14 czerwca 1951 roku uruchomiono UNIVAC I, zaprojektowany przez Johna Mauchly’ego i Johna Eckerta pierwszy komputer dostępny w wolnej sprzedaży[37]. W tym samym okresie IBM rozpoczęła produkcję komputerów serii 700 ogólnego przeznaczenia. Pierwszym z nich był IBM 701 z 1952 roku[38].

Wraz z rozwojem samych komputerów rozwijała się także cała branża z nimi związana: w 1952 roku Grace Hopper pracowała nad FLOW-MATIC, pierwszym kompilatorem w historii[39], w 1953 roku wynaleziono drukarkę, dwa lata później opatentowano światłowód i dysk magnetyczny[40], w 1954 roku opracowano język programowania Fortran, który trzy lata później zaczął być wykorzystywany komercyjnie[41]. W 1956 roku IBM przedstawił RAMAC, pierwszy komputer gromadzący dane na dysku twardym[42]. W tym samym roku używając UNIVAC-a Hopper zaczęła pracę nad COBOL-em, uniwersalnym językiem programowania używanym m.in. w biznesie[43]. W następnych latach Hopper kontynuowała pracę nad COBOL-em oraz tworzyła nieoficjalne standardy języka Fortran[44].

16 grudnia 1947 John Bardeen, Walter Houser Brattain i William Brandfort Shockley wynaleźli tranzystor[45]. Zastąpił on stosowane wcześniej lampy próżniowe, wytwarzał minimalne ilości ciepła oraz działał szybciej[46]. W ciągu dziesięciu lat tranzystory wyparły wszystkie lampy elektronowe[47]. Za badania nad półprzewodnikami i wynalezienie tranzystora Bardeen, Brattain i Shockley otrzymali w 1956 roku Nagrodę Nobla[48][49][50][51].

Pierwsze komputery wyposażone w tranzystory pojawiły się po 1959 roku (np. IBM 7090, Mińsk 32 czy Odra 1304)[46]. Główną wadą tranzystorów była ich konstrukcja składająca się z wielu lutowanych połączeń. Najdrobniejsza usterka mogła przyczynić się do wyłączenia całego komputera[52].

W 1958 roku amerykański inżynier Jack Kilby zaprezentował prototyp układu scalonego. Składał się on z płytki germanu o długości 1 cm, na której utworzono pięć niezależnych elementów połączonych drucikami. Projekt Kilby’ego został udoskonalony przez Jeana Hoerniego i Roberta Noyce’a. W 1962 roku firmy Fairchild Semiconductor i Texas Instruments rozpoczęły masową produkcję układów scalonych, które wkrótce przyjęły nazwę chip[53].

W maju 1961 roku w Wielkiej Brytanii zainstalowano komputer ATLAS, który był używany jako pomoc obliczeniowa przy tworzeniu prognoz pogody i badaniach nad energią jądrową[54]. 29 czerwca 1964 roku na rynku pojawił się pierwszy procesor tekstu, stworzony przez IBM[55]. W 1965 roku John Kemeny i Thomas Kurtz opracowali BASIC, uproszczony język programowania przeznaczony do szerokiego użycia w instytucjach publicznych[56].

W 1971 roku firma Intel zaprezentowała pierwszy 4-bitowy mikroprocesor. Pierwszy model przyjął nazwę Intel 4004[53]. Miał on wielkość paznokcia i składał się z 2,3 tys. tranzystorów oraz kilku innych mikroukładów, umieszczonych w czterech blokach funkcjonalnych (sterowania, jednostki arytmetyczno-logicznej, rejestrów, wewnętrznych szyn przesyłowych)[57][53]. Jego moc obliczeniowa dorównywała ENIAC–owi[53]. W 1980 roku skonstruowano pierwszy mikroprocesor 32-bitowy[57].

W 1970 roku Niklaus Wirth stworzył język programowania Pascal[58]. Rok później IBM skonstruowało pierwszą dyskietkę[59][b].

4 kwietnia 1975 roku Bill Gates i Paul Allen założyli firmę Microsoft[62][63]. W 1976 roku w IBM wynaleziono drukarkę atramentową. W ciągu sekundy mogła wydrukować od 30 do 55 znaków[64].

Remove ads

Epoka komputerów osobistych

Podsumowanie

Perspektywa

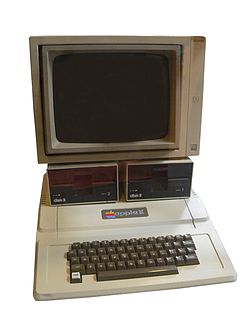

Pierwszym komputerem osobistym był skonstruowany w 1974 roku w firmie MITS Altair 8800 według projektu Eda Robertsa[65][66][67][68]. 11 kwietnia 1976 roku Steve Jobs i Steve Wozniak zaprezentowali Apple I[69]. Rok później zakończyli pracę nad Apple II, który odniósł sukces na rynku[70][71]. W 1983 roku Apple skonstruował Lisę. Komputer ten był wyposażony w mysz komputerową i graficzny interfejs użytkownika[72]. 24 stycznia 1984 roku Apple zaprezentował komputer osobisty Macintosh, korzystający z systemu ikon[73]. W 1991 roku Apple rozpoczął produkcję PowerBooków. Od 2001 roku w komputerach Apple instalowano system operacyjny Mac OS X, oparty na mikrojądrze Mach i BSD[72].

W 1980 roku IBM rozpoczęło produkcję komputerów IBM PC[70], a 8 marca 1983 roku IBM PC/XT[74]. Model ten stał się ogólnoświatowym standardem oraz przyczynił się do wybuchu boomu na komputery osobiste[57][75]. Wydany w 1981 roku przez firmę Commodore komputer VIC-20 był pierwszym komputerem osobistym, który sprzedał się w liczbie miliona egzemplarzy[76][77]. Rok później na rynku pojawił się Commodore 64, który był jednym z najlepiej sprzedających się komputerów w historii[77][78].

W kwietniu 1982 roku w Wielkiej Brytanii rozpoczęto sprzedaż komputera ZX Spectrum produkowanego przez Sinclair Research. Ze względu na swoją niską cenę był to najpopularniejszy komputer osobisty w latach 80. XX wieku[79]. 29 marca 1983 roku na rynku pojawił się pierwszy laptop. Był to ważący niecałe 2 kg TRS-80 Model 100, wyprodukowany przez firmę Tandy Corporation[80].

- Zestaw komputerowy Apple II

20 grudnia 1984 roku firma Bell Laboratories jako pierwsza wyprodukowała 1 MB pamięci operacyjnej RAM[81]. W tym samym roku firmy Philips i Sony zaprezentowały CD-ROM z odczytem danych z płyty z użyciem lasera[82]. Pierwszy CD-ROM dla komputerów osobistych pojawił się na rynku w 1985 roku[83]. 4 lipca 1985 roku czarno-biały film Yankee Doodle Dandy był pierwszym, który za pomocą komputera przetworzono na film kolorowy[84]. W 1988 roku powstał pierwszy program antywirusowy dla komputerów osobistych[85].

W lipcu 1981 roku firma Microsoft udostępniła system operacyjny MS-DOS[86]. Został on wprowadzony do komputerów IBM[87].

21 listopada 1990 roku w Wielkiej Brytanii zaprezentowano Linitekst, pierwszy program translacyjny z wszechstronnym słownictwem. Program był wyposażony w słownik angielsko-francuski liczący 35 tys. słów[88]. W 1995 roku na rynku ukazał się 64-bitowy mikroprocesor Intel Pentium Pro, mogący wykonywać 166 milionów operacji matematycznych na sekundę[89]. W tym samym roku firma Sun Microsystems zaprezentowała język programowania Java, pozwalający na tworzenie programów komputerowych działających na każdym typie komputera osobistego niezależnie bez względu na zastosowany system operacyjny. Java stała się popularna wśród webmasterów do pisania aplikacji działających w Internecie[90].

W drugiej połowie lat 90. XX wieku zaczęto dyskusję nad tzw. pluskwą milenijną – problemem zapisywania daty w systemach komputerowych. W pierwszych maszynach cyfrowych dla oszczędności miejsca rok zapisywano za pomocą dwóch ostatnich cyfr. Pomimo rosnącej wielkości pamięci komputerowej utrzymano zapis, by zachować kompatybilność ze starszymi komputerami. Po 1 stycznia 2000 roku odnotowano stosunkowo niewielką liczbę awarii[91].

Remove ads

Historia muzyki komputerowej

Podsumowanie

Perspektywa

W latach 50. rozpoczął się rozwój muzyki komputerowej, tworzonej zarówno przez komputery oraz elektroniczne generatory dźwięku[92][93]. W 1951 roku na komputerze Ferranti Mark I wykonano m.in. Hymn Wielkiej Brytanii[93]. W 1957 roku Lejaren Hiller i jego student Leonard Isaacson skomponowali Illiac Suite for String Quartet (znane również pod tytułem String Quartet No. 4. Utwór stanowił wynik prac Hillera i Isaacsona nad zautomatyzowanym procesem tworzenia kompozycji za pomocą komputera)[94]. W 1957 roku Max Mathews opracował MUSIC, program i język programowania w jednym służący do tworzenia muzyki komputerowej[93][95]. Za pomocą MUSIC Mathews skompował siedemastosekundowy utwór, który następnie wykonał na komputerze IBM 704[93]. Jednym z pierwszych kompozytorów wykorzystujących komputery do tworzenia muzyki był amerykański kompozytor francuskiego pochodzenia Edgar Varèse, który zaczął korzystać z komputerów jeszcze w latach 50.[92] W latach 60. z komputerów korzystali również Iannis Xenakis i John Cage[96].

Rozwój muzyki komputerowej przez użytkowników domowych nastąpił w latach 80., po wprowadzeniu 3-głosowego syntezatora muzycznego SID (początkowo do komputerów Commodore 64), stworzeniu systemu MIDI, a także rozpoczęciu produkcji seryjnej syntezatorów i komputerów osobistych[93][95]. W następnych latach proces tworzenia muzyki oraz metody korzystania z niej rozszerzyły się wraz z upowszechnieniem komputerów multimedialnych, płyt CD-ROM, Internetu[97] oraz sztucznej inteligencji[98].

Remove ads

Systemy operacyjne

Podsumowanie

Perspektywa

Unix

W 1969 roku pojawiła się pierwsza wersja systemu operacyjnego Unix[99]. Głównymi autorami Unixa byli Ken Thompson i Dennis Ritchie, pracujący dla AT&T. System ten bazował na systemie Multics. W 1975 roku na uczelnie trafiła nieodpłatnie szósta wersja Unixa. Krok ten przyczynił się do rozwoju tego systemu operacyjnego. Na początku lat 80. AT&T skomercjalizowało Unixa. Decyzja ta spotkała się z krytyką ze strony inżynierów akademickich. W odpowiedzi na tę decyzję w 1983 roku Richard Stallman założył Free Software Foundation, która za główny cel obrała sobie opracowanie wolnego systemu uniksowego, pozbawionego kodu pochodzącego z AT&T[72].

Windows

W listopadzie 1985 roku Microsoft zaprezentował system operacyjny Windows 1.0. Pierwsze systemy tej wersji opierały się na systemie MS-DOS. Obsługa Windows 1.0. w dużej mierze polegała na użyciu myszy komputerowej. W wydanym dwa lata później Windowsie 2.0 wprowadzono możliwość nakładania okien na siebie; system był dostarczany wraz z edytorem tekstu Microsoft Word i arkuszem kalkulacyjnym Microsoft Excel. W 1990 roku na rynku pojawił się Windows 3.0, który wymagał dysku twardego. W sierpniu 1995 roku Microsoft wypuścił system Windows 95, w którym wprowadzono przycisk „Start”, funkcję „plug and play” i przeglądarkę Internet Explorer. W wydanym trzy lata później Windowsie 98 ulepszono obsługę USB, co przyczyniło się do powszechnego przyjęcia tego typu złącza. Ostatnim systemem opartym na MS-DOS był Windows ME[100].

Bliźniaczym systemem do Windows ME był Windows 2000, oparty na systemie Windows NT[100]. 25 października 2001 roku na rynku Microsoft wydał system Windows XP[101]. Cieszył się on bardzo dużą popularnością. W styczniu 2007 roku Microsoft zaprezentował system Windows Vista. W październiku 2009 roku wydano system Windows 7, uważany za dopracowaną wersję Visty. W wydanym w październiku 2012 roku Windowsie 8 porzucono przycisk „Start” na rzecz ekranu startowego dopasowanego do dotykowej obsługi. Powszechna krytyka zastąpienia „Startu” ekranem startowym zmusiła Microsoft do przywrócenia tej funkcję w Windowsie 8.1, wydanym 17 października 2013 roku[100][102]. Najnowszymi systemami Microsoftu są Windows 10 (wydany w lipcu 2015 roku)[103] i Windows 11 (wydany 5 października 2021 roku)[104].

Linux

We wrześniu 1991 roku Linus Torvalds zaprezentował pierwszą wersję systemu operacyjnego Linux[105]. Jest on kompatybilny z większością standardów Uniksa, lecz jego jądro zostało wzbogacone przez różne organizacje i firmy komercyjne[72]. System był dostępny bez opłat dla każdej zainteresowanej osoby, na licencji GNU General Public License[72][105].

Na przestrzeni lat powstały liczne dystrybucje Linuksa (w nawiasie data pierwszego wydania systemu)[106]:

- Slackware (1992)

- Debian (1993)

- Fedora (wrzesień 2004)

- Ubuntu (wrzesień 2004)

- Linux Mint (2006)

23 września 2008 roku na rynku pojawił się telefon G1 wyposażony w system operacyjny Android, system operacyjny z jądrem bazującym na Linuksie dla urządzeń mobilnych[107][105]. W kwietniu 2017 roku Android stał się najpopularniejszym systemem operacyjnym na świecie[108].

Remove ads

Historia informatyki w państwach bloku wschodniego

Podsumowanie

Perspektywa

W państwach zachodnich informatyka rozwijała się głównie za sprawą prywatnych firm. W bloku wschodnim rozwój informatyki był oparty na planach gospodarczych kontrolowanych przez organy administracji państwowej[109]. W ZSRR do lat 60. elektronikę i teorię informacji postrzegano jako nauki skażone ideologią kapitalistyczną[110]. W kontrolowanych przez ZSRR krajach Europy Wschodniej powstający przemysł komputerowy miał dogodniejsze warunki rozwoju. Choć początkowo elektronikę i informatykę postrzegano pod kątem ich zastosowania w celach wojskowych, tak na przestrzeni lat poszczególne rządy zaczęły dostrzegać komputeryzację jako ważny czynnik sprzyjający rozwojowi gospodarczemu państw komunistycznych[111].

Radziecki MESM był drugim programowalnym komputerem w Europie kontynentalnej. Następnie w ZSRR powstała Strela (do celów militarnych), seria BESM[112]. Pierwszym polskim komputerem był XYZ zbudowany w 1958 roku[113]. Poziom informatyzacji w Polsce w latach 60. był wyraźnie słabszy od Czechosłowacji i Niemieckiej Republiki Demokratycznej (NRD), które posiadały więcej komputerów przy mniejszej liczbie ludności[114]. W 1970 roku liczba pracujących komputerów w NRD wynosiła 360, w Czechosłowacji 300, a w Polsce 170[115]. W wyniku niewydolności gospodarki planowej i jej braku konkurencyjności oraz niewymielaności walut Rady Wzajemnej Pomocy Gospodarczej (RWPG) poziom komputeryzacji państw bloku wschodniego był wyraźnie słabszy od świata zachodniego. NRD i RFN prowadziły wyścig w dziedzinie technologii mikroelektronicznych, choć faktycznie NRD bezskutecznie próbowała dogonić RFN w tej dziedzinie[111].

W 1967 roku RWPG podjęła decyzję o wdrożeniu Jednolitego Systemu Elektronicznych Maszyn Cyfrowych (systemu RIAD) w komputerach produkowanych przez członków organizacji[116]. System RIAD zaczął być wdrażany przez większość państw RWPG w 1968 roku (w Polsce od 1969)[40][117]. Komputery w systemie RIAD korzystały z architektury logicznej i systemu operacyjnego IBM 360[118].

Remove ads

Sieci komputerowe

Podsumowanie

Perspektywa

Do czasu stworzenia pierwszej sieci komputery były traktowane głównie jako wydajne kalkulatory i maszyny do pisania[119]. 7 lutego 1958 roku w Departamencie Obrony Stanów Zjednoczonych powołano agencję ARPA (od 1996 znaną jako DARPA), która w 1969 roku utworzyła pierwsze połączenie czterech węzłów w ramach sieci ARPANET[120][121][122]. Był to eksperyment badający możliwości komunikacji między komputerami. Projekt szybko znalazł zastosowanie w ośrodkach naukowych, które potrzebowały technologii do błyskawicznej i taniej wymiany informacji[123]. W październiku 1969 roku uruchomiono sieć komputerową między Uniwersytetem Kalifornijskim w Los Angeles a odległym o 600 km Stanford Research Institute w Palo Alto[124]. W 1971 roku Ray Tomlinson stworzył program do przesyłania wiadomości elektronicznych[121][125]. W 1973 roku opracowano koncepcję Internetu oraz utworzono pierwsze połączenie sieciowe pomiędzy Ameryką Północną a Europą[121].

W 1974 roku opracowano standard komunikacyjny TCP/IP, który w 1975 roku wykorzystano testowo w komunikacji między dwoma sieciami: Stanfordu i University College London po czym w listopadzie 1977 roku z użyciem łączy satelitarnych połączono sieci w trzech lokalizacjach w USA, Wielkiej Brytanii i Norwegii[126][127].

Na początku lat 80. ARPANET podzielono na dwie sieci: wojskową i akademicką. Wojskowa pozostała przy dotychczasowej nazwie, akademicka przyjęła nazwę Internet i była rozwijana oddzielnie[128]. Ponadto w latach 80. powstawały nowe sieci (np. CSNET, EUNET, European Academic Research Network, BITNET), które z czasem dołączano[129][130].

W 1979 powstała tekstowa grupa dyskusyjna Usenet[121]. W 1981 roku Ted Nelson przedstawił koncepcję hipertekstowych zbiorów danych. Trzy lata później powstał system DNS – system tłumaczenia nazw przypisanych do komputerów na ich adresy w sieci wyrażone w cyfrach. W 1985 roku zarejestrowano pierwszą domenę: symbolics.com. Od 1988 roku rejestracją domen zajmowało się IANA (Internet Assigned Numbers Authority). W tym samym roku opracowano usługę sieciową Internet Relay Chat (IRC), umożliwiającą rozmowę poprzez kanały komunikacyjne. W 1990 roku Tim Berners-Lee rozpoczął pracę nad World Wide Web (WWW). Upowszechnienie usługi WWW nastąpiło rok później[121]. Pod koniec lat 90. upowszechnił się handel elektroniczny[123], a na rynku pojawiły się pierwsze komputery przenośne bezpośrednio połączone z Internetem[131]. W 2000 roku powstał standard Wireless Application Protocol, umożliwiający dostęp do Internetu z telefonu komórkowego[71].

W 1993 roku Marc Andreessen opracował przeglądarkę internetową NCSA Mosaic[132]. W tym samym roku Andreessen i James Clark założyli firmę Netscape, która w 1995 roku wydała przeglądarkę Netscape Navigator[133]. W 1994 roku Håkon Wium Lie opracował pierwszą wersję kaskadowych arkuszy stylów[134]. W lipcu 1995 roku Microsoft wydał przeglądarkę Internet Explorer. Wprowadzenie Internet Explorera do systemu operacyjnego Windows przyczyniło się do uzyskania przez Microsoft monopolu na przeglądarkę internetową[135]. Na początku XXI wieku stworzono kolejne przeglądarki internetowe, m.in. Firefox (2004), Safari (2003) i Google Chrome (2008). W 2015 roku Internet Explorer został zastąpiony przez Microsoft Edge[136].

W 1990 roku uruchomiono Archie, wyszukiwarkę plików dla usługi FTP. Cztery lata później David Filo i Jerry Yang stworzyli Yahoo!, pierwszy zbiór stron internetowych. 27 września 1998 roku Larry Page i Sergey Brin uruchomili wyszukiwarkę Google[137].

GAFAM

Około 2010 roku rynek został zdominowany przez cztery firmy komputerowe oferujące usługi zdalne: Google, Amazon, Facebook i Apple. Firmy te zaczęto określać akronimem GAFA[138][139]. W następnych latach do grupy zaczęto dołączać Microsoft, a sam akronim przekształcił się w GAFAM[140][141] (również GAMMA[142]). GAFAM wyróżnia się m.in. bardzo wysokimi zasobami finansowymi (wartość spółek w połowie 2021 roku wyniosła około 10 bilionów dolarów, co stanowiło równowartość łącznego produktu krajowego brutto Francji i Rosji[143]), przewagą technologiczną, dbałością o user experience, rozbudowaną bazą danych o klientach i stałą obecnością w mediach[144].

10 sierpnia 2015 roku Larry Page poinformował o powołaniu holdingu Alphabet. W skład przedsiębiorstwa weszły samo Google oraz jednostki zależne od niej[145]. 28 października 2021 roku spółka Facebook przyjęła nową nazwę Meta i zaprezentowała nowe logo[146]. W 2022 roku ok. 2,9 mld osób korzystało z Facebooka, 2 mld z serwisu YouTube, wchodzącego w skład Google, a 1,4 mld z systemów operacyjnych Microsoft Windows 10 i 11[147].

GAFAM jest krytykowana za naruszanie prywatności użytkowników[148], unikanie płacenia podatków[148][149], likwidację miejsc pracy[148] i działalność lobbingową[150]. Działalność poszczególnych firm bezskutecznie próbowały ograniczyć Australia oraz Komisja Europejska[151].

Remove ads

Superkomputery

W latach 60. XX wieku pojawiły się pierwsze superkomputery, urządzenia służące do znacznie szybszego działania na liczbach. Pierwszym modelem był procesor CDC 6600, skonstruowany w 1964 roku przez Seymoura Craya. W 1972 roku Cray założył przedsiębiorstwo Cray Research Incorporated, które zajmowało się produkcją superkomputerów[70]. W 1996 roku w Japonii skonstruowano komputer mogący wykonać 1,08 tryliona operacji matematycznych na sekundę[152]. 29 czerwca 2000 roku IBM skonstruował ASCI White służący do symulowania skutków wybuchów jądrowych[153].

Sztuczna inteligencja

Podsumowanie

Perspektywa

Rozwój maszyn imitujących ludzkie działania na początku XX wieku wywołał dyskusję o tym czy możliwe jest stworzenie sztucznego mózgu. W 1949 roku Edmund Callis Berkley wydał książkę pt. Gigantyczne mózgi, czyli maszyny, które myślą, gdzie porównał komputer do mózgu. Wzrost zainteresowania sztuczną inteligencją przypadł na lata 50. W 1950 roku Alan Turing w Computer Machinery and Intelligence zaproponował test inteligencji maszynowej. Dwa lata później Arthur Samuel napisał program samodzielnie uczący się gry w warcaby. W 1959 roku, podczas opowiadania o nauczaniu maszyny gry w szachy, Samuel wprowadził termin „uczenie maszynowe”[154]. Latem 1956 roku John McCarthy jako pierwszy użył terminu „sztuczna inteligencja”[155]. Do badań nad sztuczną inteligencją wykorzystano język programowania Lips (List Processing), opracowany w 1958 roku przez McCarthy’ego[154].

Pierwszym chatbotem (początkowo znanym pod nazwą „chatterbot”) był stworzony w 1966 roku przez Josepha Weizenbauma program ELIZA, parodiujący psychoterapeutę. Dwa lata później Ołeksij Hryhorowycz Iwachnenko przedstawił ideę uczenia głębokiego. W latach 70. w wyniku braku większego zainteresowania (m.in. ze strony rządów Stanów Zjednoczonych i Wielkiej Brytanii) rozwój sztucznej inteligencji został zahamowany. Ponowny wzrost zainteresowania nastąpił w latach 80. W Japonii uruchomiono projekt Komputerów Piątej Generacji, który miał zakończyć się stworzeniem komputerów potrafiących m.in. rozmawiać w języku ludzkim. W 1986 roku w Niemczech zaprezentowano pierwszy samochód bez kierowcy. Ponowny spadek zainteresowania sztuczną inteligencją miał miejsce w 1987 roku. Głównym powodem drugiego kryzysu były wysokie koszty w stosunku do niewielkiego zysku[154].

Ponowne zainteresowanie sztuczną inteligencją miało miejsce w 1993 roku. W latach 90. i na początku XXI wieku zaczęto wykorzystywać sztuczną inteligencję w życiu codziennym. Pojawiły się m.in. oprogramowanie rozpoznawania mowy na komputerach z systemem Microsoft Windows (1997), czy też robot sprzątający Roomba (2002)[154]. 11 maja 1997 roku mistrz świata w szachach Garri Kasparow przegrał pojedynek szachowy z superkomputerem Deep Blue, stworzonym przez IBM, z wynikiem 3½–2½ (poprzedni pojedynek z 1996 roku zakończył się zwycięstwem Kasparowa z wynikiem 4–2)[156][157]. Wysłane w 2003 roku przez NASA łaziki Spirit i Opportunity poruszały się po powierzchni Marsa bez udziału człowieka. W 2006 roku Twitter, Netflix i Facebook wprowadziły sztuczną inteligencję do algorytmów reklamowych. W 2010 roku na rynku pojawił się wyprodukowany przez Microsoft Xbox 360 Kinect. Był to pierwszy sprzęt do gier śledzący ruchy ciała i przekształcający je na polecenia w grach[154]. 4 października 2011 roku Apple wydał asystenta głosowego Siri[158]. W 2012 roku związani z Google Jeff Dean i Andrew Ng nauczyli sieć neuronową rozpoznawania kotów na obrazach[159].

27 listopada 2015 roku ponad 1000 sygnatariuszy (m.in. Elon Musk, Steve Wozniak i Stephen Hawking) podpisało otwarty list do rządów świata, apelując o zakazanie rozwoju broni autonomicznych[160]. W 2017 roku zaprogramowane przez Facebooka chatboty SI podczas swoich rozmów zaczęły rozwijać własny język całkowicie automatycznie. W 2020 roku OpenAI zaczęła testy nad chatbotem ChatGPT, modelem wykorzystującym uczenie głębokie do generowania treści[154]. Program został wydany 30 listopada 2022 roku[161]. Rok później OpenAI opracowało DALL-E pozwalający na tworzenie obrazów na podstawie zapytań w języku naturalnym[162].

Remove ads

Komputery kwantowe

W 1981 roku fizyk Richard Feynman ogłosił, że symulację procesu kwantowego można przeprowadzić wyłącznie za pomocą komputera kwantowego. Wówczas komputer kwantowy pozostawał wyłącznie problemem teoretycznym. Dalsze prace teoretyczne nad komputerem kwantowym prowadził David Deutsch[163]. Zainteresowanie komputerami kwantowymi ze strony rządów największych państw pojawiło się po opracowaniu przez Petera Shora kwantowego algorytmu służącego do rozkładu na czynniki pierwsze liczb naturalnych z wykorzystaniem komputera kwantowego. Algorytm umożliwia złamanie każdego szyfru cyfrowego, co mogłoby sparaliżować gospodarkę światową[164].

W 2019 roku Google rozpoczął pracę nad stworzeniem własnego komputera kwantowego. Ich pierwszym komputerem był Sycamore liczący 53 kubity[165]. W 2021 roku IBM ogłosił zbudowanie swojego pierwszego komputera kwantowego Eagle[166]. W 2022 roku największym komputerem kwantowym był Osprey IBM, liczący 433 kubity[167]. Prace nad komputerem kwantowym prowadzą również Chiny[167].

Remove ads

Zobacz też

Uwagi

- W źródłach można również natknąć się na informację, że twórcą dyskietki był Yoshirō Nakamatsu. Jego dyskietka miała zostać wynaleziona w 1950 roku[36] i zostać opatentowana dwa lata później[60]. Zdaniem samego Japończyka w 1979 roku IBM zawarło z nim szereg umów licencyjnych, by zapobiec konfliktom[60][61].

Przypisy

Bibliografia

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads