Timeline

Chat

Prospettiva

Internet

rete mondiale di reti di computer ad accesso pubblico Da Wikipedia, l'enciclopedia libera

Remove ads

Internet (raramente adattata in interrete[1]) è un'architettura di sistema che permette l'interconnessione tra diverse reti di computer a livello globale (internetwork).[2]

Il termine nasce, nell'ambito delle comunicazioni radio in tempo di guerra, come abbreviazione di "internet traffic", attestato già nel 1945[3]. Nel significato di interconnessione di terminali e computer appartenenti a reti diverse (internetwork, come acronimo di interconnected networks) si trova nell'RFC 675, Specification of Internet Transmission Control Protocol, pubblicato nel dicembre 1974.[4]

Solo dal 1991, sulla base dello specifico protocollo HTTP, si è cominciato a sviluppare il World Wide Web (WWW), successivamente diventato il protocollo predominante, fino a far confondere, nel linguaggio comune, il termine WWW con il termine "internet": per questo sempre più spesso quando si incontra il termine internet su letteratura non specialistica, in realtà si intende il WWW, uno dei maggiori mezzi di comunicazione di massa (assieme a radio e televisione),[5][6][7] grazie all'offerta all'utente di una vasta serie di contenuti potenzialmente informativi e di servizi.

Internet è l'interconnessione globale tra reti di telecomunicazioni e informatiche di natura e di estensione diversa, resa possibile da una suite di protocolli di rete comune chiamata "TCP/IP" dal nome dei due protocolli principali, il TCP e l'IP, che costituiscono la "lingua" comune con cui i computer connessi a Internet (gli host) sono interconnessi e comunicano tra loro a un livello superiore indipendentemente dalla loro sottostante architettura hardware e software, garantendo così l'interoperabilità tra sistemi e sottoreti fisiche diverse.

L'avvento e la diffusione di Internet e dei suoi servizi hanno rappresentato una vera e propria rivoluzione tecnologica e socio-culturale dagli inizi degli anni novanta (assieme ad altre invenzioni come i telefoni cellulari e il GPS) nonché uno dei motori dello sviluppo economico mondiale nell'ambito delle Tecnologie dell'Informazione e della Comunicazione (ICT).

In quanto rete di telecomunicazione, come diffusione è seconda solo alla rete telefonica generale, anch'essa di diffusione mondiale e ad accesso pubblico, ma ancora più "capillare" di Internet.

Remove ads

Storia

Riepilogo

Prospettiva

'

'

L'origine di Internet risale agli anni sessanta, su iniziativa degli Stati Uniti d'America, che misero a punto durante la guerra fredda un nuovo sistema di difesa e di controspionaggio.

La prima pubblicazione scientifica in cui si teorizza una rete di computer mondiale ad accesso pubblico è On-line man computer communication dell'agosto 1962, pubblicazione scientifica degli statunitensi Joseph Licklider e Welden E. Clark. Nella pubblicazione Licklider e Clark, ricercatori del Massachusetts Institute of Technology, danno anche un nome alla rete da loro teorizzata: "Intergalactic Computer Network".

Prima che tutto ciò cominci a diventare una realtà pubblica occorrerà attendere il 1991 quando il governo degli Stati Uniti d'America emana la High performance computing act, la legge con cui per la prima volta viene prevista la possibilità di ampliare, per opera dell'iniziativa privata e con finalità di sfruttamento commerciale, una rete Internet fino a quel momento rete di computer mondiale di proprietà statale e destinata al mondo scientifico. Questo sfruttamento commerciale viene subito messo in atto anche dagli altri Paesi.

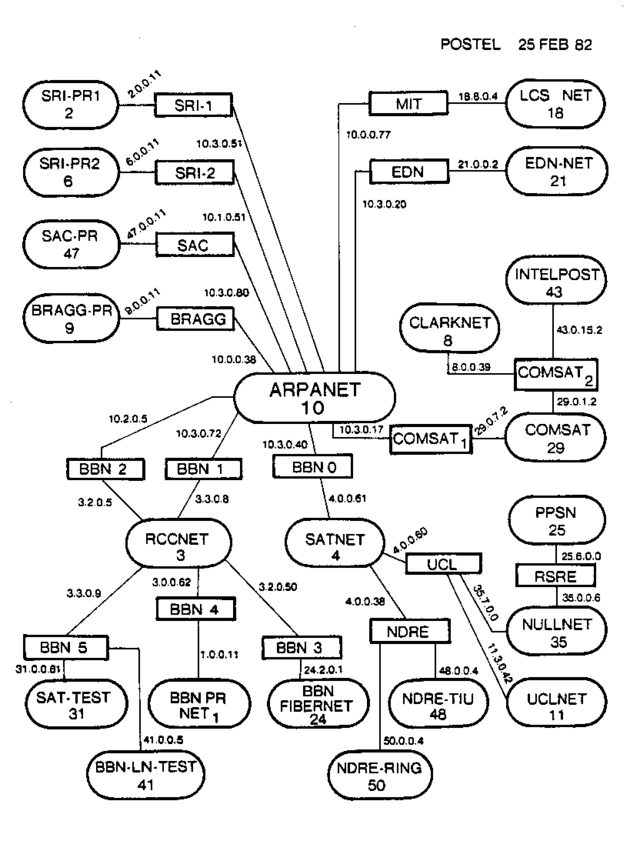

ARPANET (1969)

Il progenitore e precursore della rete Internet è considerato il progetto ARPANET, finanziato dalla Defence Advanced Research Projects Agency (inglese: DARPA, Agenzia per i Progetti di ricerca avanzata per la Difesa), un'agenzia dipendente dal Ministero della Difesa statunitense (Department of Defense o DoD degli Stati Uniti d'America). In una nota del 25 aprile 1963, Licklider aveva espresso l'intenzione di collegare tutti i computer e i sistemi di time-sharing in una rete continentale. Avendo lasciato l'ARPA per un posto all'IBM l'anno seguente, furono i suoi successori che si dedicarono al progetto ARPANET.

Il contratto fu assegnato all'azienda da cui proveniva Licklider, la Bolt, Beranek and Newman (BBN) che utilizzò i minicomputer di Honeywell come supporto. La rete venne fisicamente costruita nel 1969 collegando quattro nodi: l'Università della California di Los Angeles, l'SRI di Stanford, l'Università della California di Santa Barbara, e l'Università dello Utah. L'ampiezza di banda era di 50 kbps. Negli incontri per definire le caratteristiche della rete, vennero introdotti i fondamentali Request for Comments, tuttora i documenti fondamentali per tutto ciò che riguarda i protocolli informatici della rete e i loro sviluppi. La super-rete dei giorni nostri è risultata dall'estensione di questa prima rete, creata sotto il nome di ARPANET.

I primi nodi si basavano su un'architettura client/server, e non supportavano quindi connessioni dirette (host-to-host). Le applicazioni eseguite erano fondamentalmente Telnet e i programmi di File Transfer Protocol (FTP). Il servizio di posta elettronica fu inventata da Ray Tomlinson della BBN nel 1971, derivando il programma da altri due: il SENDMSG per messaggi interni e CPYNET, un programma per il trasferimento dei file. L'anno seguente Arpanet venne presentata al pubblico, e Tomlinson adattò il suo programma per funzionarvi: divenne subito popolare, grazie anche al contributo di Larry Roberts che aveva sviluppato il primo programma per la gestione della posta elettronica, RD.

Da Arpanet a Internet (anni settanta e ottanta)

In pochi anni, ARPANET allargò i suoi nodi oltreoceano, contemporaneamente all'avvento del primo servizio di invio pacchetti a pagamento: Telenet della BBN. In Francia si inizia la costruzione della rete CYCLADES sotto la direzione di Louis Pouzin, mentre la rete norvegese NORSAR permette il collegamento di Arpanet con lo University College di Londra. L'espansione proseguì sempre più rapidamente, tanto che il 26 marzo del 1976 la regina Elisabetta II spedì un'email alla sede del Royal Signals and Radar Establishment.

Le emoticon vennero istituite il 12 aprile 1979, quando Kevin MacKenzie suggerì di inserire un simbolo nelle mail per indicare gli stati d'animo.

Tutto era pronto per il cruciale passaggio a Internet, compreso il primo Denial of Service: il 27 ottobre 1980, un errore negli header di un messaggio si propagò su tutti i router (a quel tempo chiamati Interface Message Processor), portando rapidamente alla saturazione della rete e bloccando per ore l'accesso ad Arpanet[8][9][10][11]. Definendo il Transmission Control Protocol (TCP) e l'Internet Protocol (IP), DCA e ARPA diedero il via ufficialmente a Internet come l'insieme di reti interconnesse tramite questi protocolli.

Internet in Italia

L'Italia fu il quarto Paese europeo a connettersi in rete, dopo Norvegia, Regno Unito e Germania[12], grazie ai finanziamenti del Dipartimento della Difesa degli Stati Uniti. La connessione avvenne dal Centro Nazionale Universitario di Calcolo Elettronico presso l'Università di Pisa, dove era presente un gruppo di ricerca fra i più avanzati in Europa. Alcuni di questi componenti del gruppo avevano lavorato a contatto con quelli che poi sarebbero stati considerati i padri di Internet, Robert Kahn e Vinton Cerf. Fu proprio Kahn a convincere i suoi superiori a finanziare l'acquisto delle tecnologie necessarie (Butterfly Gateway) per il gruppo di Pisa[13]. Il collegamento avvenne il 30 aprile 1986, alle 18 circa[14].

Dopo quei primi esperimenti l'intera comunità dell'università e della ricerca decise di collaborare per la realizzazione di una rete unica, la rete GARR. Il progetto della rete GARR fu ideato nel 1986, il gruppo di lavoro venne istituzionalizzato come Commissione ministeriale del ministero della Ricerca Scientifica con un decreto dell’11 marzo 1988, nel 1989 il progetto ottenne il primo finanziamento ministeriale e all'inizio del 1991 la Rete GARR fu pienamente operativa.

Nascita del World Wide Web (1991)

Nel 1991 presso il CERN di Ginevra il ricercatore Tim Berners-Lee definì il protocollo HTTP (HyperText Transfer Protocol), un sistema che permette una lettura ipertestuale, non-sequenziale dei documenti, saltando da un punto all'altro mediante l'uso di rimandi (link o, più propriamente, hyperlink). Inoltre, il 6 agosto Berners-Lee pubblicò il primo sito web della storia, presso il CERN, all'indirizzo https://info.cern.ch/hypertext/WWW/TheProject.html[15]. Nel World Wide Web (WWW), le risorse disponibili sono organizzate secondo un sistema di librerie, o pagine, a cui si può accedere usando appositi programmi detti web browser con cui è possibile "navigare" visualizzando file, testi, ipertesti, suoni, immagini, animazioni e filmati. Il primo browser con caratteristiche simili a quelle attuali, il Mosaic, venne realizzato nel 1993.

Il 30 aprile 1993 il CERN decise di rendere pubblica la tecnologia alla base del World Wide Web in modo che fosse liberamente implementabile da chiunque. A questa decisione fece seguito un immediato e ampio successo del World Wide Web in ragione delle funzionalità offerte, della sua efficienza e della sua facilità di uso. Internet crebbe in modo esponenziale e in pochi anni riuscì a cambiare la società, trasformando il modo di lavorare e di relazionarsi. Nel 1998 venne introdotto il concetto di eEconomy.

La facilità d'uso connessa con l'HTTP e i browser, in coincidenza con una vasta diffusione di computer per uso anche personale[16], hanno aperto l'uso di Internet a una massa di milioni di persone, anche al di fuori dell'ambito strettamente informatico, con una crescita in progressione esponenziale.

Diffusione

Se prima del 1993 Internet voleva essere una rete dedicata alle comunicazioni all'interno della comunità scientifica e tra le associazioni governative e amministrative, da tale anno si assiste alla diffusione costante di accessi alla rete da parte di computer di utenti privati. All'inizio del 1995 i sistemi connessi a Internet nel mondo erano quasi 5 milioni, circa il doppio di un anno prima, e si stimava che permettessero l'accesso a circa 50 milioni di utenti.[17] Si arriva al 1998 con centinaia di milioni di computer connessi in rete in parallelo alla diffusione sempre più spinta di PC nel mondo, all'aumento dei contenuti e servizi offerti dal Web e a modalità di navigazione sempre più usabili, accessibili e user-friendly nonché a velocità di trasferimento dati a più alta velocità passando dalle connessioni ISDN alle moderne connessioni V.90 e a banda larga, quest’ultime tramite sistemi DSL. Questa è la situazione di diffusione di Internet nel mondo occidentale, mentre nel secondo e terzo mondo il tasso di penetrazione è inferiore, ma in continua crescita grazie al progressivo riammodernamento delle infrastrutture di reti di telecomunicazioni.

Internet nei primi anni 2000

Internet, nei primi anni 2000, è sinonimo di globalizzazione: possedere un sito internet significa possedere una vetrina sul mondo ovvero farsi conoscere dappertutto. Dicendo: "Vado su internet!" la gente afferma che intende visitare i siti del World Wide Web. È quindi più simile all'insieme delle entità che lo popolano, piuttosto che all'insieme delle reti di cui è costituito. È più simile alla definizione di insieme degli iperoggetti[18] di Tim Berners Lee: il WWW; cioè qualcosa di staccato dall'infrastruttura fisica che, invece, potrebbe subire modificazioni. Importantissima è la capacità dei browser di vedere internet dando la possibilità di interpretare il maggior numero di entità possibili.

Internet, Web, World Wide Web, WWW sono oggi trattati come sinonimi. Tanto è vero che i browser più diffusi permettono il raggiungimento del sito destinazione anche senza la digitazione del protocollo (http://) e del prefisso (www.). Ad ogni modo, internet e web rimangono specificatamente due cose diverse: seppur con qualche semplificazione, si può dire che "internet" è l'hardware, cioè la struttura, il web è il software, cioè il contenuto.

Evoluzione

Fino all'anno 2000 si è temuto di dover ricreare ex novo l'intera Internet perché il numero degli host indirizzabile attraverso il protocollo IP era vicino a essere esaurito (IP shortage) dal numero di host realmente collegati (oltre alla necessaria ridondanza e alle perdite per motivi sociali).

Il problema è stato parzialmente evitato (o posticipato) con l'uso della tecnica del NAT/gateway mediante la quale una rete aziendale non ha bisogno di un range ampio di indirizzi IP fissi, ma può utilizzarne uno più ridotto con anche un buon risparmio economico.

Oggi, come soluzione definitiva, si è fiduciosi nella possibilità di migrare in modo non traumatico alla versione successiva di IP (IPv6) che renderà disponibili 2128 nuovi indirizzi IP.[non chiaro]

I processi di convergenza in atto nell'ambito ICT, media e comunicazioni, indicano inoltre la sempre più probabile piena integrazione nel prossimo futuro della rete Internet con la rete telefonica già con la tecnologia VoIP, nonché la parallela fruizione di contenuti informativi tipici di altri mezzi di comunicazione come la televisione e la radio in un'unica grande rete.

Se infatti da una parte i primordi della rete sono stati caratterizzati dallo scambio di dati come i contenuti testuali e immagini statiche, l'evoluzione futura della rete va verso la sempre maggiore diffusione di contenuti multimediali come ad esempio i contenuti audio-video (es. streaming, Web Tv, IPTV, Web radio) che ne aumentano enormemente il traffico complessivo e il relativo carico sui nodi o sistemi interni di commutazione (router) e sui server, vuoi anche per l'aumento del numero di utenti connessi in rete al mondo. La soluzione più praticata a questo problema è la decentralizzazione delle risorse ovvero sistemi di rete distribuiti (es. Content Delivery Network) in grado di gestire l'aumento di traffico, mentre per far fronte all'aumento di banda necessaria sui collegamenti sono da menzionare nuove e più efficienti tecniche di compressione dati che hanno reso possibile il diffondersi di servizi sempre più evoluti e pesanti.

Sotto questo punto di vista l'evoluzione della rete dal punto di vista dei servizi richiede anche lo sviluppo di un'infrastruttura di rete di accesso a banda sempre più larga con la realizzazione delle cosiddette Next Generation Network per sopperire all'aumento di traffico previsto e la fruizione dei servizi stessi dall'utente finale. Gli stessi operatori che dovrebbero investire sulla realizzazione di tali infrastrutture richiedono però un ritorno certo dell'investimento ovvero una convenienza economica che risulterebbe invece molto più a favore dei grandi network o fornitori di servizi e contenuti di rete (Google, YouTube, Facebook, Twitter, LinkedIn, ecc.) sollevando così il problema della cosiddetta neutralità della rete o meno.

La natura globale con la quale è stata concepita Internet ha fatto sì che oggi, un'enorme varietà di processori, non solo apparati di calcolo in senso stretto, ma a volte anche incorporati in maniera invisibile (embedded) in elettrodomestici e in apparecchi dei più svariati generi, abbiano tra le proprie funzionalità quella di connettersi a Internet e, attraverso questo, a qualche servizio di aggiornamento, di distribuzione di informazione e dati; dal frigorifero, al televisore, all'impianto di allarme, al forno, alla macchina fotografica: ogni processore oramai è abilitato a comunicare via Internet. In tal senso dunque un'ulteriore evoluzione della Rete, propugnata da alcuni, potrebbe essere l'estensione della connettività agli oggetti taggati del mondo reale dando vita alla cosiddetta Internet delle cose.

Apprendimento online e didattica a distanza

La didattica a distanza (anche indicata con l'acronomo DAD) è una forma di didattica che avviene senza la presenza degli insegnanti e degli studenti in aula, avvalendosi piuttosto di strumenti online. Il termine si contrappone alla didattica in presenza, che è invece caratterizzata dalla presenza fisica degli studenti e degli insegnanti nelle aule.

Per apprendimento online (noto anche come apprendimento in linea, teleapprendimento, teledidattica o con il termine inglese e-learning) s'intende l'uso delle tecnologie multimediali e di Internet per migliorare la qualità dell'apprendimento facilitando l'accesso alle risorse e ai servizi, così come anche agli scambi in remoto e alla collaborazione a distanza[19].

Remove ads

Caratteristiche

Riepilogo

Prospettiva

Le caratteristiche della rete possono essere descritte attraverso la sua struttura fisica (topologia, nodi, collegamenti trasmissivi e apparati di rete), e attraverso il suo funzionamento a livello logico-protocollare.

La differenza tra Internet e il Web

Prima di esaminare le caratteristiche è utile fare una premessa: sebbene siano molto spessi utilizzati come sinonimi (anzi: si dice "Internet" quando occorrerebbe dire "Web"), Internet e il Web sono due concetti diversi. Sintetizzando e semplificando, si può dire che Internet è una determinata rete di computer (qui "computer" è usato in senso specialistico quindi andando ben oltre a ciò che è ritenuto "computer" dalla massa degli utilizzatori di tecnologia informatica) quindi è una struttura fisica. Invece, il Web rappresenta uno specifico servizio (uno dei tanti impiegabili tramite Internet) e, in dettaglio, è il servizio rappresentato da contenuti e informazioni fruibili mediante un browser su indirizzo http o applicazioni web. Il Web si appoggia a Internet.

Struttura fisica

Internet è costituita da miliardi di dispositivi collegati tra loro con i più svariati mezzi trasmissivi ed è anche la più grande rete di computer attualmente esistente, collegando tra loro a livello globale reti LAN, MAN e WAN, motivo per cui è definita "rete delle reti", "interete", "rete globale" o "la Rete" per antonomasia.

In generale a livello fisico la rete Internet può essere vista come una complessa interconnessione di nodi con funzionalità di ricetrasmissione, appoggiata a collegamenti trasmissivi di vario tipo, sia cablati sia wireless (fibre ottiche, cavi coassiali, doppini telefonici, cavi elettrici in posa anche in strutture idrauliche, collegamenti sottomarini, collegamenti satellitari, collegamenti a radiofrequenza (WiFi) e su ponti radio) che consentono l'interconnessione da estremo a estremo (end to end) di un agente umano o automatico a un altro agente, praticamente qualsiasi tipo di computer o elaboratore elettronico oggi esistente.

Ogni dispositivo terminale connesso direttamente a Internet si chiama nodo ospite, in inglese host o end system (sistema finale o terminale utente), mentre la struttura che collega i vari host si chiama link di comunicazione passando attraverso i vari nodi interni di commutazione. Da qualche anno è ormai possibile collegarsi a Internet anche da dispositivi mobili come palmari, telefoni cellulari, tablet, ecc. Sulla maggior parte dei dispositivi mobili è possibile non solo «accedere» a Internet, ma anche «subire l'accesso» da parte di altri host Internet.

In quanto "Rete delle reti" Internet non possiede dunque una topologia ben definita, ma mette insieme reti con topologie differenti.

La "ragnatela" di collegamenti è composta, a livello fisico-infrastrutturale, da un'ossatura molto veloce e potente nota come rete di trasporto. Essa comprende dorsali di rete a cui si connettono, attraverso collegamenti di backhauling (raccordo), reti private e sottoreti a volte più deboli e lente. Tale struttura rispecchia quella della rete telefonica, con la quale Internet condivide proprio l'infrastruttura di accesso per la connessione delle utenze private.

I collegamenti tra i vari nodi interni si appoggiano su criteri statistici di disponibilità (multiplazione statistica) e non su criteri totalmente deterministici, a causa della natura distribuita e aleatoria piuttosto che centralizzata dei processi in rete.

Molti nodi interni sono collegati tra loro in diversi modi e tramite diversi path (in inglese "sentiero", "percorso"). Questo tipo di interconnessione può essere compreso alla luce delle motivazioni che negli anni sessanta dettarono la nascita di Internet (allora denominata ARPANET): creare una rete di elaboratori decentrata che potesse resistere a un attacco nucleare da parte dell'Unione Sovietica. Una tale rete decentrata sarebbe sopravvissuta a molti attacchi visto che un attacco a un singolo elaboratore non avrebbe impedito il funzionamento generale, e i collegamenti ridondanti avrebbero sostituito quelli distrutti.

Le sottoreti componenti possono anche essere protette e, quindi, consentono l'accesso a Internet (e viceversa) solo in maniera condizionata. Si tratta delle Intranet e la protezione è tipicamente realizzata attraverso l'uso di un firewall (muro tagliafuoco in inglese).

La velocità di connessione o velocità di trasmissione in una comunicazione end to end tra due terminali è in ogni caso limitata dalle prestazioni più basse, in termini di velocità di trasferimento, della sottorete o del collegamento geografico attraversato, che fungono quindi da classico collo di bottiglia, e/o da eventuali situazioni di congestione interna della rete.

Gli ISP sono connessi a loro volta a ISP di livello superiore che usano router ad alta velocità e link fisici in fibra ottica nella rete di trasporto.

In molti Stati la possibilità di accesso a Internet da parte dell'utente viene vista sotto l'obbligo di servizio universale al pari della connessione alla rete telefonica.

Funzionamento logico: dalle reti locali all'Internet

Internet è costituita da tutta una serie di reti private, pubbliche, aziendali, universitarie e commerciali interconnesse tra di loro. In effetti, già prima della sua nascita, esistevano reti locali, principalmente nei centri di ricerca internazionali e nei dipartimenti universitari, che operavano ciascuna secondo modalità o protocolli propri di comunicazione

Il grande risultato della nascita e dell'affermazione di Internet è stata quindi la creazione di uno standard de facto da parte di ARPA tra i protocolli di comunicazione che, in aggiunta ai protocolli di rete locale, interoperasse e gestisse in maniera affidabile a un livello logico superiore tutte le varie reti interagenti, consentendo ai più diversi enti e agenti (governi, società nazionali o sovranazionali, dipartimenti universitari) di scambiarsi dati grazie a un protocollo comune, il TCP/IP, relativamente indipendente da specifiche hardware proprietarie, da sistemi operativi e dai formati dei linguaggi di comunicazione degli apparati di rete.

Dal punto di vista trasmissivo e informativo ciò che viaggia in Internet sono i pacchetti dati, che costituiscono l'unità minima di informazione in questo vasto sistema di comunicazione. Tali pacchetti viaggiano nei link e nodi interni di rete usando una tecnica di commutazione nota come commutazione di pacchetto che consente di condividere più di un possibile cammino piuttosto che fare uso di un percorso unico dedicato e fisso come accade invece nella classica commutazione di circuito della rete telefonica. In pratica i pacchetti dati di una comunicazione che viaggiano da un host all'altro non seguono percorsi di instradamento predefiniti, ma quelli più congeniali nel preciso momento di attraversamento in base alla disponibilità fisica di collegamento dei link della rete e/o alle condizioni di congestione della rete stessa. Di conseguenza i pacchetti di una stessa comunicazione possono seguire percorsi diversi verso lo stesso destinatario.

Per potersi collegare a Internet e usufruire dei relativi servizi, il solo requisito logico-funzionale necessario a un qualsiasi agente o dispositivo elettronico (tipicamente detto client) è quello di poter "dialogare" con il destinatario e i nodi interni di rete per mezzo di opportuni protocolli di rete che, nel caso in questione, fanno parte della cosiddetta suite di protocolli Internet, regolando opportunamente l'invio e la ricezione dei pacchetti informativi e implementando a livello software tutte le funzionalità richieste in una tipica architettura di rete a strati o livelli (layer).

I protocolli più importanti di tale suite, cioè quelli che garantiscono l'interoperabilità e il buon funzionamento tra le diverse sottoreti, sono il Transmission Control Protocol (Protocollo di Controllo di trasmissione dati, TCP), l'User Datagram Protocol (UDP) e l'Internet Protocol (Protocollo Internet, IP): il primo ha funzionalità di controllo di trasmissione, il secondo di inoltro semplice, il terzo ha funzionalità di indirizzamento/instradamento nei nodi interni di commutazione.

Come detto, la struttura della comunicazione è a strati (simile al modello di architettura ISO/OSI) in una pila o stack protocollare di 5 livelli dal livello fisico al livello applicativo: secondo tale struttura, il protocollo TCP o UDP occupa il livello superiore (livello di trasporto) rispetto a IP (livello di rete). Al di sopra di questi ci sono i protocolli di tipo applicativo connessi al particolare servizio richiesto da espletare, al di sotto ci sono i protocolli di trasporto tipici delle reti locali, metropolitane e geografiche da interconnettere, dei collegamenti di raccordo (backhauling) e di dorsale (backbone), altri ancora sono collocati al loro stesso livello.

In sostanza un pacchetto dati iniziale (payload) che parte a livello applicativo da un host attraversa verticalmente dall'alto al basso tutti i vari strati protocollari che aggiungono al pacchetto stesso, in una procedura detta di imbustamento, via via informazioni aggiuntive (header) in una struttura di informazioni di servizio (overhead); quando il pacchetto totale così ottenuto, una volta trasmesso a livello fisico sul mezzo trasmissivo, raggiunge la destinazione, ovvero viene ricevuto, avviene uno spacchettamento inverso dal basso verso l'alto e ogni livello legge e elabora le informazioni del rispettivo header.

Tale struttura logica di servizio si basa sugli Internet Standard sviluppati dall'Internet Engineering Task Force (IETF) con documenti rigorosamente approvati noti come Request for Comments ("Richiesta di commenti", RFC) e, a livello applicativo, dai protocolli del World Wide Web Consortium (W3C).

In particolare, dal punto di vista della fruizione di servizi di livello applicativo, l'architettura logica della rete Internet può essere di tipo client-server oppure peer-to-peer. Ciascun terminale o host di rete, per la sua raggiungibilità, è inoltre identificato da un indirizzo IP statico o dinamico (cioè assegnato manualmente dall'amministratore di rete o dal DHCP), mentre le risorse da fruire sono tipicamente presenti sui server, raggiungibili dal client sotto l'indicazione mnemonica fornita dal cosiddetto URL, grazie all'uso di un web browser e dei suddetti protocolli di rete forniti/implementati nel sistema operativo della macchina terminale in uso.

La conversione da indirizzo mnemonico URL a indirizzo IP, necessaria per l'instradamento effettivo in rete nei nodi di commutazione, è fornita dal cosiddetto DNS, mentre la comunicazione tra client e server si instaura in seguito alla definizione dei cosiddetti socket in cui oltre agli indirizzi IP di client e server vengono specificate anche le cosiddette porte coinvolte nel servizio di comunicazione da espletare.

Le modalità di uso di Internet differiscono a seconda del tipo di servizio che si richiede e al tipo di server a cui ci si collega; per citarne solo alcune:

- File Transfer Protocol ("Protocollo di trasferimento dati", FTP)

- consente di inviare e ricevere (a/da sistemi) file, cioè insiemi di informazioni codificate in maniera binaria (es.: testi, immagini, filmati, programmi, ecc.);

- Hypertext Transfer Protocol ("Protocollo di trasferimento ipertesti", HTTP)

- consente di organizzare le informazioni e le risorse presenti in rete in maniera non-sequenziale (collegamento ipertestuale), come meglio descritto in seguito.

- consente di inviare e ricevere (a/da utenti) messaggi contenenti testo e altri formati (es.: immagini, video, audio). La modalità di funzionamento dei server di posta elettronica e di molti programmi client viene detta store-and-forward;

Nata come rete di comunicazione dati tra utenti è diventata in seguito anche una rete per trasferimento di dati vocali grazie allo sviluppo della tecnologia VoIP.

Accesso

Per l'accesso alla rete Internet e la fruizione dei suoi molteplici servizi, chiunque disponga di un computer, di un modem e degli opportuni software oppure una rete locale da interconnettere attraverso un router, deve instaurare una connessione con l'Internet Service Provider (ISP), a seguito della stipulazione di un contratto di servizio, che gli fornisce un accesso attraverso una linea di telecomunicazione dedicata cablata o wireless (ADSL, HDSL, VDSL, GPRS, HSDPA, Wi-Fi, ecc.) o una linea telefonica della rete telefonica generale (POTS, ISDN, GSM, UMTS ecc.) e cominciare così la rispettiva sessione di navigazione attraverso l'uso di un web browser.

Principali servizi disponibili su Internet

Internet offre i più svariati servizi, i principali dei quali sono il World Wide Web e la posta elettronica, ed è usata per le comunicazioni più disparate: private e pubbliche, lavorative e ricreative, scientifiche e commerciali. I suoi utenti, in costante crescita, nel 2008 hanno raggiunto quota 1,5 miliardi e, visto l'attuale ritmo di crescita, si prevede che saliranno a 2,2 miliardi nel 2013.[20]

Le potenzialità teoriche in termini informativi e di servizi di Internet sono enormi; i principali servizi già attivi o di futura possibile applicazione sono:

- World Wide Web

- Motori di ricerca

- File Transfer Protocol (FTP)

- Hypertext Transfer Protocol (HTTP)

- Telnet

- Hosting

- Gopher

- Mailing list

- Newsgroup

- Podcast

- Chat

- Forum

- Blog

- Social network

- File hosting

- File sharing

- Video sharing

- Webcast

- Streaming o Web Tv

- IPTV

- Web radio

- VoIP

- Cloud computing

- Bitcoin

- Multiplayer

- Home banking

- E-Commerce

- E-Learning

- E-Government

- E-Democracy

- E-health

Principali enti di gestione

Remove ads

Problematiche della rete

Riepilogo

Prospettiva

Regolamentazione

Attualmente e sin dai suoi sviluppi al grande pubblico dalla metà degli anni '90 la rete Internet si è caratterizzata come una rete fondamentalmente "anarchica" cioè priva di regolamentazione effettiva ufficiale (ciascun utente può contribuire ai suoi contenuti secondo regole non sempre ben definite, chiare e omogenee).[21][22][23] Secondo altri la Rete rappresenta invece un esempio di libertà di espressione e democrazia globale dei tempi moderni e per questo da tutelare.[24][25] Tutto ciò rappresenta di fatto un punto cruciale che secondo alcuni critici dovrà essere risolto nell'immediato o prossimo futuro. In generale la ragione di tale condizione è da ricercare semplicemente nella natura e nelle finalità originarie di Internet come rete dati dedicata alla diffusione di documenti all'interno della comunità scientifica e delle organizzazioni e non pensata invece per scopi puramente pubblici.

L'impatto della tecnologia digitale sui valori e i principi costituzionali è definito costituzionalismo digitale.[26]

Sicurezza

Su Internet viaggiano tantissime informazioni non solo immagazzinate nei siti web, ma anche con e-mail, chatting, ecc. Sotto questo punto di vista Internet si caratterizza attualmente come una rete fondamentalmente ultrademocratica (o per alcuni anche al limite dell'anarchia ovvero scarsamente regolamentata) dove ciascun singolo utente può veicolare informazioni di qualunque tipo ai propri scopi e spesso in maniera del tutto anonima.

Tale fatto se da una parte rappresenta una delle ragioni principali del successo della rete come potente strumento di comunicazione di massa, dall'altra, ovvero nel rovescio della medaglia, evidenzia debolezze e vulnerabilità intrinseche dovute sostanzialmente al fatto che il "potere" è demandato al mittente e a chi eventualmente "controlla" la rete: molti sono infatti i tipi di attacco alla sicurezza informatica attuabili a mezzo della rete stessa da parte di pirati informatici (cracker) con intenzioni malevoli quali ad esempio attacchi di negazione del servizio e furto di dati personali dell'utente (password e codici di autenticazione, clonazione delle carte di credito, ecc.) nonché truffe dirette ai danni dei consumatori ad esempio tramite false e-mail.

Inoltre, essendo divenuto una forma di comunicazione di massa, Internet ha necessitato di diversi tentativi di filtraggio di parte delle informazioni veicolate o addirittura di controllo a fini di pubblica sicurezza. Uno dei programmi ampiamente riconosciuti è Carnivore, voluto dall'FBI per controllare la posta elettronica in entrata e in uscita alla ricerca di parole chiave di interesse. Per tutti questi motivi il filone della sicurezza informatica nell'ambito delle reti è molto attivo.

In Italia, sempre per motivi di sicurezza pubblica legati a norme antiterrorismo, il Decreto Pisanu dal 2006 imponeva l'obbligo agli utenti che volevano connettersi a Internet tramite rete Wi-Fi di registrarsi con le proprie credenziali di identità presso il gestore stesso della rete nonché la previa richiesta di autorizzazione alla questura da parte del gestore stesso per l'installazione della rete Wi-Fi connessa alla rete Internet. Questa restrizione, da molti vista come puramente burocratica, ha significato per molti un ostacolo alla diffusione di tale tipo di accesso a Internet rispetto ad altri paesi europei ed esteri in cui l'accesso tramite Wi-Fi era invece pienamente liberalizzato. Tale situazione è cambiata durante il governo Berlusconi IV, il quale non prorogando il decreto ha liberalizzato l'accesso Internet tramite Wi-Fi a partire dal 1º gennaio 2011, ma sul quale però restano aperti diversi interrogativi su quale sia il corretto iter da seguire per eventuali esercenti pubblici che volessero offrire un servizio WI-FI alla propria clientela.[27][28]

In senso opposto invece si muove la proposta di legge italiana dell'onorevole Gabriella Carlucci che anziché difendere l'anonimato su Internet sancisce l'impossibilità di caricare contenuti di ogni genere senza identificarsi e inoltre propone di espandere il reato di diffamazione ai contenuti digitali.[29]

Software maligno, noto anche come "software canaglia", è generalmente definito come un software distribuito attraverso reti, dispositivi di archiviazione portatili, ecc. e che provoca intenzionalmente malfunzionamenti non voluti e problemi di sicurezza delle informazioni, come la perdita di privacy o di informazioni riservate, danni al sistema (inclusi, ma non solo, crash di sistema, ecc.), perdita di dati, ecc. su personal computer, server, dispositivi intelligenti, reti di computer, ecc. e cerca di impedire agli utenti di rimuoverli in vari modi, proprio come "canaglie". Il termine "malware" si riferisce generalmente al software distribuito tramite reti, dispositivi di archiviazione portatili, ecc. e che provoca intenzionalmente malfunzionamenti indesiderati e problemi di sicurezza delle informazioni, come la fuga di informazioni riservate o sulla privacy, danni al sistema (inclusi, ma non solo, crash del sistema, ecc.), perdita di dati e tentativi di impedire agli utenti di rimuoverlo in vari modi, come se fosse una "canaglia".[30] Il malware può assumere la forma di eseguibili binari, script, contenuti attivi, ecc.[31] Per definizione, i virus informatici, i worm informatici, i cavalli di Troia, i ransomware, gli spyware, gli scareware, i software che sfruttano le vulnerabilità e persino alcuni adware sono inclusi nella categoria dei malware. Tuttavia, i malfunzionamenti non intenzionali e non voluti delle apparecchiature informatiche sono generalmente considerati come fetori del software.

Privacy

D'altra parte l'intercettazione e il filtraggio dei dati personali degli utenti da parte degli ISP o dei maggiori network di rete a scopo di ricerche di mercato pone oggi anche il problema della privacy dell'utente in Rete.[32]

Monitoraggio

PRISM (programma di sorveglianza)

Negli Stati Uniti, il programma di sorveglianza elettronica top-secret, condotto dal 2007 dalla National Security Agency (NSA), può ascoltare gli utenti al di fuori degli Stati Uniti o qualsiasi cittadino americano che comunichi all'estero. Snowden, ex dipendente della CIA, ha copiato i file nel maggio 2013, si è recato a Hong Kong e ha reso pubblico il programma prima di renderlo pubblico il 6 giugno 2013 su The Guardian (Regno Unito) e The Washington Post (Stati Uniti)

Copyright

Non solo si vuole controllare Internet perché mezzo di comunicazione di massa, ma anche per il fatto che esistono dei sistemi di scambio peer-to-peer che veicolano file protetti da diritto d'autore. Le case discografiche hanno cercato in tutti i modi di sostenere le proposte che suggerivano un controllo della rete a discapito del diritto di anonimato e della libertà personale. Un esempio è il tentato avviamento in Francia di una proposta di legge che avrebbe permesso agli ISP di togliere la connessione a Internet agli utenti che praticassero condivisione dei file protetti da copyright (dopo due avvertimenti), ma il decreto voluto da Nicolas Sarkozy ha perso la maggioranza dopo l'approvazione della relazione sul rafforzamento della sicurezza e delle libertà fondamentali su Internet di Stavros Lambrinidis, il 26 marzo 2009, all'Unione europea, che esprimeva una posizione forte in difesa della libertà d'espressione che in Internet vede la sua piena realizzazione.

Neutralità della rete

Al crescere dei servizi offerti dalla rete si è fatto strada l'ampio dibattito in merito alla network neutrality tra chi (gli utenti) vorrebbe una rete completamente trasparente nella fruizione di contenuti e servizi e chi (gli operatori di rete) vorrebbe un maggior controllo e selezione dei contenuti stessi impedendo la libera proliferazione di chi si appoggia sulle infrastrutture di rete per diffondere il proprio marketing e il proprio business ovvero i principali network o fornitori di servizi web (Google, YouTube, Facebook, Twitter, LinkedIn, ecc.).

Pubblicità

Internet si sta sempre più affermando anche come canale pubblicitario, promozionale e commerciale. I suoi vantaggi sono dati dalla possibilità di effettuare quasi dei collegamenti virtuali one-to-one a costi estremamente competitivi.; Al giorno d'oggi, Internet è sostenuta e mantenuta da un milione di imprese commerciali,[33] innumerevoli sono ormai i siti web di grandi e piccole medie imprese, nonché portali di e-commerce. Forte e in crescita è inoltre il ricorso della pubblicità direttamente sulla posta elettronica degli utenti fino al caso limite di spam.

Tutela dei minori

La sempre più facile accessibilità alla rete e ai suoi contenuti liberi da parte di un pubblico/utenti minorenni, progressivamente sempre più giovani, pone il problema della loro tutela di fronte a pericoli e rischi che l'anonimato e la vastità dei contenuti della rete può offrire nei loro confronti (es. pedofilia, pornografia, cyberbullismo, ecc.). Strumenti di filtraggio dei contenuti, opportunamente impostati (es. firewall), sono tuttavia disponibili da tempo nei vari sistemi informatici connessi come possibile rimedio al problema.

Internet dipendenza

Un altro problema che si è affacciato nel contesto della Rete, in merito ad un uso sempre più largo, è l'Internet dipendenza, un aspetto di dipendenza psicologica, attualmente molto dibattuto, compreso all'interno della dipendenza dalle tecnologie digitali.

Secondo i dati del rapporto annuale del 22 maggio 2012 di Mechthild Dyckmans, responsabile del dipartimento per le dipendenze patologiche del governo federale tedesco sono circa 250.000 le persone tra i 14 e i 24 anni che soffrono da dipendenza da internet, e altre 1,4 milioni sono considerate internauti problematici.

Nel 2017 è stata istituita la prima giornata mondiale sulle dipendenze tecnologiche e il cyberbullismo.

Inibizione dei processi cognitivi e di apprendimento

Secondo lo psichiatra e neuroscienziato Manfred Spitzer,[34] sono stati effettuati diversi studi[35] per verificare se l'uso delle nuove tecnologie informatiche, migliorino le capacità di studio e apprendimento, che hanno portato a conclusioni negative soprattutto nei confronti dei giovani.

Propaganda, disinformazione e raccolta dei dati

L'espressione in lingua inglese fake news e in italiano "false notizie", "notizie fasulle",[36] o ancora "pseudonotizie"[37][38], indica articoli o pubblicazioni su reti sociali redatti con informazioni inventate, ingannevoli o distorte,[39] resi pubblici con il deliberato intento di disinformare o di creare scandalo attraverso i mezzi di informazione. Dopo la nascita di Internet il termine, nell'immaginario collettivo, è spesso collegato alla Rete.

In statistica e informatica, la locuzione inglese big data ("grandi [masse di] dati", o in italiano "megadati"[40]) indica genericamente una raccolta di dati informativi così estesa in termini di volume, velocità e varietà da richiedere tecnologie e metodi analitici specifici per l'estrazione di valore o conoscenza. Il termine è usato dunque in riferimento alla capacità (propria della scienza dei dati) di analizzare ovvero estrapolare e mettere in relazione un'enorme mole di dati eterogenei, strutturati e non strutturati (grazie a sofisticati metodi statistici e informatici di elaborazione), allo scopo di scoprire i legami tra fenomeni diversi (ad esempio correlazioni) e prevedere quelli futuri.

Diritto all'oblio

Con la locuzione "diritto all'oblio" si intende, in diritto, una particolare forma di garanzia che prevede la non diffusione, senza particolari motivi, di informazioni che possono costituire un precedente pregiudizievole dell'onore di una persona, per tali intendendosi principalmente i precedenti giudiziari di una persona.

In base a questo principio non è legittimo, ad esempio, diffondere informazioni relative a condanne ricevute o, comunque, altri dati sensibili di analogo argomento, salvo che si tratti di casi particolari ricollegabili a fatti di cronaca. Anche in tali casi la pubblicità del fatto deve essere proporzionata all'importanza dell'evento e al tempo trascorso dall'accaduto. Le leggi che regolamentano il diritto all'oblio si applicano esclusivamente alle persone fisiche e non alle aziende.

Diritto di accesso a Internet

Nel 2001 l'ONU riconosce l'accesso a internet come diritto civile.[41]

Critiche

Molti degli aspetti controversi di internet sono stati discussi da autori come: Evgeny Morozov, Jaron Lanier, Andrew Keen, Nicholas Carr, Dave Eggers, Geert Lovink.

Consumo energetico

Internet ha un forte impatto ambientale.[42][43] Le stime dell'uso di energia elettrica di Internet sono state oggetto di controversia: secondo un documento di ricerca in revisione paritaria del 2014 che ha analizzato diverse affermazioni tra 20 000 opere pubblicate in letteratura durante il decennio precedente, vanno da 0,0064 kilowatt all'ora per gigabyte trasferito (kWh/GB) a 136 kWh/GB. I ricercatori hanno attribuito queste discrepanze principalmente all'anno di riferimento (cioè se sono stati presi in considerazione i guadagni di efficienza nel tempo) e al fatto che "i dispositivi finali come personal computer e server siano inclusi" nell'analisi.[44]

Nel 2011 i ricercatori accademici hanno stimato che l'energia complessiva assorbita da Internet sia compresa tra 170 e 307 GW, meno del due percento dell'energia usata dall'umanità. Questa stima includeva l'energia necessaria per costruire, far funzionare e sostituire periodicamente i 750 milioni di laptop stimati, un miliardo di smartphone e 100 milioni di server in tutto il mondo, nonché l'energia di router, celle radio, interruttori ottici, trasmettitori Wi-Fi e i dispositivi Cloud usati durante la trasmissione del traffico Internet.[45][46] Secondo uno studio non sottoposto a revisione paritaria pubblicato nel 2018 da The Shift Project (un think tank francese finanziato da sponsor aziendali), quasi il 4% delle emissioni globali di CO2 potrebbe essere attribuito al trasferimento di dati globali e alla relativa infrastruttura necessaria al trasferimento.[47] Lo studio ha anche affermato che lo streaming di video online da solo ha rappresentato il 60% di questo trasferimento di dati e quindi ha contribuito a oltre 300 milioni di tonnellate di emissioni di CO2 all'anno, e ha sostenuto nuove norme sulla "sobrietà digitale" che limitano l'uso e le dimensioni di file video.[48]

Censura

Le opinioni sul tema della censura di Internet sono variegate, essendoci argomenti sia a favore che contro di essa.[49] Inoltre, il livello di censura di Internet varia da paese a paese: mentre in alcuni essa è praticamente assente, in altri (come ad esempio Iran[50] e Cina[51][52]) può arrivare perfino a limitare l'accesso alle notizie e reprimere la discussione tra i cittadini sul web.[53] La censura di Internet si verifica anche in risposta o in previsione di eventi come elezioni, proteste e rivolte. Ad esempio, in Tunisia ed Egitto la cyber-censura "è viva e sta bene" in seguito alla primavera araba.[54]

Remove ads

Utenti

Riepilogo

Prospettiva

Agli inizi sembrava che la Rete fosse destinata a una partecipazione essenzialmente maschile, nel 2002 per la prima volta le donne online hanno superato gli uomini.

In uno studio americano del 2005 infatti, la percentuale di uomini che usava Internet era leggermente superiore alla percentuale di donne, sebbene questa differenza si sia invertita in quelle sotto i 30 anni. Gli uomini si collegavano più spesso, trascorrevano più tempo online e avevano maggiori probabilità di essere utenti della banda larga, mentre le donne tendevano a sfruttare maggiormente le opportunità di comunicazione (come la posta elettronica). Gli uomini erano più propensi a usare Internet per pagare i conti, partecipare alle aste e per attività ricreative come scaricare musica e video. Uomini e donne avevano la stessa probabilità di usare Internet per acquisti e operazioni bancarie. Altri studi indicano che nel 2008 le donne erano significativamente più numerose degli uomini nella maggior parte dei servizi di social networking, come Facebook e Myspace, sebbene i rapporti variavano con l'età. Inoltre, le donne hanno guardato più contenuti in streaming, mentre gli uomini ne hanno scaricati di più. In termini di blog, gli uomini erano più propensi ad usarli in primo luogo; tra coloro che ne avevano un blog, gli uomini avevano maggiori probabilità di avere un blog professionale, mentre le donne avevano maggiori probabilità di avere un blog personale[55][56][57].

L'età media dei fruitori nel 2014 risultava attorno ai quarantaquattro anni.[58]. Nel 2019, un terzo degli utenti online in tutto il mondo aveva un'età compresa tra i 25 e i 34 anni. Gli utenti in questa fascia di età costituivano il più grande gruppo di utenti online al mondo. Inoltre, il 18% degli utenti online globali aveva un'età compresa tra i 18 e i 24 anni[59].

Remove ads

Note

Bibliografia

Voci correlate

Altri progetti

Collegamenti esterni

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads